1)显示目录信息(-ls)

hadoop fs -ls /

1)在 HDFS 上创建目录(-mkdir)

普通创建:hadoop fs -mkdir /xiaolin

递归创建:hadoop fs -mkdir -p /xiaolin/xiaoyin

2)从本地剪切文件粘贴到 HDFS 上(-moveFromLocal)

mkdir xuan.txt

hadoop fs -moveFromLocal xuan.txt /xiaolin

3)把本地文件复制到 HDFS 上(-copyFromLocal 或者 -put)

hadoop fs -copyFromLocal xuan.txt /

hadoop fs -put xuan.txt /

- 文件名称相同时覆盖hdfs上的文件:

-f

hadoop fs -put -f xuan.txt /

4)从 HDFS 复制文件到本地上(-copyToLocal 或者 -get)

hadoop fs -copyToLocal /xiaolin ./

hadoop fs -get /xiaolin ./

5)在 HDFS 里拷贝文件路径到另一个路径上(-cp)

hadoop fs -mkdir /xiaona

hadoop fs -cp /xiaolin/xuan.txt /xiaona/

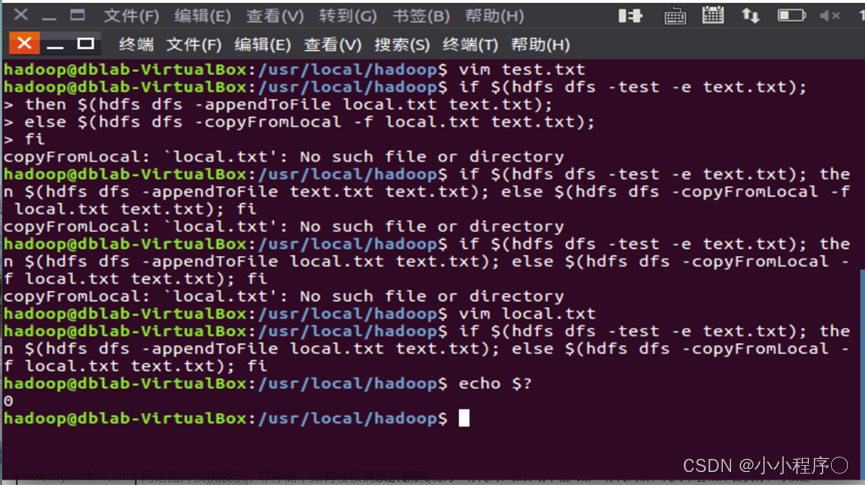

6)追加文件到 HDFS 里的文件末尾(-appendToFile)

vim zero.txt

hadoop fs -appendToFile zero.txt /xiaolin/xuan.txt

7)显示文件内容(-cat)

hadoop fs -cat /xiaolin/xuan.txt

8)修改文件所属权限(-chmod)

hadoop fs -chmod 777 /xiaolin/xuan.txt

9)移动文件(-mv)

hadoop fs -mv /xiaolin/xuan.txt /xiaolin/xiaoyin

10)从 HDFS 里合并下载多个文件到本地(-getmerge)

hadoop fs -getmerge /xiaolin/* ./

11)删除文件或文件夹(-rm)

hadoop fs -rm /xiaolin/xiaoyin

12)设置 HDFS 中文件的副本数量(-setrep)

hadoop fs -setrep 5 /xiaolin/xuan.txt

13)查看 HDFS 目录数据量(-du)

Usage:hdfs dfs -du [-s] [-h] URI [URI …]

-s选项将显示文件长度的汇总摘要,而不是单个文件。

-h选项将以“人类可读”的方式格式化文件大小(例如64.0m而不是67108864)

14)创建一个零长度的文件(-touchz)

hdfs dfs -touchz URI [URI …]

15)显示文件所占块数(-stat)

Usage:hdfs dfs -stat URI [URI …]

(%b),文件名(%n),块大小(%n),复制数(%r),修改时间(%y%Y)

16)显示文件的最后1kb内容到标准输出(-tail)

Usage:hdfs dfs -tail [-f] URI

17)统计与指定文件模式匹配的路径下的目录文件和字节数(-count)

Usage: hdfs dfs -count [-q] [-h] < paths>文章来源:https://www.toymoban.com/news/detail-448809.html

18)从 HDFS 上过滤包含某个字符的行内容(-grep)

Usage:hdfs dfs -cat < srcpath> | grep 过滤字段文章来源地址https://www.toymoban.com/news/detail-448809.html

到了这里,关于【Hadoop-HDFS】HDFS常用操作命令的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!