作为计算机行业的从业人员,程序员常常需要使用各种工具来辅助其工作。其中,爬虫广泛应用于数据收集和采集任务,因此程序员通常喜欢使用爬虫作为快速数据获取工具。本文将讨论程序员为何喜欢使用爬虫、在哪些情况下使用爬虫以及如何使用爬虫进行数据采集。

为什么程序员喜欢使用爬虫?

自动化数据获取

在大多数情况下,人工收集数据是非常耗时且费力的。使用爬虫可以自动化这个过程,并节省大量时间。鉴于程序员大多守时,习惯追求高效,这也是他们喜欢使用爬虫的理由之一。

数据的大规模分析

在很多情况下,我们需要处理大量数据以便分析。手动收集数据不仅费时费力,而且可能会产生错误。使用爬虫可以更快地收集到大量数据,这使得分析更加容易,同时也是改进数据分析和提升数据科学水平的好方式。

快速响应变化的数据源

从互联网上收集数据时,数据源可以随时发生变化。有些网站或API会频繁地更新数据,例如金融市场和天气预报等内容。通过使用爬虫,程序员能够及时收集并处理这些变化的数据,并相应快速更改其它数据处理工作流程。

数据格式的多样性

爬虫可以自动解析多种类型的数据格式,如HTML、XML、JSON以及CSV等。在数据采集中用到的各种不同的网站和服务通常都使用不同格式的数据。但是,由于许多编写爬虫程序的程序员熟悉多种开源框架,因此他们能够轻松解析这些数据格式。

在哪些情况下使用爬虫?

数据研究与分析

在数据科学领域,掌握大量高质量的数据是非常关键的。使用爬虫可以方便地获取需要的数据,从而进行各种类型的数据研究和分析。例如,对于某项产品,用户搜索的频率和特定功能的使用情况等,在获取足够数量可靠数据后,使用爬虫就避免了人为性数据异常的可能。

竞品情报收集

如果您正在积极开发新产品或服务,那么不了解您的竞争对手会让您输得很凄惨。使用爬虫可以检索并收集关于竞争对手的相关信息,例如他们的价格、宣传和市场营销策略等。

媒体监控

媒体监控是对特定事件或议题的报道所进行的实时跟踪。通过使用爬虫搜索流行的新闻网站,并收集特定事件或话题的相关内容,可以在短时间内获得大量信息并便于分析,特别是在舆情分析、政治大事和企业活动等领域中显得格外重要。

如何使用爬虫进行数据采集?

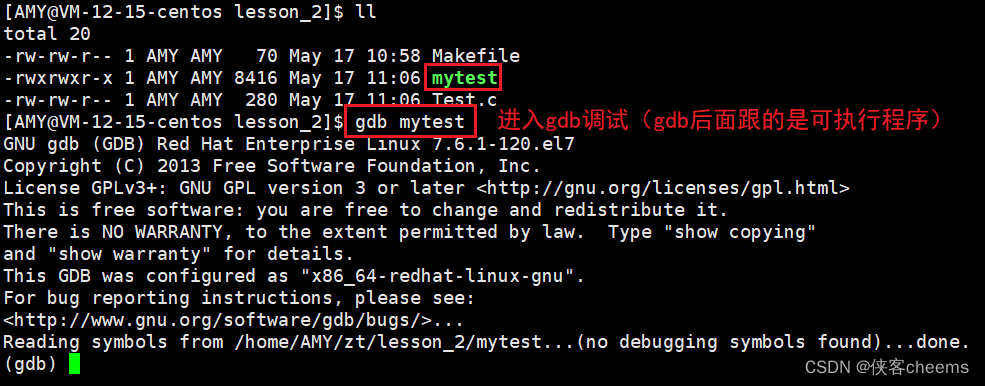

监测你的目标网站

在使用爬虫之前,了解你的目标网站00及其API的工作原理、基本数据格式和良好的开发者套餐。 在收集数据并非一个追求多而杂乱的目标,其目标为准确、有用的数据收集需质掌控热点和研究技术,出于安全考虑,爬虫解析需要规范化地运行指导。文章来源:https://www.toymoban.com/news/detail-449454.html

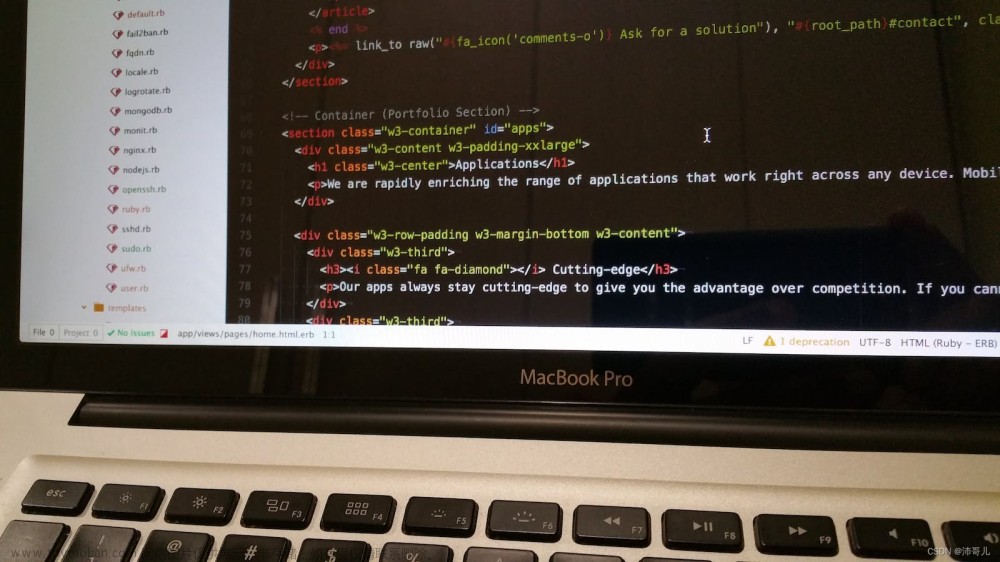

选择合适的爬虫框架

需要选择合适的爬虫框架以收集所需数据。这些框架通常会提供具备数据采集任务的插件,其中包括数据存储、响应速度和爬虫程序的管理和维护等内容。一些常用的爬虫框架还支持Web浏览器控制。文章来源地址https://www.toymoban.com/news/detail-449454.html

到了这里,关于程序员都喜欢怎么使用爬虫?的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!