(零)前言

关于Stable-Diffusion WEBUI,我发现网上各种教程真的很多。

写得很好很详细的也不少,读了感觉比我写的好多了,无论是原理和相关论文还是操作和细节。

所以准备记录下Stable-Diffusion WEB UI的方方面面,以及哪里去看相关的资料。

同时自己写的东西也有点乱,得整理一下。呃在整理完以前,本篇还是会包含不少具体的内容。

这篇Index应该会不断的补充。

(0.1)我的相关文章索引

-

🔗浅谈【Stable-Diffusion WEBUI】(AI绘图)的基础和使用

-

生成控制:🔗插件-骨骼姿态(OpenPose) ➕ 🔗插件-ControlNet 1.1 新版 ➕ 🔗插件-面部修复 ➕ 🔗分区域提示词

-

界面翻译:🔗插件-界面与中文翻译 ➕ 🔗插件-神奇离线自动翻译中文提示词

-

扩展功能:🔗画布扩绘 ➕ 🔗批量替换人脸 ➕ 🔗过程动画输出 ➕ 🔗作品艺术AI评分 ➕ 🔗不健康内容过滤

-

抠图放大:🔗附加功能-图片缩放&抠图 ➕ 🔗插件-超分辨放大StableSR

-

模型相关:🔗复刻属于你的女神:再谈模型与参数 ➕ 🔗训练自己的LoRA模型

-

模型相关:🔗细数模型:谁是最适合的模型&从哪里找到它们 ➕ 🔗模型对应的VAE ➕ 🔗模型工具箱插件

-

模型相关:🔗管好大量的模型:名称+预览图+备注+分组管理 ➕ 🔗Part2 ➕ 🔗Part3

配合DFL:

- 🔗【Stable-Diffusion】和【DeepFaceLab】配合:事半功倍……

编程API:

- 🔗关于【SD-WEBUI】的API:开发代码示例和帮助文档

配合Photoshop:

- 🔗关于Photoshop中的【Stable-Diffusion WEBUI】插件:Auto.Photoshop.SD.plugin

(0.2)本篇内容阅读提示

- 我想画更好看:适合的模型,好的提示词,合理的参数。

- 我要更多风格:(下载)更多的基础模型,LoRA模型。

- 我要画我自己:训练自己的模型(训练自己的画风)。

- 我的模型好么:可选附加网络(LoRA插件),对比模型/权重参数等。

- 生成高分辨率:附加功能,插件:缩放。

- 更好控制细节:插件:ControlNet。

(一)绘图

(1.1)模型

已经合并入:

🔗浅谈【Stable-Diffusion WEBUI】(AI绘图)的基础和使用

(1.2)绘图方式(文生图)

已经合并入:

🔗浅谈【Stable-Diffusion WEBUI】(AI绘图)的基础和使用

(1.3)插件:可选附加网络(LoRA插件)(Additional networks)

⭐需要在WEBUI中安装插件。

用于对比各种参数/模型生成图的不同效果(平时主要用于测试模型)参考:

🔗关于【SD-WEBUI】的LoRA模型训练:怎样才算训练好了?文章来源:https://www.toymoban.com/news/detail-449721.html

(1.4)插件:ControlNet

⭐需要在WEBUI中安装插件。

🌟需要下载多个不同模型。

💡插件版本升级较大,相关内容请参考:

🔗探索【Stable-Diffusion WEBUI】的插件:ControlNet 1.1

配合ControlNet,可用骨骼姿态的插件来生成/编辑骨骼姿态图片,控制最终生成的图像中人物的动作:

可以参考这篇:

🔗探索【Stable-Diffusion WEBUI】的插件:骨骼姿态(OpenPose)

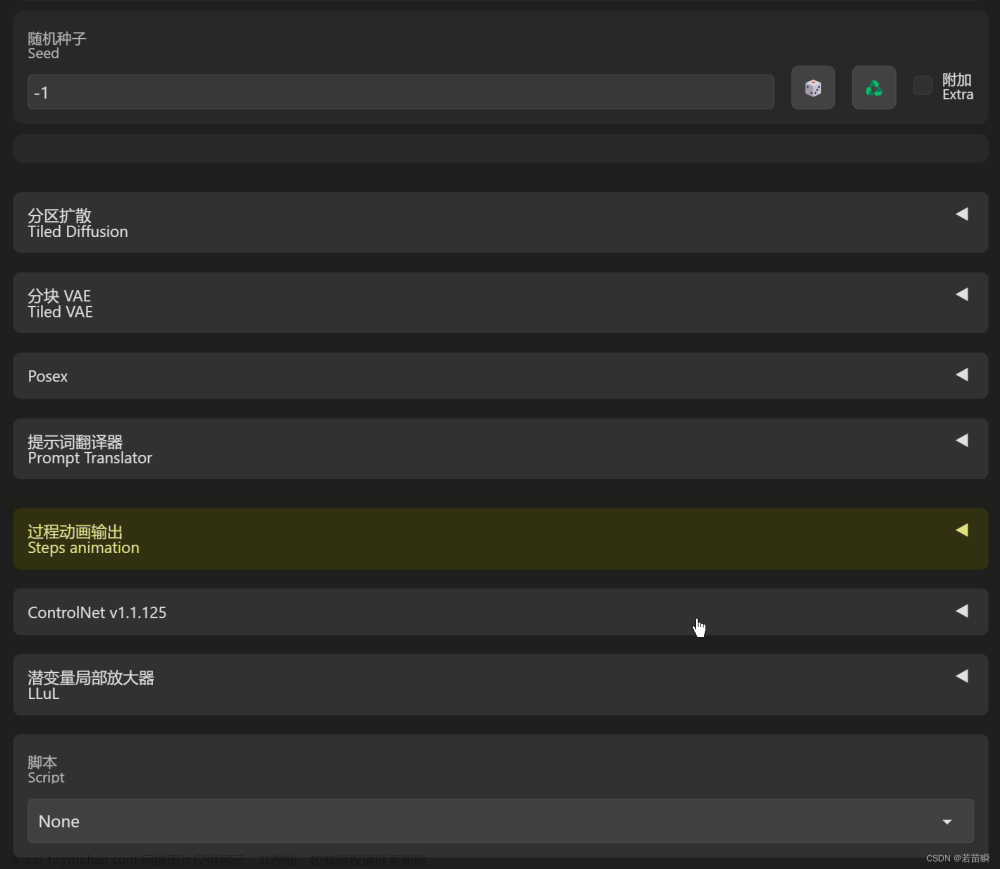

(1.5)脚本(Script)

-

x/y/z图表

我只用过【x/y/z图表】,可以配合上面的可选附加网络,生成对比矩阵图片,一般用来测试模型。

但自己观察到的对比图,和实际输出的模型参数组合,似乎有偏差,目前仅作参考吧。 -

Controlnet-M2M

可以配合ControlNet把视频进行逐帧处理,最后形成一个GIF动图,参考:……制作跳舞小姐姐 m2m和mov2mov哪家强……

有意思的是,连你选的ControlNet模型生成的中间图,也做成动画了。。。

脚本可以通过安装插件扩充。

(1.6)绘图方式(图生图)

大部分设置和上面文生图一样,只是需要从某张已有的图片出发,可以:

- 参考已有的图片生成新的图片(图生图)。

- 从涂鸦开始生成新的图片。

- 修改图像部分内容(局部重绘)。

其实 局部重绘 功能特别有用,也特别好玩。

比如出了一张很满意的图,但是小部分画错了)。

比如去掉草坪上不和谐的石块。

比如让主角出现在任何可以重绘的场景中。

相对局部重绘,还有画布扩绘(脑补图片外围内容)。

甚至有【无限缩放视频】插件。参考:

🔗探索【Stable-Diffusion WEBUI】的插件:画布扩绘(Outpaint)

(1.7)图片处理(附加功能:放大/抠图等)

文生图/图生图以外的功能。

为了避免索引过长,这部分内容单独出去了。参考:

🔗探索【Stable-Diffusion WEBUI】的附加功能:图片缩放&抠图

(二)训练

已单独重新写过了,稍微详细一些。参考:

🔗关于【SD-WEBUI】的LoRA模型训练:怎样才算训练好了?

嗯,似乎比以前更明白了一些。文章来源地址https://www.toymoban.com/news/detail-449721.html

到了这里,关于关于【Stable-Diffusion WEBUI】方方面面研究(内容索引)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!