Hadoop之MapReduce实现原理-基础篇

一、基础篇

1. MR设计目标

MR诞生于搜索领域,主要是为了解决海量数据处理扩展性差的问题,它的实现时基于谷歌MR的设计思想,包括简化编程接口、提高系统容错性等。

- 易于编程:用户无需关注数据切片、数据传输、节点间通信等,只需要关注业务逻辑的实现,简化了开发过程且提高了开发效率。

- 良好的拓展性:当积累的数据量大的时候可以通过添加机器实现集群能力的扩容。

- 高容错性:机器存在故障的时候,能够通过计算迁移或者数据迁移等策略提高集群的可用性与容错性。

2. MR编程模型

MR由两个阶段组成:MAP阶段和Reduce阶段,开发者只需要编写Map()方法和reduce()方法即可完成分布式程序的设计。

map():以key/value作为输入,产生另一种key/value作为输出写出到本地磁盘,reduce()会自动将这部分中间数据按照key值进行聚集,且key值相同的数据被同一交给reduce()函数处理。

reduce():以key及对应的value列表作为输入,合并相同key的value后产生另一组key/value作为输出并写入到hdfs。

流程入下图所示:

3. MR基本架构

MR采用了Master/Slave架构,如下图所示,主要包含Client、JobTracker、TaskTracker、Task几个组件

- Client:

用户编写的MR通过Client提交到JobTracker端,也可以通过Client查看任务列表和当前运行状态,在Hadoop中作业(Job)表示MR程序,一个MR程序对应多个作业,每个作业会被分解成多个MR任务(Task)。

- JobTracker:

JobTracker主要负责资源监控和作业调度,JobTracker监控所有TaskTracker与作业的状态,一旦发现失败情况,立即将对应的任务转移到其他节点,JobTracker也会跟踪任务的执行进度、资源使用量等信息,并将这些信息告诉任务调度器,调度器会在资源出现空闲时,选择合适和任务使用这些资源。

- TaskTracker:

TaskTracker会通过Heartbeat将本节点上的资源使用情况和任务的运行进度汇报给JobTracker,并带回JobTracker发送过来的命令并执行响应的操作(启动新任务、杀死任务等)。TaskTracker使用slot等量划分本节点上的资源,一个Task只有获得slot后才有机会运行,TaskTracker通过slot数目限定Task的并发度。

- Task:

Task分为MapTask和ReduceTask,HDFS是以固定大小的block为单位存储数据,而MR是以split为单位处理数据,block是物理概念,split是逻辑概念,split只包含一些元数据信息,比如数据起始位置、数据长度、数据所在节点等,split的划分方法是用户自己决定的,但是split的数目决定了MapTask的数目,每个split会交由一个MapTask处理。

split和block的关系如下:

1. MapTask执行过程

- MapTask先将对应的split迭代解析成一个个key/value对。

- 然后依次调用自定义map()方法,最终将临时结果存放到本地磁盘上。

- 临时数据会被分成若干了partition,每个partition对应一个reduceTask处理。

2. ReduceTask执行过程

- 从远程节点上读取mapTask的中间结果(称为shuffle阶段)。

- 按照key对key/value进行排序(称为sort阶段)。

- 依次读取<key,value list>调用用户自定义的reduce()函数处理,并将结果写入到hdfs上(称为reduce阶段)。

4. MR作业的生命周期

假设提交一个作业,提交命令如下:

$HADOOP_HOME/bin/hadoop jar xxx.jar \

-D mapred.job.name="xxx" \

-D mapred.map.tasks=3 \

-D mapred.reduce.tasks=2 \

-D input=/test/input \

-D output=/test/output

作业运行图如下:

过程解析(5个步骤):

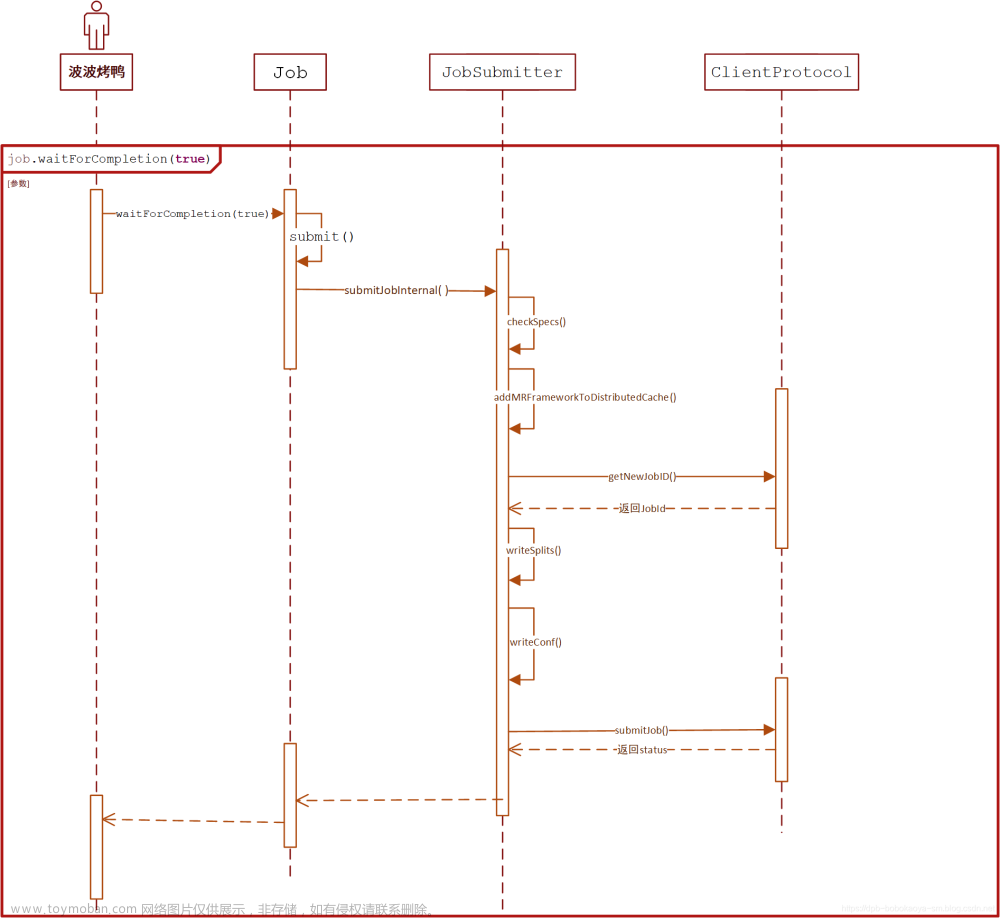

- 作业提交与初始化

用户提交作业后,首先会有JobClient将作业相关信息,比如jar包、作业配置文件、分片元数据文件等上传到HDFS上,其中分片元数据文件记录了每个输入分片的逻辑位置信息,然后由JobClient通过RPC通知JobTracker,JobTracker收到请求后,由作业调度器对作业进行初始化:为作业创建一个JobInProgress对象以跟踪作业运行状况,而JobInProgress会为每一个Task创建一个TaskInProgress对象跟踪每个任务的运行状态,TaskInProgress需要管理多个“Task运行尝试”。

- 任务调度与监控

任务调度和监控的功能是由JobTracker完成,TaskTracker周期性的通过Heartbeat向JobTracker汇报本节点的资源使用情况,一旦出现空闲资源,JobTracker将会按照一定的策略选择一个合适的任务使用该空闲资源,这由任务调度器完成,任务调度器是双层架构,即先选择作业,然后从该作业中选择任务,选择任务时需要重点考虑数据本地性,此外,JobTracker跟踪作业的整个运行过程,并为作业的成功运行提供全方位的保障,首先,当TaskTracker或者Task失败时,转移计算任务,其次,当某个Task任务远落后于同一作业的其他Task时,为之启动一个相同Task,并选取计算快的Task结果作为最终结果。

- 任务运行环境准备

运行环境准备包括JVN启动和资源隔离,TaskTracker为每个Task启动一个独立的JVM以避免不同Task在运行过程中相互影响,同时,TaskTracker使用了操作系统进程实现资源隔离以防止Task滥用资源。

- 任务执行

TaskTracker为Task准备好运行环境后,便会启动Task,在运行过程中,每个Task的最新进度首先由Task通过RPC汇报给TaskTracker,再由TaskTracker汇报给JobTracker。文章来源:https://www.toymoban.com/news/detail-449942.html

- 作业完成

待所有Task执行完毕后,整个作业执行成功。文章来源地址https://www.toymoban.com/news/detail-449942.html

到了这里,关于Hadoop之MapReduce实现原理-基础篇的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!