1.起因

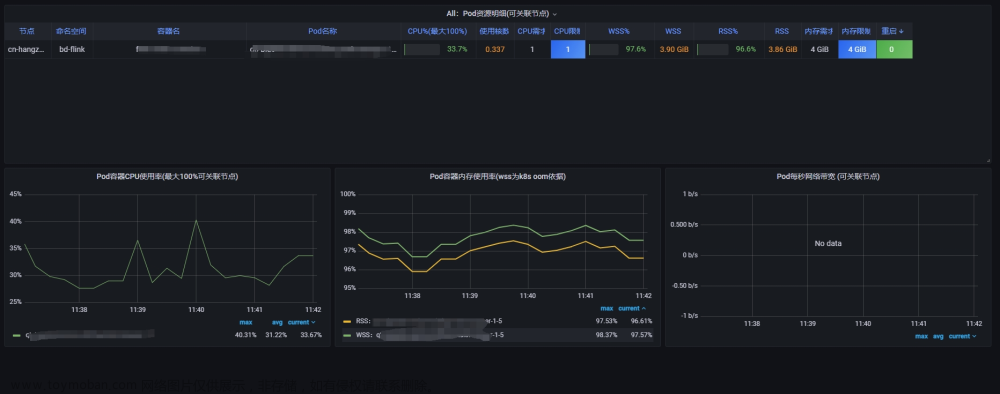

因为k8s发布的pod还未加入资源的监控,在查看pod负载时发现其中pod占用1核CPU

2.查找问题

2.1通过debug排查

# 首先查看存在问题的pod调度的节点是哪个,我们这里是调度到201的节点

kubectl -n beta get pod -o wide

下一步可以到对应的node节点查看对应进程的信息,也可以通过debug在当前节点进行排查(当节点太多懒得登录过去时)

# node/NodeName是问题pod所在的对应节点

kubectl -n beta debug node/NodeName -it --image=ubuntu

top命令找到所在节点进程信息,找到问题进程

查看详细线程

通过top -Hp PID获取进程中相关线程的信息,可以找到Thread-7这个线程一直占用着CPU

接下来到pod中找到相关线程,然后通过转换找到这个线程的具体信息

# 因为pod没有top命令,需要用debug拷贝有问题的pod进程到新的pod叫debug-pod,使用的时ubuntu镜像

kubectl -n beta debug -it bims-meta-depl-7f4f7bd77c-6rbhw --image=ubuntu --share-processes --copy-to=debug-pod

在pod中查看拷贝过了的进程信息

拷贝过来后的经常信息已改变进程号也改变了

再通过top -Hp PID找到刚刚的线程Thread-7

可以看到Thread-7线程的PPID是52

将52转换为 16 进制,得到结果是34,格式是0x34文章来源:https://www.toymoban.com/news/detail-450440.html

printf "%x\n" 52

这是通过jstack找到对应的线程信息文章来源地址https://www.toymoban.com/news/detail-450440.html

# 进入问题pod

kubectl -n beta exec -it PoDNAME -- bash

# 查看问题java经常PID

jps -l

# jstack 查看问题进程的所有线程信息

jstack PID |grep 0x34 -A 10 -B 2

到了这里,关于k8s排查Java应用CPU负载过高问题的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!