![深度学习论文精读[7]:nnUNet](https://imgs.yssmx.com/Uploads/2023/05/451615-1.jpeg)

相较于常规的自然图像,以UNet为代表的编解码网络在医学图像分割中应用更为广泛。常见的各类医学成像方式,包括计算机断层扫描(Computed Tomography, CT)、核磁共振成像(Magnetic Resonance Imaging, MRI)、超声成像(Ultrasound Imaging)、X光成像(X-ray Imaging)和光学相干断层扫描(Optical Coherence Tomography, OCT)等。对于临床而言,影像学的检查是一项非常重要的诊断方式。在各类模态的影像检查中,精准地对各种器官和病灶进行分割是影像分析的关键步骤,目前深度学习图像分割在各类影像检测和分割中大放异彩。比如基于胸部CT的肺结节检测、基于颅内MR影像的脑胶质瘤分割、基于心脏CT的左心室分割、基于甲状腺超声的结节检测和基于X光的胸片肺部器官分割等。

虽然基于UNet的系列编解码分割网络在各类医学图像分割上取得了长足的进展,并且部分基于相关模型的应用设计已经广泛用于临床分析中。但医学影像本身的复杂性和差异性也极度影响着分割模型的泛化性和通用性,主要体现在以下几个方面:

(1)各类模态的医学影像之间差异大,如研究队列的大小、图像尺寸和维度、分辨率和体素(voxel)强度等。

(2)分割的语义标签的极度不平衡。相较于影像中的正常组织,病变区域一般都只占极少部分,这就造成了正常组织的体素标签与病灶组织的体素标签之间极度的类不平常。

(3)不同影像数据之间的专家标注差异大,并且一些图像的标注结果会存在模棱两可的情况。

(4)一些数据集在图像几何和形状等属性上差异明显,切片不对齐和各向异性的问题也非常严重。

对于上述问题,学术界认为开发出通用的、可迁移的和强泛化性能的医学影像分割模型非常有必要。2018年,由医学图像领域的相关学者组织了一场医学图像分割的10项全能竞赛(The Medical Segmentation Decathlon,MSD),要求参赛者针对10个不同的医学影像分割任务设计通用性的分割模型,这些任务涵盖了医学图像分割各种典型的挑战,包括小样本问题、标签不平衡问题、多中心数据分布问题以及小目标分割问题等。如图1所示,10项全能的分割竞赛分为开发阶段和测试阶段,开发阶段包括脑部MRI影像的肿瘤分割、脑部MRI影像的海马体前部与后部分割、CT肺结节的分割、CT肝脏和肝癌的分割、CT胰腺与胰腺癌分割、MRI前列腺的外周带和移形带分割以及心脏MRI的左心房分割等7项任务,测试阶段3项任务均为CT影像任务,包括结肠癌病灶分割、肝脏血管分割和脾脏分割。图2是MRI脑部肿瘤分割的数据和标注示例。

![深度学习论文精读[7]:nnUNet](https://imgs.yssmx.com/Uploads/2023/05/451615-2.png)

![深度学习论文精读[7]:nnUNet](https://imgs.yssmx.com/Uploads/2023/05/451615-3.png)

针对上述分割任务,相关研究者认为自从UNet结构提出以后,基于其的改进版本众多,对其引入残差连接、密集连接、注意力机制、深度监督和特征校准等设计,总体上来看,对于特定分割任务来说效果提升有限,有时候甚至还会变差。之前大家聚焦的关键在于网络结构设计,对于模型之外的参数则很少关注。基于此,获得该项比赛第一名的团队,提出了一个统一的UNet框架:nnUNet,即no-new-Net,可以理解为不是新的网络结构设计,能够自动的根据数据任务配置参数和进行网络训练。提出nnUNet的论文为nnU-Net: Breaking the Spell on Successful Medical Image Segmentation,nnUNet在通用医学影像分割任务中取得了当时的SOTA水平的成绩。

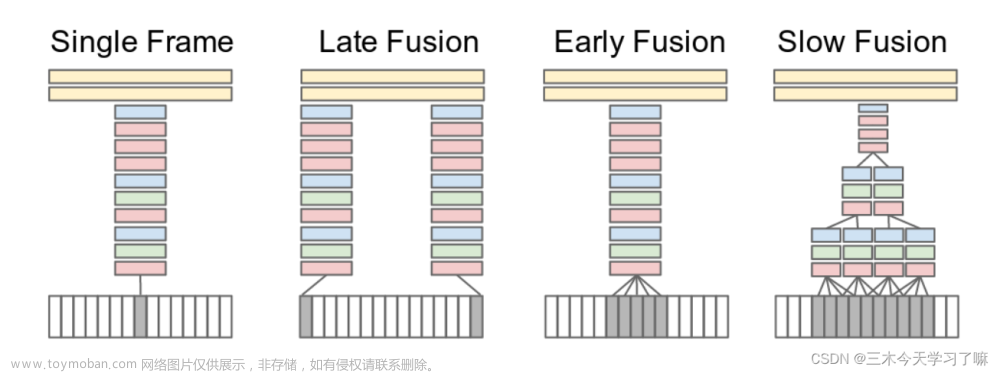

相较于之前的各种UNet改进,nnUNet更注重图像的预处理工作,能够自动判断影像模态并进行与之对应的归一化操作,并且根据三次样条插值对不同的图像体素间距进行重采样。网络结构方面,nnUNet基于原始的UNet提出了3个网络,分别是2D UNet、3D UNet和2个级联的3D UNet,第一个用于生成粗分割结果,第二个则用于细化粗分割结果,如图3所示。3个UNet模型能够彼此独立的进行配置、设计和训练,相较于原始的UNet,nnUNet对其结构作了微调:使用填充卷积来实现相同的输出和输入形状,使用Leaky ReLU代替ReLU,使用实例归一化来代替批量归一化。nnUNet能够自动设置超参数,比如训练批次大小、图像分块大小、下采样次数等。所有的UNet架构均通过五折交叉验证,使用交叉熵损失和Dice损失作为训练时的损失函数,优化器使用Adam,并设置学习率动态调整策略,同时训练时也使用在线的数据增强策略。

![深度学习论文精读[7]:nnUNet](https://imgs.yssmx.com/Uploads/2023/05/451615-4.png)

虽然nnUNet没有提出新的结构设计,但打破以往医学图像分割领域的研究常规,通过一些网络结构外的设计统一了医学图像分割任务框架,使得其具备极佳的通用性。nnUNet更加关注网络结构以外的参数配置,包括图像预处理、训练设计、推理时的模型集成以及后处理等。nnUNet源码可参考:

https://github.com/MIC-DKFZ/nnunet

根据读者对于本系列的反馈,后续相关内容会逐步更新到深度学习语义分割与实战指南GitHub地址:

https://github.com/luwill/Semantic-Segmentation-Guide

往期精彩:

深度学习论文精读[6]:UNet++

深度学习论文精读[5]:Attention UNet

深度学习论文精读[4]:RefineNet

深度学习论文精读[3]:SegNet

深度学习论文精读[2]:UNet网络

深度学习论文精读[1]:FCN全卷积网络

讲解视频来了!机器学习 公式推导与代码实现开录!文章来源:https://www.toymoban.com/news/detail-451615.html

完结!《机器学习 公式推导与代码实现》全书1-26章PPT下载文章来源地址https://www.toymoban.com/news/detail-451615.html

到了这里,关于深度学习论文精读[7]:nnUNet的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!