网络爬虫是指通过代码自动化地访问网页并收集数据的程序,要开发一个成功的爬虫,需要掌握以下技术:

1. HTTP 协议:了解 HTTP 请求和响应的基本内容,以及如何使用 HTTP 请求头和响应头来优化爬虫性能。

2. HTML/CSS/JavaScript:熟悉 HTML 页面结构、CSS 样式设计以及 JavaScript 的基础语法及 DOM 操作,以便于分析网页结构、提取数据、模拟用户行为等。

3. 数据存储:使用数据库或其他文件存储方式来存储采集到的数据,以便于后续的数据处理和分析。

4. 并发编程:网络爬虫通常需要同时处理大量请求和响应,因此需要掌握并发编程技术,以提高爬虫的效率。

5. 反爬机制:了解常见的反爬机制(如 IP 封锁、验证码、限流等),并掌握相应的对策,以克服被封禁或被识别的风险。

6. 安全性考虑:网络爬虫的开发需要考虑安全性问题,包括防止恶意攻击者利用漏洞入侵或拒绝服务攻击等。

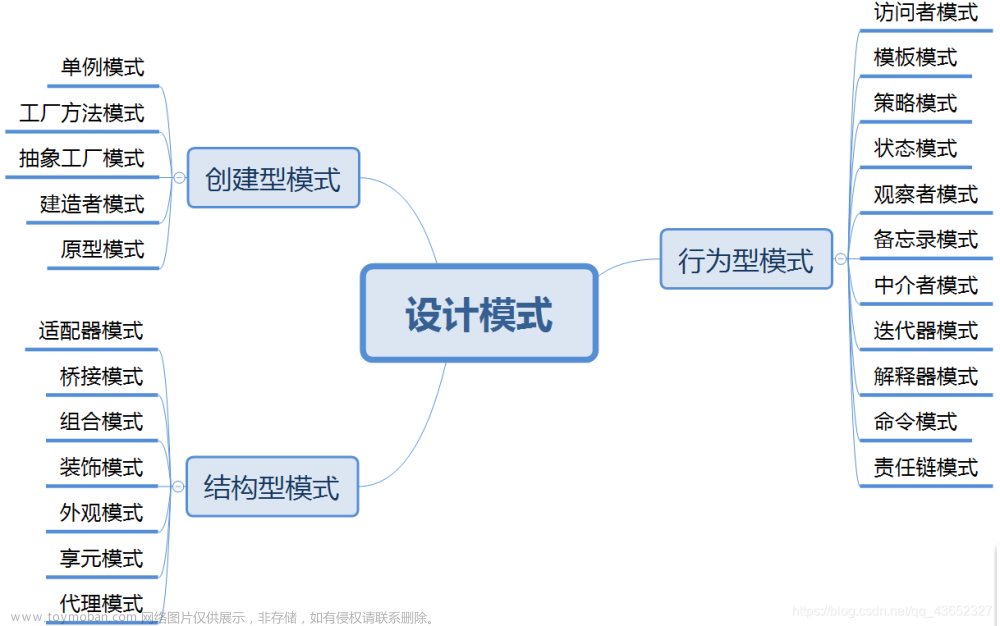

7. 代码设计:良好的代码设计可以使爬虫结构清晰、易于维护和扩展。例如,使用面向对象编程的思想来设计代码,以及灵活使用函数和模块化组织代码等。

综上所述,掌握以上技术可以帮助开发者编写更加健壮、高效和安全的网络爬虫。

HTTP 请求头和响应头中包含了大量的信息,可以被爬虫用来优化性能。以下是一些常见的技巧:

1. User-Agent:伪装 User-Agent 可以避免反爬虫机制,不同的 User-Agent 可以模拟不同的浏览器行为,一般建议使用合法的、真实的 User-Agent。

2. Accept-Encoding:通过配置 Accept-Encoding 来设置网页返回的编码方式,常见的编码方式有 gzip 和 deflate。配置正确的编码方式可以减少带宽和加载时间。

3. Cookies:有些网站需要登录才能访问,可以通过抓取登录接口返回的 Cookie,然后在后续的请求中添加 Cookie,以模拟已经登录的状态。

4. If-Modified-Since:如果已经抓取过的网页没有更新过,再次抓取时就可以直接使用缓存,以减少资源的浪费。使用 If-Modified-Since 可以检查网页是否已经修改过,如果没有修改过,则返回一个 304 状态码,告知客户端可以使用缓存。

5. Range:使用 Range 来分段获取大文件的内容,可以减少在网络传输上的时间。

6. Referer:有些网站需要 Referer 验证,提示页面从哪里跳转来。可以利用 Referer 携带访问来源,让爬虫更加隐蔽。

7. Connection:设置 Connection 为 Keep-Alive 可以维持长连接,减少每个请求都需要重新建立连接的时间成本。文章来源:https://www.toymoban.com/news/detail-452850.html

除了以上常见的技巧,还可以根据实际的需求和特点针对性地优化 HTTP 请求头和响应头。文章来源地址https://www.toymoban.com/news/detail-452850.html

到了这里,关于做网络爬虫需要掌握哪些技术?的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!