参考各文章以及个人操作后的记录文章,也希望能帮助有需要的人~

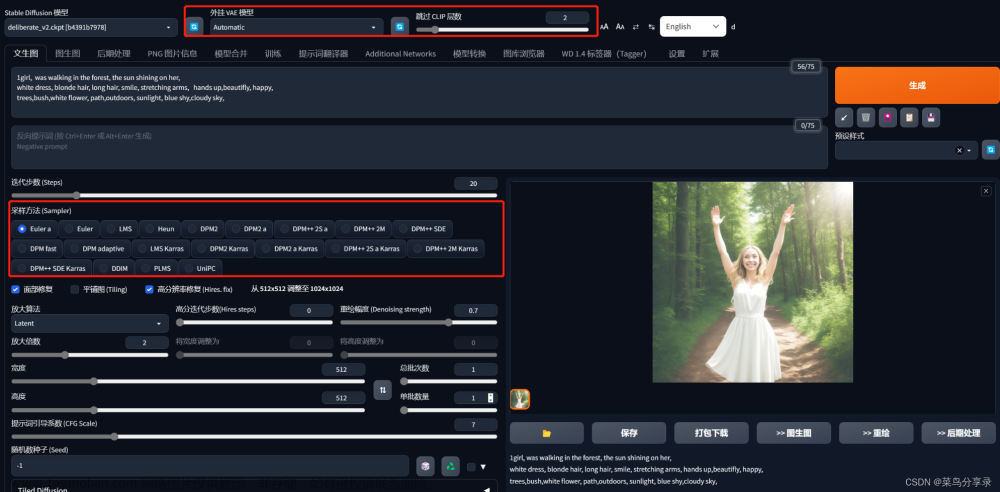

首先进去大概是这样的,介绍下下图几个区域(主要是文生图)。

一、模型区域

Stable Diffusion checkpoint下拉选择框是用来切换ckpt模型,不清楚的可以看下这篇Stable Diffusion-webUI ckpt模型、lora模型的区别和使用SD VAE是variable autoencoder的意思,在这里可以选择载入vae组分。使用vae组分可以让图片的色彩变得更好。

二、功能选项区域

简单介绍下各选项卡的功能

| 名称 | 作用 |

|---|---|

| txt2img 文生图 | 用文字生成图片 |

| img2img 图生图 | 用图片生成图片 |

| extras 附加 | 用于优化图像,提高图片精度 |

| PNG info 图片信息 | 用于查看 SD所生成的 图片的图像信息(别人发了好看的图片,没有标签,拿过来可以显示) |

| Checkpoint Merger 模型合并 | 合并不同的模型,生成新的模型 |

| Train 训练 | 训练模型 |

| Settings 设置 | 设置页面 |

| Extensions 扩展 | 扩展/插件管理 |

三、文生图标签区域

先分享大家一个好东西 :咒语生成器

提示词 Prompt(正向)

提示词 大佬的文章写的很清楚 : 秋风于渭水

支持的语言

支持的输入语言为英语,SD支持用自然语言描述,不过还是推荐使用用逗号分隔的一个个的关键词来写,当然表情符号,emoji,甚至一些日语都是可以用的。

tag语法

-

分隔:不同的关键词tag之间,需要使用英文逗号,分隔,逗号前后有空格或者换行是不碍事的

ex:1girl,loli,long hair,low twintails(1个女孩,loli,长发,低双马尾) -

混合:WebUi 使用 | 分隔多个关键词,实现混合多个要素,注意混合是同等比例混合,同时混。

ex:1girl,red|blue hair, long hair(1个女孩,红色与蓝色头发混合,长发) -

增强/减弱:有两种写法

-

第一种 (提示词:权重数值):数值从0.1~100,默认状态是1,低于1就是减弱,大于1就是加强

ex: ,(loli:1.21),(one girl:1.21),(cat ears:1.1),(flower hairpin:0.9) -

第二种 (((提示词))),每套一层()括号增强1.1倍,每套一层[]减弱1.1倍。也就是套两层是1.1*1.1=1.21倍,套三层是1.331倍,套4层是1.4641倍。

ex:((loli)),((one girl)),(cat ears),[flower hairpin]和第一种写法等价 -

所以还是建议使用第一种方式,因为清晰而准确

-

-

渐变:比较简单的理解时,先按某种关键词生成,然后再此基础上向某个方向变化。

[关键词1:关键词2:数字],数字大于1理解为第X步前为关键词1,第X步后变成关键词2,数字小于1理解为总步数的百分之X前为关键词1,之后变成关键词2- ex:

a girl with very long [white:yellow:16] hair等价为

开始a girl with very long white hair16步之后a girl with very long yellow hair - ex:

a girl with very long [white:yellow:0.5] hair等价为

开始a girl with very long white hair50%步之后a girl with very long yellow hair

- ex:

-

交替:轮流使用关键词

ex:[cow|horse] in a field比如这就是个牛马的混合物,如果你写的更长比如[cow|horse|cat|dog] in a field就是先朝着像牛努力,再朝着像马努力,再向着猫努力,再向着狗努力,再向着马努力

tag书写示例

建议按类似这样的格式书写提示词

画质词>>

这个一般比较固定,无非是,杰作,最高画质,分辨率超级大之类的

风格词艺术风格词>>

比如是照片还是插画还是动画

图片的主题>>

比如这个画的主体是一个女孩,还是一只猫,是儿童还是萝莉还是少女,是猫娘还是犬娘还是福瑞,是白领还是学生

他们的外表>>

注意整体和细节都是从上到下描述,比如

发型(呆毛,耳后有头发,盖住眼睛的刘海,低双马尾,大波浪卷发),

发色(顶发金色,末端挑染彩色),

衣服(长裙,蕾丝边,低胸,半透明,内穿蓝色胸罩,蓝色内裤,半长袖,过膝袜,室内鞋),

头部(猫耳,红色眼睛),

颈部(项链),

手臂(露肩),

胸部(贫乳),

腹部(可看到肚脐),

屁股(骆驼耻),

腿部(长腿),

脚步(裸足)

他们的情绪>>

表述表情

他们的姿势>>

基础动作(站,坐,跑,走,蹲,趴,跪),

头动作(歪头,仰头,低头),

手动作(手在拢头发,放在胸前 ,举手),

腰动作(弯腰,跨坐,鸭子坐,鞠躬),

腿动作(交叉站,二郎腿,M形开腿,盘腿,跪坐),

复合动作(战斗姿态,JOJO立,背对背站,脱衣服)

图片的背景>>

室内,室外,树林,沙滩,星空下,太阳下,天气如何

杂项>>

比如NSFW,眼睛描绘详细

16 /9 =x / 512

将不同的分类的词,通过换行区分开,方便自己随时调整

(masterpiece:1.331), best quality,

illustration,

(1girl),

(deep pink hair:1.331), (wavy hair:1.21),(disheveled hair:1.331), messy hair, long bangs, hairs between eyes,(white hair:1.331), multicolored hair,(white bloomers:1.46),(open clothes),

beautiful detailed eyes,purple|red eyes),

expressionless,

sitting,

dark background, moonlight, ,flower_petals,city,full_moon,

我跑的图是这样的

tag书写要点

- 虽然大家都管这个叫释放魔法,但真不是越长的魔咒(提示词)生成的图片越厉害,请尽量将关键词控制在75个(100个)以内。

- 越关键的词,越往前放。

- 相似的同类,放在一起。

- 只写必要的关键词。

反向提示词 Negative prompt

用文字描述你不想在图像中出现的东西

AI大致做法就是

- 对图片进行去噪处理,使其看起来更像你的提示词。

- 对图片进行去噪处理,使其看起来更像你的反向提示词(无条件条件)。

- 观察这两者之间的差异,并利用它来产生一组对噪声图片的改变

- 尝试将最终结果移向前者而远离后者

- 一个相对比较通用的负面提示词设置:

lowres,bad anatomy,bad hands,text,error,missing fingers,

extra digit,fewer digits,cropped,worst quality,

low quality,normal quality,jpeg artifacts,signature,

watermark,username,blurry,missing arms,long neck,

Humpbacked,missing limb,too many fingers,

mutated,poorly drawn,out of frame,bad hands,

unclear eyes,poorly drawn,cloned face,bad face

四、文生图操作区域

1. Generate按钮就是点击后根据你的tag生成图片

2.图标1:读取上一张图的参数信息,点击后会显示你上一张生成图的tag以及各种参数

3.图标2:清空描述语

4.图标3: 弹出选择模型

前两个选择模型(嵌入式、超网络)不常用到

后两个为常用的ckpt模型和lora模型

Stable Diffusion-webUI ckpt模型、lora模型的区别和使用

如何设置模型封面?

方法一:用当前模型跑一张图,然后点击替换预览图

方法二:在模型文件夹放置一张和模型同名的png文件

视图预览有点大,怎么缩小?

打开设置,选择左侧附加网络,下拉框选择第二个,点击apply setings,重启webUI 刷新页面

ok,视图变小了

5.图标4、图标5 这两个图标都是用来设置‘‘预设/模板’’的

eg:先在左侧设置一些通用的标签,点击“图标5”

完事后下面的下拉框会出现刚刚设置的模板

后面我们在写tag时生成图片后就会自动置入选择的模板

点击“图标4”将模板内容置入左侧描述框(就算没有点击图标4置入,只要在下拉框选择了相应模板,生成图片时候就会自动生效)

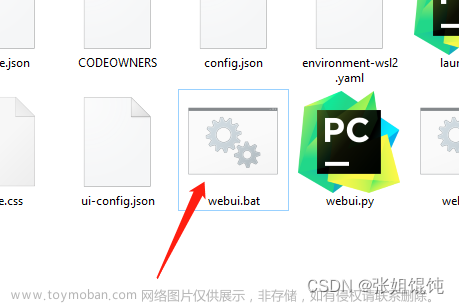

怎么管理模板?

在 sd 的根目录找到 styles.csv 用 记事本 打开 可以修改删除模板,不要用excel

五、文生图参数区域

1、采样方法 Sampling method

选择采样器方法,大佬做了很详细的描述,stable diffusion webui如何工作以及采样方法的对比

采样器方法太多了,如何隐藏?

找到设置,采样器参数,第一列勾选隐藏

常用的:

- Euler a :富有创造力,不同步数可以生产出不同的图片。 超过30~40步基本就没什么增益了。

- Euler:最最常见基础的算法,最简单的,也是最快的。

- DDIM:收敛快,一般20步就差不多了。

- LMS:eular的延伸算法,相对更稳定一点,30步就比较稳定了

- PLMS:再改进一点LMS

- DPM2:DDIM的一种改进版,它的速度大约是 DDIM 的两倍

2、采样步数 Sampling steps

一般默认20步就可以了

秋风于渭水 文章描述:

AI绘画的原理用人话说就是,先随机出一个噪声图片

然后一步步的调整图片,向你的 提示词 Prompt 靠拢

Sampling Steps就是告诉AI,这样的步骤应该进行多少次。

步骤越多,每一步移动也就越小越精确。同时也成比例增加生成图像所需要的时间。

大部分采样器超过50步后意义就不大了

下图是同一个图从1step到20step,不同step时图像的变化

3、Restore faces 面部修复

对生成图片任务面部进行修复, 对真人效果好,二次元作用不大,很占显存

4、Tiling 平铺/分块

生成可以往左右上下连续拼接的图像

5、Hires. fix 高清修复

将你的图片尺寸 ,按照你置顶的放大倍率,重新绘制图片内容

放大算法:不知道选什么就选“ESRGAN_4x ”

高清修复采样次数: 20 就行

重绘幅度:大后修改细节的程度,从0到1,数值越大,AI创意就越多,也就越偏离原图, 0.5~0.7就行

放大倍率:看你自己显卡能力了

6、宽&高

单位是像素,适当增加尺寸,AI会试图填充更多的细节进来。

非常小的尺寸(低于256X256),会让AI没地方发挥,会导致图像质量下降。

非常高的尺寸(大于1024X1024),会让AI乱发挥,会导致图像质量下降。

增加尺寸需要更大的显存。4GB显存最大应该是1280X1280(极限)

7、Batch count 生成批次

同样的配置,循环跑的次数

8、Batch size每批数量

每跑一次,生成几张图

9、 CFG Scale 提示词相关性

图像与提示词的匹配程度。一般在5~15之间为好,7,9,12是3个常见的设置值。

10、Seed 随机种子

图片的DNA,-1是随机

保持种子不变,相同的模型和参数大概率出现相同的图像

不同型号的显卡即使参数与模型完全一致,也可能会生成完全不同的图

- 图标1(骰子):随机种子-1

- 图标2(绿色箭头):自动填写最近生成的图片的种子值

- EXtra(额外的)选择后会出现

Variation seed(差异随机种子)

可以是-1,也可以是一个固定的种子

Variation strength(差异强度)

越强越接近差异随机种子,越弱越偏向随机种子

eg:我生成了一个贼好看的图片,我想生成和这张相似的其他图片

差异种子固定(你觉得好看的那张图的随机种子),差异随机种子-1,差异强度低一点,就能生成一系列相似图片

eg:我生成(同tag参数)了两张都很好看的图片,我想生成和这两张差不多的图片

差异种子固定(你觉得好看的那张图的随机种子),差异随机种子固定(你觉得另一张好看的那张图的随机种子),差异强度适中,就能生成一系列介于两张图片之间的图片文章来源:https://www.toymoban.com/news/detail-454493.html

六、文生图出图区域

图片点击可以预览

1、打开图片存储的文件夹

2、点击后可以下载该图片

3、点击后下载打包的图片

4、5、6、将该图片移动到对应的操作区域文章来源地址https://www.toymoban.com/news/detail-454493.html

到了这里,关于stable diffusion webui 使用的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!