卷积是什么鬼

卷积(convolution)

卷积:

f

(

t

)

∗

g

(

t

)

=

∫

f

(

τ

)

g

(

τ

)

d

(

τ

)

卷积运算符号用

∗

号来表示

卷积:f(t)*g(t)=\int{f(τ)g(τ)d(τ)}\\ 卷积运算符号用*号来表示

卷积:f(t)∗g(t)=∫f(τ)g(τ)d(τ)卷积运算符号用∗号来表示

卷积本质上还是运算,不过要比常见的加减乘除要高级的多,如果要用一句人话来讲:它用极简的数学形式,漂亮的描述了一个动态过程。

这个过程用个一个故事来表达:假设有一列火车g(t)和一个山洞f(t)摆在摆在同一个数轴上,这时火车头和山洞入口都在最左侧,如果现在我们想要描述火车进山的过程,该怎么办。

这是应该把火车旋转一下,让车头冲着山洞口,然后再一点点驶入山洞,这个过程才是卷积要解决的问题。

用数学语言来描述,把火车旋转就是把g(τ)变成g(-τ),这里我们用临时变量τ代替了原有的变量t,如此车身就被甩到了y轴左侧。

然后配上全局变量t,得到g(t-τ),火车就可以运动起来了,乘积f(τ)乘以g(t-τ),表示火车进入山洞后每一时刻t两者相对的位置。

积分也就是累加和,即记录了火车进入山洞后两者不断重叠、互相作用的过程。

现在把火车和山洞都简化为函数曲线,比如用红色的方波表示几何,黑色的曲线表示山洞\两个函数图像重叠的黄色区域面积,就是传说中的f(t)*g(t),有时也写成(f*g)(t)。

两个函数f和g可以是各种弯弯曲曲的形式,但它们的卷积表示的都是一个函数转进另一个函数肚子里的动态过程

因为要从头部开始进去,所以要先进行函数旋转,这两个函数的角色其实是可以函数互换的,也就是说可以是火车进山洞,也可以是山洞套火车,这就是所谓的卷积交换性质

卷积函数不仅可以连续的曲线,也可以是离散的形式如果用连续曲线选取采样点的视角来看两者本质上是一样的

f

[

n

]

∗

g

[

m

]

=

∑

m

=

−

∞

∞

f

(

m

)

g

(

n

−

m

)

f[n]*g[m]=\sum^{\infty}_{m=-\infty}f(m)g(n-m)

f[n]∗g[m]=m=−∞∑∞f(m)g(n−m)

卷积为什么这么牛

微积分: y = ∫ ( x − u ) n P ( x ) d x 微积分:y=\int{(x-u)^nP(x)dx} 微积分:y=∫(x−u)nP(x)dx

卷积的江湖地位不是一天形成的,数学天才欧拉早在18世纪研究微积分的时候就发现了这样一种能够将多种运算集于一身的有趣形式,但之后相当长的一段时间对它的关注还仅仅局限于数学界。

卷积定理:

F

[

f

1

(

t

)

∗

f

2

t

]

=

f

1

(

w

)

⋅

f

2

(

w

)

时域转频域

卷积定理:F[f_1(t)*f_2{t}]=f_1(w)\cdot f_2(w)\\时域转频域

卷积定理:F[f1(t)∗f2t]=f1(w)⋅f2(w)时域转频域

1821年,大神傅里叶正式提出卷积概念,并成功应用到物理领域,借助积分变换解决了信号处理中的时域与频域转换的难题,函数卷积的傅里叶变换等于函数傅里叶变换的乘积,这就是著名的卷积定理,在信号领域有着举足轻重的地位,可以说没有卷积就没有现在的5G、互联网。

y

(

t

)

=

f

(

t

)

∗

g

(

t

)

=

∫

f

(

τ

)

g

(

t

−

τ

)

d

τ

y(t)=f(t)*g(t)=\int{f(τ)g(t-τ)dτ}

y(t)=f(t)∗g(t)=∫f(τ)g(t−τ)dτ

20世纪开始,卷积运算被越来越多的科学家为之着迷,其最牛掰之处就在于:简介的数学模型却能高度概括生活中的很多现象,因而成为工程科学领域冉冉升起的耀眼明星。

通信领域

人们把卷积看成是将一种信号搬移到另外的一种频率当中,实现了调制功能

物理领域

卷积可以代表系统对某个输入物理量进行影响或者是污染

电路学

卷积是某种系统冲击函数对输入的相应,这类系统就是传说中的线行时不变系统

信号处理

从信号的角度来看,卷积实际上就是对信号进行滤波,系统就是滤波器,过滤出我们感兴趣有价值的信息。

图像处理

在图像处理领域卷积就像是一把好用的搓刀,被广泛应用于平滑、锐化、展宽等各种操作。

不仅如此,自动控制、地震学和医学等许多新兴领域都能看到卷积婀娜的身姿。

如果卷积的牛掰之处到此也就罢了,谁知更恐怖的事情发生了。

1998年,法国学者Yann LeCun将卷积运算与神经网络结合,提出了著名的卷积神经网络(Convolutional Neural Network)——CNN模型。

伴随着21世纪海量互联网大数据和GPU等硬件设备的快速发展,深度卷积神经网络自2012年一炮而红,引领了十年间人工智能技术的再度崛起,在众多领域显示了超越人类的强大能力。

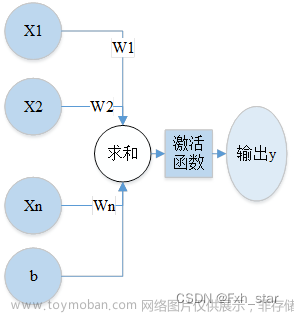

卷积神经网络是个啥

卷积神经网络最早应用在计算机视觉里,我们现在耳熟能详的人脸识别、字符识别背后算法的核心都是CNN技术。

卷积神经网络在把图片交给神经网络之前先要对图像进行一轮卷积的操作。

我们知道,视频其实是一组图片以极快的速度交替呈现而出的,其中的每张图片叫做一帧,卷积神经网络就是应用在这样的一帧图像上的。

计算机是如何处理图片的呢,我们看到的图片实际上是由RGB或者其它颜色模型下多种颜色图像叠加而成的,每种颜色由浅到深有分了0-255一共256个等级,如此一来,我们就可以把图片转化为数字矩阵

接下来为了提取图像的特征,我们会构建一个正方形的点阵,这个点阵就叫做卷积核,具体的操作过程是重合格子里的数字相乘然后再相加输出新的结果,从左上到右下逐个像素地遍历整个图像,就能得到新的矩阵了,这个过程用数学式子表达就是一个二维离散卷积操作。

y

[

n

1

,

n

2

]

=

x

[

n

1

,

n

2

]

∗

h

[

n

1

,

n

2

]

=

∑

m

−

∞

∞

∑

m

−

∞

∞

x

[

m

1

,

m

2

]

⋅

h

[

n

1

−

m

1

,

n

2

−

m

2

]

y[n_1,n_2]=x[n_1,n_2]*h[n_1,n_2]=\sum^{\infty}_{m-\infty}\sum^{\infty}_{m-\infty}x[m_1,m_2]\cdot h[n_1-m_1,n_2-m_2]

y[n1,n2]=x[n1,n2]∗h[n1,n2]=m−∞∑∞m−∞∑∞x[m1,m2]⋅h[n1−m1,n2−m2]

你可能会问原始图像遍历下来,原始图像边缘的像素点不就遍历不到了,这样每次生成新的矩阵就会比原始图像小一圈,为了解决这个问题,在卷积操作之前,一般会给原始图像外面补上一圈0,来保证输入输出维度一致,这个操作就是全零填充。

前面讲卷积操作就是用一个输入乘上系统函数然后计算输出在图像处理中,输入就是原始图像的像素,系统函数就是卷积核,将这也是卷积神经网络得名的由来。

∑

(

输入信号

f

×

系统函数

g

)

\sum{(输入信号f×系统函数g)}

∑(输入信号f×系统函数g)

卷积的意义何在呢,直接来看不同类型的卷积核过滤之后的图像就好了。通过卷积操作能够提取出图像的特征,从而为之后的神经网络计算创造更好的条件,这里的卷积核也常常被叫做过滤器。

文章来源:https://www.toymoban.com/news/detail-454933.html

文章来源:https://www.toymoban.com/news/detail-454933.html

伴随着人工智能技术的飞速发展,卷积现在已经几乎渗透进我们知道的每一个技术领域,发挥着越来越重要的作用。文章来源地址https://www.toymoban.com/news/detail-454933.html

到了这里,关于什么是卷积的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!