目录

1、请阐述大数据处理的基本流程。

2、请阐述大数据的计算模式及其代表产品

3、请列举Hadoop生态系统的各个组件及其功能。

4、分布式文件系统HDFS的名称节点和数据节点的功能分别是什么?

名称节点:

数据节点:

5、试阐述MapReduce的基本设计思想

6、YARN的主要功能是什么?使用YARN可以带来哪些好处?

7、试阐述Hadoop生态系统中Hbase与其他部分的关系。

8、数据仓库Hive的主要功能是什么?

9、Hadoop的主要有哪些缺点?相比之下,Spark具有哪些优点?

10、如何实现Spark与Hadoop的统一部署?

11、Beam的设计目的是什么,具有哪些优点?

1、请阐述大数据处理的基本流程。

基本流程:数据采集、存储管理、处理分析、结果呈现等环节。

(可略):从数据分析全流程的角度来看,大数据技术主要包括数据采集与预处理,数据存储和管理,数据处理与分析,数据可视化,数据安全和隐私保护等几个层面等内容。

2、请阐述大数据的计算模式及其代表产品

大数据计算模式 :批处理计算 ,流计算, 图计算 , 查询分析计算。

批处理计算:主要解决大规模数据的批量处理,代表产品有MapReduce 、Spark等。

流计算 :针对流数据的实时计算,代表产品有Storm,Flume,Flink、DStream、银河流数据处理平台等。

图计算 :针对大规模图结构数据的处理,代表产品有Pregel、GraphX、Giraph、PowerGraph等。

查询分析计算:大规模数据的存储管理和查询分析,代表产品有Hive、Presto、Impala等。

3、请列举Hadoop生态系统的各个组件及其功能。

Ambari:创建、管理、监视 Hadoop 的集群,为了让 Hadoop 以及相关的大数据软件更容易使用的一个web工具。

Zookeeper:分布式协调服务基础组件,可以用ZooKeeper来做:统一配置管理、统一命名服务、分布式锁、集群管理。

Hbase:基于HADOOP的分布式海量数据库。

Hive:基于大数据技术(文件系统+运算框架)的SQL数据仓库工具。

Pig:一种数据流语言和运行环境,常用于检索和分析数据量较大的数据集。

Mahout:主要目标是创建一些可扩展的机器学习领域经典算法的实现,旨在帮助开发人员更加方便快捷地创建智能应用程序。

MapReduce:是一种分布式计算模型,用以进行大数据量的计算。它屏蔽了分布式计算框架细节,将计算抽象成map和reduce两部分。Map阶段并行处理输入数据。Reduce 阶段对 Map结果进行汇总。

Flume:是一个分布式,可靠且可用的系统,可以有效地从许多不同的源收集,聚合和移动大量日志数据到集中式数据存储。

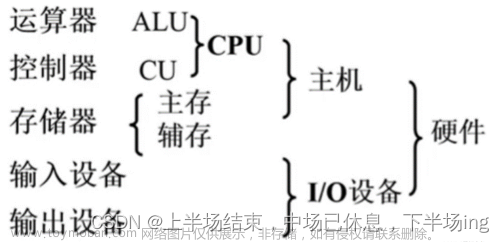

HDFS:一个分布式文件系统,一个文件系统,用它来存数据。

Sqoop:主要用于传统数据库和Hadoop之前传输数据。数据的导入和导出本质上是Mapreduce程序,充分利用了MR的并行化和容错性。

4、分布式文件系统HDFS的名称节点和数据节点的功能分别是什么?

名称节点:

作为中心服务器,负责管理文件系统的命名空间以及客户端对文件的访问。

数据节点:

负责处理文件系统客户端的读写请求,在名称节点的统一调度下进行数据块的创建、删除和复制等操作。

5、试阐述MapReduce的基本设计思想

MapReduce采用“分而治之”思想,把对大规模数据集的操作,分发给一个主节点管理下的各个子节点共同完成,然后整合各个子节点的中间结果,得到最终的计算结果。总而言之,分为三点:

1.对付大数据并行处理:分而治之

2.上升到抽象模型:Map与Reduce

3.上升到构架:以统一构架为程序员隐藏系统层细节

6、YARN的主要功能是什么?使用YARN可以带来哪些好处?

主要功能:负责集群资源调度管理,实现“一个集群多个框架”,即在一个集群上部署一个统一的资源调度管理框架YARN,在其之上可以部署其他各种计算框架。

好处:

1.由YARN提供统一的资源调度管理服务,根据不同框架的负载需求调整各自占用的资源,实现集群资源共享和资源弹性收缩,有效提高集群利用率;

2.不同计算机框架可以共享底层存储,在一个集群上集成多个数据集,使用多个计算框架来访问数据集,从而避免了数据集跨集群移动;

3.这种部署方式大大降低了企业运维成本。

7、试阐述Hadoop生态系统中Hbase与其他部分的关系。

1.HBase的数据文件(storeFile、WAL等)存储在HDFS上。

2.HBase通过Zookeeper来做master的高可用、RegionServer的监控、元数据的入口(当HBase读写数据时,需要从Zookeeper中查询meta表所处的Regionserver信息从而获取到需要读写的表格的位置信息)以及集群配置的维护等工作。

3.HBase中有Column Family的概念,简称为CF。CF一般用于将相关的列(Column)组合起来。在物理上HBase其实是按CF存储的,只是按照Row-key将相关CF中的列关联起来Hbase对数据的存储方式和数据结构进行的修改和规整(K-V形式),使其更加善于去处理大数据的场景,此在Hadoop MapReduce运行计算时能够提供更好的底层支持。

8、数据仓库Hive的主要功能是什么?

Hive是一个基于Hadoop的数据仓库工具,可以用于对存储在Hadoop文件中的数据集进行数据整理,特殊查询和分析处理。同时提供了类SQL语言的查询语言——HiveQL,可以通过其快速实现简单的MapReduce统计。

9、Hadoop的主要有哪些缺点?相比之下,Spark具有哪些优点?

Hadoop的缺点:

1.Hadoop不适用于低延迟数据访问。

2.Hadoop不能高效存储大量小文件。

3.Hadoop不支持多用户写入并任意修改文件。

4.使用Hadoop进行迭代计算非常耗资源

Spark的优点:

1.Spark的计算模式也属于MapReduce,但不局限于Map和Reduce操作,还提供了多种数据集操作类型,编程模型相较来说更灵活;

2.Spark提供了内存计算,可将中间结果放到内存中,对于迭代运算效率更高;

3.Spark基于DAG的任务调度执行机制,要优于Hadoop MapReduce的迭代执行机制;

4.Spark将数据载入内存后,之后的迭代计算都可以直接使用内存中的中间结果作运算,避免了从磁盘中频繁读取数据。

10、如何实现Spark与Hadoop的统一部署?

一方面,由于Hadoop生态系统中的一些组件所实现的功能,目前还是无法由Spark取代。另一方面,企业中已经有许多现有的应用,都是基于现有的Hadoop组件开发的,完全转移到Spark上需要一定的成本。因此,在许多企业实际应用中,Hadoop和Spark的统一部署是一种比较现实合理的选择。

由于Hadoop MapReduce、HBase、Storm和Spark等,都可以运行在资源管理框架YARN之上,因此,可以在YARN之上进行统一部署。

11、Beam的设计目的是什么,具有哪些优点?

设计目的:建立一个开源的统一编程模型,使开发者可以使用Beam SDK来创建数据处理管道,然后这些程序可以在任何支持的执行引擎上运行。

优点 :

1、统一了数据批处理(batch)和流处理(stream)编程范式;

2、能在任何执行引擎上运行。文章来源:https://www.toymoban.com/news/detail-455686.html

它不仅为模型设计、更为执行一系列数据导向的工作流提供了统一的模型。这些工作流包括数据处理、吸收和整合。文章来源地址https://www.toymoban.com/news/detail-455686.html

到了这里,关于《Spark编程基础Scala版》第一章习题答案的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!