书接上回:https://blog.csdn.net/nlpstarter/article/details/129834424推荐一个在本地部署中文类ChatGPT大模型的开源项目https://blog.csdn.net/nlpstarter/article/details/129834424

之前在推荐了一个中文类ChatGPT的大模型,感兴趣的可以看一下上面的链接。今天看到最新推出了13B版本的模型,迫不及待下载体验了。再贴一下项目地址:

项目名称:中文LLaMA&Alpaca大语言模型+本地部署 (Chinese LLaMA & Alpaca LLMs)

项目地址:GitHub - ymcui/Chinese-LLaMA-Alpaca: 中文LLaMA&Alpaca大语言模型+本地部署 (Chinese LLaMA & Alpaca LLMs)

根据官方的发布文档说明,本次主要更新了以下内容:

- 重磅更新了13B版本的LLaMA和Alpaca模型,其中Alpaca模型是类ChatGPT的交互模型

- 官方进一步细化了评测方法,以GPT-4作为评分员,对7B版本和13B版本进行了效果对比,最后7B版本总平均分是49分,13B版本是71分,看起来提升还是很大的。

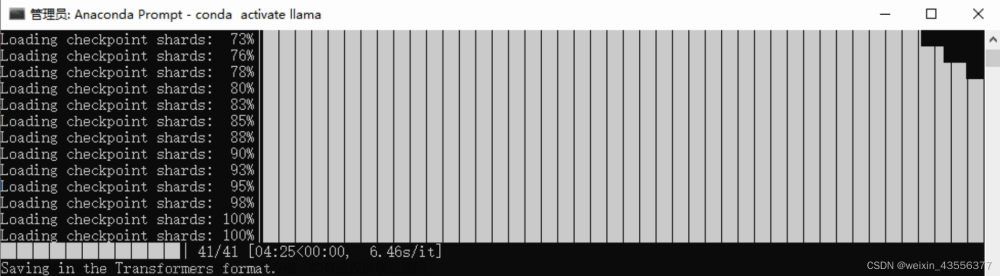

- 另外官方还提供了谷歌colab的在线转换脚本,方便低资源用户进行模型转换

获取和转换模型的步骤和之前完全一致,这里就不详细说了,还是进入到大家最关心的测试环节!

顺便插播一句:13B版本肯定是要比7B慢一些的,但是几乎不会有太大的体感,量化模型的整体输出还是非常顺畅的,没有什么卡壳的情况。

还是问一下关于温室效应的问题

和7B一样,答的还是很切题的,甚至可以在聊几轮过后让它写一个小作文。

数学问题:骑7个猴

这道题上次答的不尽人意,这次也是一样。说明目前的训练数据以及模型规模不足以让模型能够很好的掌握数学运算和推理问题。

如何制作宫保鸡丁?

这道题上次答的还行,不过整体上看起来并不像是在做宫保鸡丁。这回似乎也不是很好,材料里有猪肉。

写一封信

上一次的信写的还是可以的,这回我增加了难度。可以看出

- 信件的内容更加丰富了

- 令我惊讶的是,居然可以让他按照我的要求重新改一份,而且是由针对性的修改。为什么觉得惊讶呢,是因为官方并没有使用多轮的数据,不知道是因为LLaMA模型自带的上下文理解能力还是其他的一些magic。

- 整体的上下文理解比7B更加准确,对细节把控的更好

文学方面

官方这次给出了10大类的任务评测。里面包含一个文学方面的内容,我也试着进行了一些提问。可以看出事实性非常好,而且能够联系上下文进行简要的剖析。

我用GPT-4给上面的对话进行了打分,可以看出GPT-4对这段对话很满意,对四段对话都给出了9/10的高分。

情感方面

虽然官方没有评测这个类别,我觉得还是可以评一下的,看看机器有没有共情能力。从以下的截图中可以看出,机器还是提供了一些情感建议的,点赞。

角色扮演

官方也没有评测这个类别,我也试试。看似是有一些模仿能力,但是中间夹杂着一些奇怪的emoji符号,看样子是训练数据里没有类似的数据供拟合。

文章来源:https://www.toymoban.com/news/detail-458759.html

文章来源:https://www.toymoban.com/news/detail-458759.html

总结

可以看到13B在事实性方面,上下文理解方面得到了进一步的进化,在书信、写作等长文本能力上也得到了很大的进步。但是也能看到目前模型在数值推理等场景还是做的很差。这部分能力似乎是各种任务里比较困难的部分了,光靠简单的精调数据去拟合应该是远远不够的。不过,考虑到目前的模型量级以及训练数据量来看还是可以的。期待未来更多更好的模型出现。文章来源地址https://www.toymoban.com/news/detail-458759.html

到了这里,关于【类ChatGPT】中文羊驼大模型Alpaca-13B体验的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!