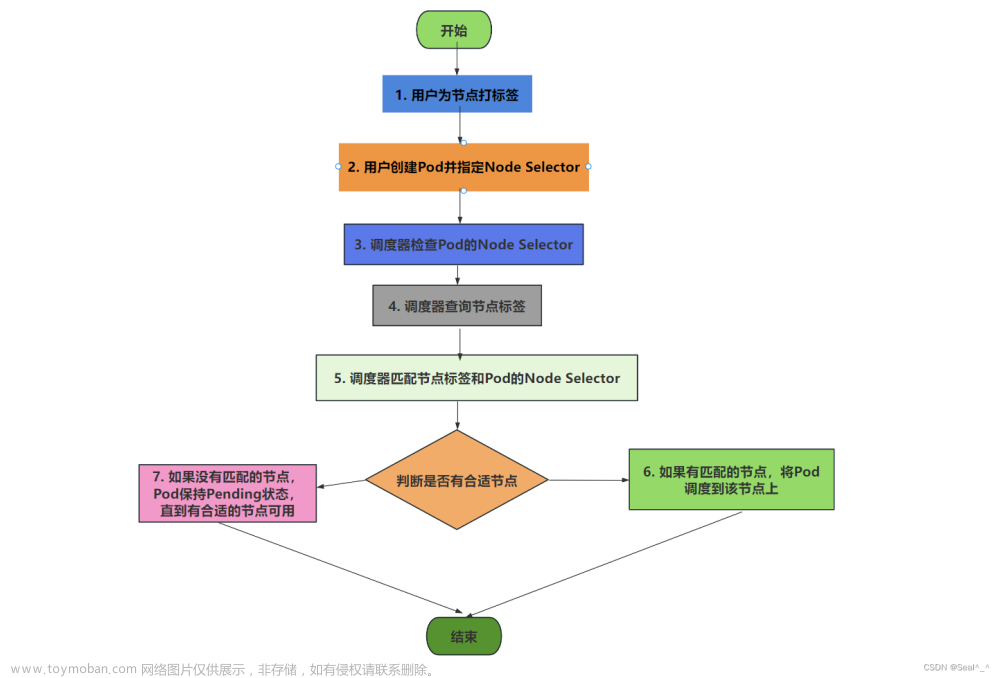

主要是需要确认你的yaml文件中是否有nodeSelector的配置,一般是因为k8s集群中没有相应的node节点匹配导致

这个错误消息表明您正在尝试在不符合Pod的节点亲和性规则的节点上运行Pod。这通常是由于节点选择器或节点亲和性规则设置不正确引起的。

以下是一些可能导致此错误消息的常见原因和解决方法:

-

检查Pod定义中的节点选择器是否正确。确保选择器与至少一个节点匹配。

-

检查Pod定义中的节点亲和性规则是否正确。如果您正在使用节点亲和性规则,请确保它们与集群中的节点匹配。

-

检查您的节点是否正确标记。如果您的节点没有正确标记,则可能会导致Pod无法在节点上运行。

-

如果您的集群正在使用节点亲和性和反亲和性,请确保它们没有相互冲突。如果规则相互冲突,则Pod可能无法在任何节点上运行。

-

如果您正在使用有状态的Pod,那么您可能需要在Pod定义中添加一个

podAntiAffinity规则。这可以确保Pod不会在同一节点上启动。

如果您排除了上述问题并仍然遇到这个错误消息,则可以通过以下步骤进一步诊断问题:

-

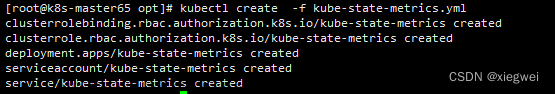

运行

kubectl describe pod <pod-name>命令,其中<pod-name>是出现错误消息的Pod名称。此命令将显示有关Pod的详细信息,包括节点亲和性规则。 -

检查有关节点亲和性规则的详细信息。这应该会显示哪些节点符合规则,以及哪些节点不符合规则。

-

检查集群中的节点是否正确配置。确保节点具有正确的标签和注释,并且符合节点亲和性规则。文章来源:https://www.toymoban.com/news/detail-459462.html

通过这些步骤,您应该能够找到导致“0/1 nodes are available: 1 node(s) didn't match Pod's node affinity”错误消息的原因,并解决该问题。文章来源地址https://www.toymoban.com/news/detail-459462.html

到了这里,关于0/1 nodes are available: 1 node(s) didn‘t match Pod‘s node affinity.的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!