目录

感谢B站秋葉aaaki大佬

前言

部署资源

部署流程

实机演示

ChatGML微调(人格炼成)(个人感觉蛮有趣的地方)

分享有趣の微调人格

实机演示(潘金莲人格)

感谢B站秋葉aaaki大佬

秋葉aaaki的个人空间_哔哩哔哩_bilibilihttps://space.bilibili.com/12566101

前言

由于ChatGLM-6B的规模较小,目前已知其具有相当多的局限性,如事实性/数学逻辑错误,可能生成有害/有偏见内容,较弱的上下文能力,自我认知混乱,以及对英文指示生成与中文指示完全矛盾的内容。请大家在使用前了解这些问题,以免产生误解。

很明显这个模型,因为是中文训练的,在很多数据上非常适合中文提问和回答

其次,本模型有思想钢印的存在,部分滑梯是不能说的

但是其也有着本地部署和开源社区的优势。

部署资源

模型可以从huggingface上下载

THUDM/chatglm-6b · Hugging Facehttps://huggingface.co/THUDM/chatglm-6bwebui项目地址,目前只是简易版仍然在更新 ChatGLM-webui:

Akegarasu/ChatGLM-webui: A WebUI for ChatGLM-6B (github.com)https://github.com/Akegarasu/ChatGLM-webui

链接:

百度网盘 请输入提取码 (baidu.com)https://pan.baidu.com/share/init?surl=xuCvJDbQYlHECY5-2b3-Eg提取码: y2ab

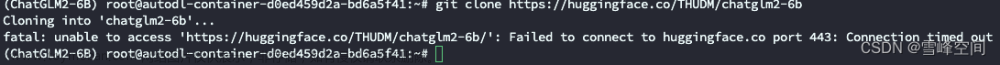

部署流程

将这三个压缩包解压到同一个文件夹

解压后如下图所示

将更新的的压缩包放入文件夹进行替换

实机演示

点击自己机型对应显存的程序

进行本地web—UI的配置

这样便可以在本地配置成功了

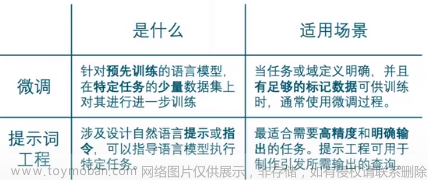

ChatGML微调(人格炼成)(个人感觉蛮有趣的地方)

分享有趣の微调人格

下载链接人格设定分享_免费高速下载|百度网盘-分享无限制 (baidu.com)https://pan.baidu.com/s/14z3X5BL5n9cJnW7b9GtZ4A?pwd=Glut#list/path=%2F文章来源:https://www.toymoban.com/news/detail-459676.html

实机演示(潘金莲人格)

文章来源地址https://www.toymoban.com/news/detail-459676.html

文章来源地址https://www.toymoban.com/news/detail-459676.html

到了这里,关于【ChatGLM】本地版ChatGPT ?6G显存即可轻松使用 !ChatGLM-6B 清华开源模型本地部署教程的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!