1、Whisper内容简单介绍

OpenAI的语音识别模型Whisper,Whisper 是一个自动语音识别(ASR,Automatic Speech Recognition)系统,OpenAI 通过从网络上收集了 68 万小时的多语言(98 种语言)和多任务(multitask)监督数据对 Whisper 进行了训练。OpenAI 认为使用这样一个庞大而多样的数据集,可以提高对口音、背景噪音和技术术语的识别能力。除了可以用于语音识别,Whisper 还能实现多种语言的转录,以及将这些语言翻译成英语。Open AI 强调 Whisper 的语音识别能力已达到人类水准。

左:输入的音频被分割成 30 秒的小段、转换为 log-Mel 频谱图,然后传递到编码器。

右:解码器经过训练以预测相应的文字说明,并与特殊的标记进行混合,这些标记指导单一模型执行诸如语言识别、短语级别的时间戳、多语言语音转录和语音翻译等任务。

2、Whisper模型实战

Whisper模型GitHub代码地址

部署步骤如下:(注意使用的是Windows系统)文章来源:https://www.toymoban.com/news/detail-460246.html

# 新建chatglm环境

conda create -n whisper python==3.8

# 激活chatglm环境

conda activate chatglm

# 安装PyTorch环境

pip --trusted-host pypi.tuna.tsinghua.edu.cn install torch==1.10.1+cu102 torchvision==0.11.2+cu102 torchaudio==0.10.1 -f https://download.pytorch.org/whl/torch_stable.html

# 一键安装依赖包

pip install -U openai-whisper

#执行tiny demo

whisper D:/11.mp4 --model tiny --language Chinese

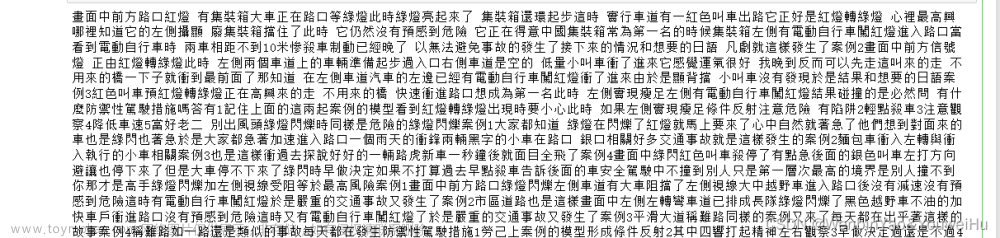

model tiny运行结果

model base运行结果

可以看出base model识别效果还是挺不错的,但由于追求速度,某些音相近的会被识别错误。

例如:

应供–因公

乘凯–陈凯

试验–誓言

逛该意目–灌溉亿亩文章来源地址https://www.toymoban.com/news/detail-460246.html

到了这里,关于学习实践-Whisper语音识别模型实战(部署+运行)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!