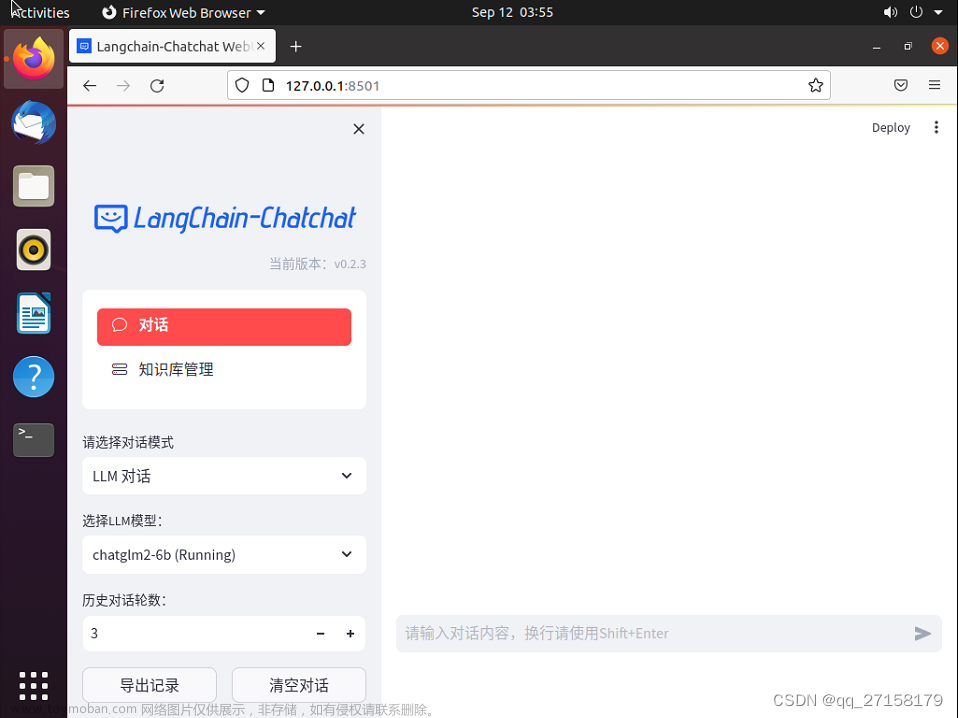

Chinese-LangChain

Chinese-LangChain:中文langchain项目,基于ChatGLM-6b+langchain实现本地化知识库检索与智能答案生成

https://github.com/yanqiangmiffy/Chinese-LangChain

俗称:小必应,Q.Talk,强聊,QiangTalk

🔥 效果演示

文章来源:https://www.toymoban.com/news/detail-460330.html

文章来源:https://www.toymoban.com/news/detail-460330.html

🚀 特性

- 🐯 2023/04/19 引入ChuanhuChatGPT皮肤

- 📱 2023/04/19 增加web search功能,需要确保网络畅通!

- 📚 2023/04/18 webui增加知识库选择功能

- 🚀 2023/04/18 修复推理预测超时5s报错问题

- 🎉 2023/04/17 支持多种文档上传与内容解析:pdf、docx,ppt等

- 🎉 2023/04/17 支持知识增量更新

🧰 知识库

| 知识库数据 | FAISS向量 |

|---|---|

| 💹 大规模金融研报知识图谱 | 链接:https://pan.baidu.com/s/1FcIH5Fi3EfpS346DnDu51Q?pwd=ujjv 提取码:ujjv |

🔨 TODO

- 支持上下文

- 支持知识增量更新

- 支持加载不同知识库

- 支持检索结果与LLM生成结果对比

- 支持检索生成结果与原始LLM生成结果对比

- 检索结果过滤与排序

- 互联网检索结果接入

- 模型初始化有问题

- 增加非LangChain策略

交流

欢迎多提建议、Bad cases,目前尚不完善,欢迎进群及时交流,也欢迎大家多提PR

文章来源地址https://www.toymoban.com/news/detail-460330.html

❤️引用

- webui参考:https://github.com/thomas-yanxin/LangChain-ChatGLM-Webui

- knowledge问答参考:https://github.com/imClumsyPanda/langchain-ChatGLM

- LLM模型:https://github.com/THUDM/ChatGLM-6B

- CSS:https://huggingface.co/spaces/JohnSmith9982/ChuanhuChatGPT

到了这里,关于Chinese-LangChain:基于ChatGLM-6b+langchain实现本地化知识库检索与智能答案生成的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!