关注公众号,发现CV技术之美

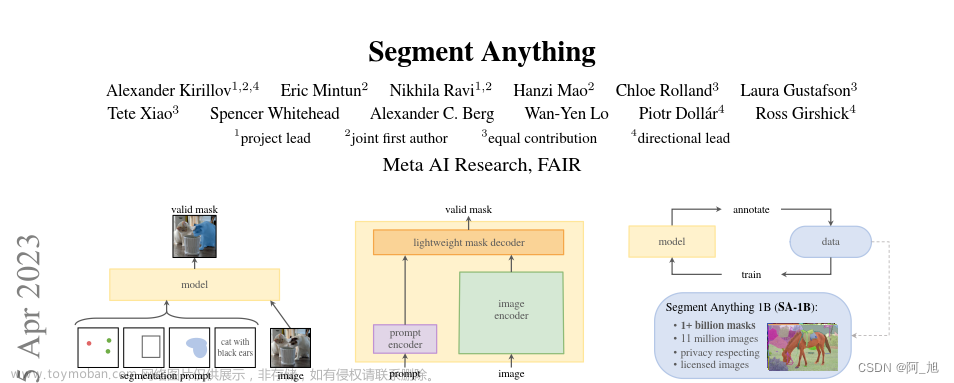

上周,Meta AI发布了 Segment Anything Model(SAM)—— 第一个图像分割基础模型。很多计算机视觉从业者惊呼“这下CV真的不存在了,快跑!”。但是SAM 模型真的是强悍到可以“分割一切”了吗?它在哪些场景或任务中还不能较好地驾驭呢?

研究社区已经有一些相关工作对这一问题进行探索,今天向大家介绍一篇昨天刚出的技术报告:SAM Struggles in Concealed Scenes -- Empirical Study on "Segment Anything"。

论文地址:https://arxiv.org/abs/2304.06022

该技术报告选择了在伪装物体分割任务上进行实验验证,发现SAM模型与当前尖端的伪装物体分割模型依旧有很大的差距,并通过对伪装动物、工业缺陷、医疗病灶中多个案例进行可视化分析,得出一些有趣的结论。

在讨论具体实验之前,我们先借助一张图片来了解一下什么是“伪装物体”,如左图和右图中分别隐藏了七只和六只小鸟,你发现了吗?生物学家把这种现象称为背景匹配伪装,用于表示一个或者多个生物为了防止被发现,尝试将其颜色与周围环境“无缝地”匹配,这种现象在自然界很普遍(答案请参见本文末)。

图1. 背景匹配伪装示例

图1. 背景匹配伪装示例

伪装目标分割任务是检测出那些与自然栖息地中有着相似模式的物体。更多有关“伪装目标分割”的更多信息,大家可以参考2022年刊表于TPMAI期刊中关于伪装目标分割的论文SINetV2 [1]:

◆论文链接:https://ieeexplore.ieee.org/document/9444794

◆中文介绍:https://cg.cs.tsinghua.edu.cn/jittor/news/2021-06-11-00-00-cod/

◆GitHub项目:https://github.com/GewelsJI/SINet-V2

回归正题!该技术报告首先选取了当前伪装目标分割领域中三个常用的数据集合(COD10K [2]、CAMO [3]、NC4K [4]),并与三个基于Transformer的尖端模型(CamoFormer [5]和HitNet [6])作为对比,在9个二值分割指标上面进行了全面的定量评测。

最后,在无提示的情况下测试了基于三种不同ViT骨架的SAM模型,即:ViT-B、ViT-L和ViT-H。该报告发现,具有最高参数量的SAM依旧与尖端性能有很大的差距,例如在CAMO数据集上,增强匹配指标相差25.6个百分比。

此外,该报告还对三个常见的隐蔽场景进行了可视化分析。

首先,在自然场景中,可以看出SAM模型分割隐蔽动物具有一定难度。例如,由于前景目标和背景区域之间具有十分相似的形状和颜色,在下图中螳螂蹲在叶子上(第二列图像)、海马位于橙色珊瑚中(最后一列图像),SAM均无法给出准确定位。

此外,那些动物隐藏在背景中也会给SAM模型的识别带来不小的挑战,例如:猫头鹰(第一列)、鹿(第三列)和蜥蜴(第四列)。

图2. SAM模型不能很好的感知场景中的伪装动物

其次,在工业场景中SAM依旧无法做到“分割一切”。可以看出,由于工业场景中通常是短焦距下拍摄的近景图像,所以SAM模型更倾向于去分割整个物体或者是物体的主体部分。例如下图中的螺钉和瓶底。

此外,报告还指出SAM模型很难去区分缺陷区域和纹理背景之间的差异性。例如下图中倒数第二列带有划伤的皮革,SAM会直接检测失败。

图3. SAM模型针对于工业场景中缺陷区域检出能力较差

最后,作者还观察到SAM模型在处理具有隐蔽模式的医学数据中表现也不如意,例如下图第一列中的结肠息肉与周围肠壁组织具有相似的颜色。其余样本均是来源自三维 MRI和CT扫描影像中的二维灰度切片,虽然SAM可以粗略地分割器官区域,因为器官具有明显的边界,但在识别无定形病变区域(如癌症、血管和肿瘤)中仍存在一定缺陷。

图4. SAM模型针对医疗病灶区域的检测能力不足

由此可见,CV并没有消失,大模型还不能解决所有问题,这篇技术报告也算是让视觉研究者们松了口气 。

。

参考文献:

[1] Fan, Deng-Ping, Ge-Peng Ji, Ming-Ming Cheng, and Ling Shao. "Concealed object detection." IEEE Transactions on Pattern Analysis and Machine Intelligence 44, no. 10 (2021): 6024-6042.

[2] Fan, Deng-Ping, Ge-Peng Ji, Guolei Sun, Ming-Ming Cheng, Jianbing Shen, and Ling Shao. "Camouflaged object detection." In Proceedings of the IEEE/CVF conference on computer vision and pattern recognition, pp. 2777-2787. 2020.

[3] Le, Trung-Nghia, Tam V. Nguyen, Zhongliang Nie, Minh-Triet Tran, and Akihiro Sugimoto. "Anabranch network for camouflaged object segmentation." Computer vision and image understanding 184 (2019): 45-56.

[4] Lv, Yunqiu, Jing Zhang, Yuchao Dai, Aixuan Li, Bowen Liu, Nick Barnes, and Deng-Ping Fan. "Simultaneously localize, segment and rank the camouflaged objects." In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp. 11591-11601. 2021.

[5] Yin, Bowen, Xuying Zhang, Qibin Hou, Bo-Yuan Sun, Deng-Ping Fan, and Luc Van Gool. "CamoFormer: Masked Separable Attention for Camouflaged Object Detection." arXiv preprint arXiv:2212.06570 (2022).

[6] Hu, Xiaobin, Deng-Ping Fan, Xuebin Qin, Hang Dai, Wenqi Ren, Ying Tai, Chengjie Wang, and Ling Shao. "High-resolution Iterative Feedback Network for Camouflaged Object Detection." arXiv preprint arXiv:2203.11624 (2022).

图5. 针对图1中所给出的答案,你猜对了吗?

END文章来源:https://www.toymoban.com/news/detail-460849.html

欢迎加入「目标检测」交流群👇备注:Det文章来源地址https://www.toymoban.com/news/detail-460849.html

到了这里,关于SAM 模型真的是强悍到可以“分割一切”了吗?的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!