HuggingFace是目前最火热的AI社区,很多人称之为AI模型的GitHub。包括Google、微软等很多知名企业都在上面发布模型。

HuggingFace简介:https://www.datalearner.com/blog/1051636550099750

而HuggingFace上提供的流行的模型也是大家应当关注的内容。本文简单介绍一下2023年4月初的七天(当然包括3月底几天)的最流行的9个模型(为什么9个,因为我发现第10个是一个数据集!服了!)。让大家看看地球人都在关注和使用什么模型。

上图就是过去七天最流行的模型,我们分别简单介绍一下。

Cerebras-GPT-13B

Cerebras GPT是由Cerebras公司开源的自然语言处理领域的预训练大模型,其模型参数规模最小1.11亿,最大130亿,共7个模型。

Cerebras-GPT-13B模型卡信息:https://www.datalearner.com/ai-models/pretrained-models/Cerebras-GPT

与业界的模型相比,Cerebras-GPT几乎是各个方面完全公开,没有任何限制。不管是模型架构,还是预训练结果都是公开的。目前开源的模型结构和具体训练细节如下:

而排行榜第一的13B是其中最大的模型。过去七天它获得了2.68K的关注,当之无愧的第一名。

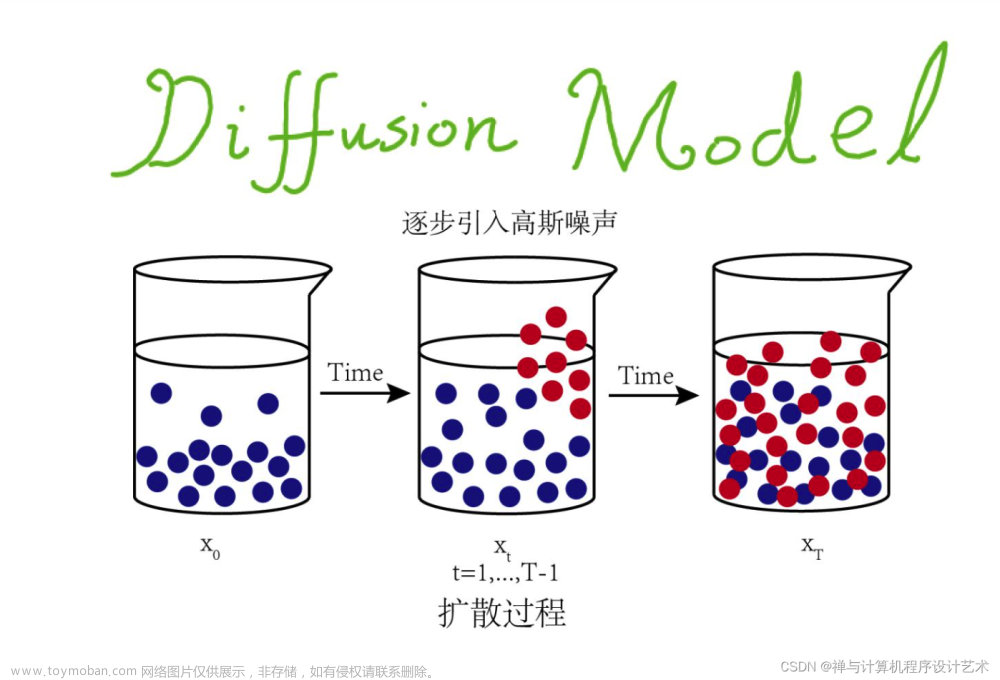

stable-diffusion-v1-5

著名的开源的Text-to-Image模型,是DALL·E2和Midjourney的免费替代品。Stable-Diffusion-v1-5的checkpoints使用Stable-Diffusion-v1-2的权重进行了初始化,随后在“laion-aesthetics v2 5+”上以512x512的分辨率进行了595k步的微调,并且降低了10%的文本调节来改善无分类器的引导采样。

尽管StableDiffusion2.1已经发布(Stable Diffusion2.0版本模型卡信息:https://www.datalearner.com/ai-models/pretrained-models/stable-diffusion-2 ),这个1.5模型这么火热真没有想到(真实原因大概是1.5之后的版本在NSFW方面做了限制)。

清华大学的ChatGLM-6B

清华大学著名的ChatGLM-6B的开源模型。基于GLM-13B模型做的指令微调。由于仅包含60亿参数,且效果很好,可以在自己电脑上运行,因此十分受欢迎。本周排行第三,十分值得大家尝试!

ChatGLM-6B模型卡信息:https://www.datalearner.com/ai-models/pretrained-models/ChatGLM-6B

stable-diffusion-v2-1

不多说了,Stable Diffusion的2.1版本。基于SD2.0版本做的进一步训练。于2022年12月7日发布。本次排行第四!

controlnet

ontrolNet是一种新的神将网络结构,由斯坦福大学的Lvmin Zhang和Maneesh Agrawala提出的可以用来增强扩散模型的方法。主要是基于已有的Text-to-Image预训练模型对特定数据进行微调以更加适合使用者的目的。这个结构最大的特点是可以在比较资源少的设备如个人PC上对大模型进行调整以获得更好的效果。

由于其结构简单,并且与其它模型简单配合就可以做成更好的效果,所以一直十分受欢迎。而作者也在其HuggingFace上提供了很多模型的实现,包括 Canny边缘检测、图像分割等。具体参考ControlNet模型卡信息:https://www.datalearner.com/ai-models/pretrained-models/ControlNet

dolly-v1-6b

dolly-v1-6b是由Databricks创建的一个60亿参数的因果语言模型,它源自EleutherAI的GPT-J(于2021年6月发布),并在一个约为52,000个记录的指令语料库(Stanford Alpaca)(CC-NC-BY-4.0)上进行了微调,其中包括使用Self-Instruct论文中概述的技术生成的问答对。Dolly的原始版本是使用deepspeed ZeRO 3在Databricks机器学习平台上训练的,仅使用一台NDasrA100_v4机器和8个A100 40GB GPU,只需30分钟(1个epoch)即可完成。

Dolly具有与ChatGPT相似的惊人的指令跟随能力。

Dolly的模型卡信息:https://www.datalearner.com/ai-models/pretrained-models/Dolly

GPTrillion

GPTrillion是由Banana公司训练的一个1.5万亿参数的模型。没错!1.5万亿参数。

GPTrillion是由Banana.dev的开源研究团队Plantain Labs在仅6个月的时间里训练而成的。Banana提供了训练计算资源,利用服务器GPU集群在低负载期间进行训练。

最重要的,该模型完全开源!

GPTrillion模型卡信息:https://huggingface.co/banana-dev/GPTrillion

—-更正:GPTrillion是愚人节玩笑节目,里面的项目已经被删除!

llama-7b-hf

LLaMA是著名的MetaAI开源的大语言预训练模型,也因为它的开源以及斯坦福发布的Alpaca工作,让LLaMA成为最近这些天发布的模型的基础(也就是说最近很多模型都是用LLaMA微调的)。而这个是Decapoda Research在HuggingFace上部署的。是将原始的预训练结果转换成与Transformers/HuggingFace兼容的文件。

LLaMA模型卡信息:https://www.datalearner.com/ai-models/pretrained-models/LLaMA

OrangeMixs

这是一个宅男神器,是基于StableDiffusion做的生成美少女插画的模型集合。

下图就是它生成的一些图:

OrangeMixs 是一个免费的 Stable Diffusion 合并模型集,它包含了一些具有不同特征的合并模型,用于生成美少女插画。

OrangeMixs 是由 WarriorMama777 在 Google Colab 上创建的 Stable Diffusion 模型,可以通过单击进行设置。它旨在为日本社区提供常用模型的便捷访问,并作为上传合并模型的地方。它支持 Gradio Web UI 来运行 OrangeMixs。文章来源:https://www.toymoban.com/news/detail-461118.html

最主要的是这是开源可下载的!文章来源地址https://www.toymoban.com/news/detail-461118.html

到了这里,关于HuggingFace过去七天最流行的AI模型一览——预训练大模型绝对王者的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!