一、TCP重传(TCP Retransmission)

1.1 重传原理与机制(Retransmission Principles and Mechanisms)

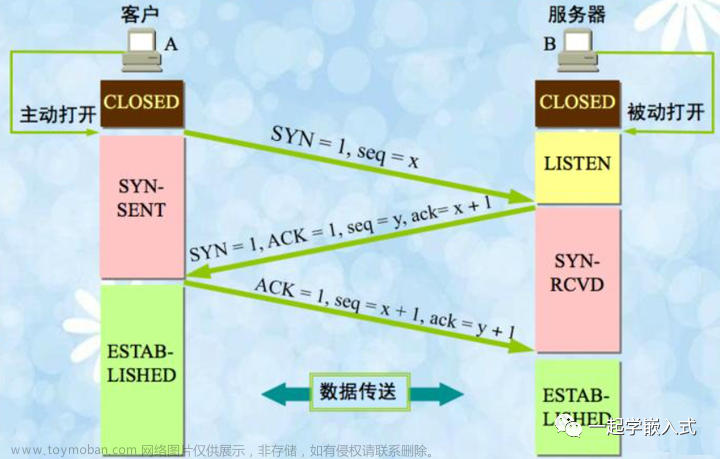

TCP(传输控制协议)是一种面向连接、可靠的传输层协议。为了保证数据的可靠传输,TCP采用了数据包重传的策略来应对在网络中传输过程中可能出现的丢包、错包、乱序等问题。下面我们详细介绍TCP重传的原理与机制。

(1)确认机制(Acknowledgement Mechanism)

TCP通信中,接收方在收到数据包后会返回一个确认报文(ACK),用以通知发送方已经成功接收到了数据。发送方在发送数据包后等待接收方返回确认报文。如果在规定的时间内没有收到确认报文,发送方会认为数据包丢失,触发重传机制。

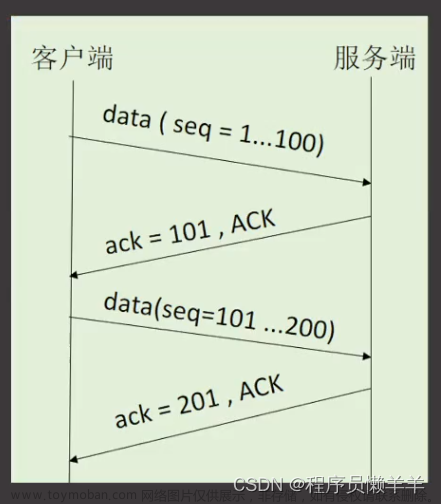

(2)滑动窗口(Sliding Window)

TCP利用滑动窗口机制实现流量控制和拥塞控制。发送方的窗口大小决定了其可以发送的数据包数量。当接收方返回确认报文时,发送方的窗口滑动,可以继续发送新的数据包。如果有未确认的数据包,窗口将不再滑动,直到确认报文收到或触发重传机制。

(3)序号(Sequence Number)

TCP为每个数据包分配一个独立的序号,以保证数据包的有序传输。接收方在收到数据包后,会根据序号对数据包进行排序,确保最终传输结果的正确性。如果接收方检测到序号不连续的数据包,说明中间有丢包现象,将会请求发送方进行重传。

(4)重传计时器(Retransmission Timer)

TCP发送方维护一个重传计时器,用于监控每个已发送但未收到确认报文的数据包。当计时器超时,发送方会认为对应的数据包丢失,触发重传机制。为了应对不同的网络环境,TCP还采用了一种自适应的计时器调整策略,动态调整超时阈值。

总结:TCP重传原理与机制的核心是通过确认机制、滑动窗口、序号和重传计时器等多种手段,确保数据的可靠传输。发送方在未收到接收方的确认报文时,会通过重传机制重新发送数据包,从而保证数据传输的完整性和正确性。

1.2 重传触发条件(Conditions for Retransmission Triggering)

TCP重传机制是为了确保数据可靠传输而设计的关键策略。为了更好地理解TCP重传,我们需要了解触发重传的具体条件。以下是导致TCP重传的主要情况:

(1)超时重传(Timeout Retransmission)

当发送方发送数据包后,会启动一个重传计时器,等待接收方返回确认报文。如果在计时器超时之前仍未收到确认报文,发送方会认为数据包丢失,触发超时重传。超时重传的时间阈值会根据网络状况进行动态调整。

(2)快速重传(Fast Retransmission)

快速重传是一种提高TCP性能的重传策略。当接收方连续收到三个相同序号的确认报文(Duplicate ACKs)时,发送方会认为对应的数据包发生了丢失。为了尽快补发丢失的数据包,发送方会立即进行重传,而不再等待重传计时器超时。这种方法可以减小因数据包丢失导致的延迟。

(3)选择性确认重传(Selective Acknowledgment Retransmission)

选择性确认(SACK)是一种TCP扩展,允许接收方通知发送方哪些数据包已经被成功接收,哪些数据包需要重传。SACK可以提高TCP性能,因为发送方可以更精确地知道哪些数据包需要重传,避免不必要的全量重传。

(4)拥塞触发的重传(Congestion-triggered Retransmission)

当发送方检测到网络拥塞时,可能会触发重传。这是因为在拥塞情况下,数据包丢失的概率增加,导致发送方需要重新发送数据包。拥塞控制算法(如TCP Tahoe、Reno、NewReno等)会在拥塞发生时动态调整发送方的窗口大小,限制发送速率,从而减小拥塞程度。

综上所述,TCP重传触发条件包括超时重传、快速重传、选择性确认重传和拥塞触发的重传。了解这些触发条件有助于我们更好地理解TCP重传机制,并为网络性能优化提供思路。

1.2.1 重传计时器解析

TCP发送端在发送数据后确实会启动一个内部定时器,这个定时器是自动开启的,它是TCP协议保证数据可靠传输的一个重要组成部分。这个定时器被称为重传定时器(Retransmission Timer)。其工作原理和设置基于以下几个要素:

-

自动启动:

- 当TCP发送端发送一个数据段后,它会为这个数据段启动一个重传定时器。如果在定时器超时之前收到了相应的确认(ACK),定时器就会被取消。

- 如果没有收到确认,一旦定时器超时,TCP发送端会重传这个数据段,并重置定时器。

-

定时策略:

- 重传定时器的超时时间不是固定的,而是根据网络的往返时间(Round-Trip Time, RTT)动态调整的。

- TCP使用一种算法(如Jacobson/Karels算法)来估计一个合理的RTT,这个估计值会考虑到网络的变化,比如传输延迟的波动。

-

往返时间(RTT)估计:

- RTT是指一个数据段从发送到收到确认所花费的时间。

- TCP发送端根据过去的数据传输经验计算RTT的平均值和方差,以此来设置重传定时器的超时时间。

-

超时时间的动态调整:

- 如果网络状况良好,且数据确认及时到达,TCP会减少超时时间,以提高数据传输效率。

- 如果网络状况不佳或者出现数据段丢失,TCP会增加超时时间,以减少不必要的重传和网络拥塞。

-

指数退避:

- 在连续的重传失败后,TCP会采用指数退避策略来调整重传定时器的超时时间,即每次重传超时时间翻倍,以避免在网络状况差的情况下频繁重传。

通过这种动态调整机制,TCP能够在不同的网络条件下平衡数据传输的效率和可靠性。这个内部定时器是TCP协议的一部分,其实现细节由操作系统的TCP/IP协议栈负责。

1.3 重传策略优化(Retransmission Strategy Optimization)

为了提高TCP传输性能,降低重传带来的延迟,我们可以从以下几个方面对TCP重传策略进行优化:

(1)优化重传计时器(Optimizing Retransmission Timer)

调整重传计时器的超时阈值,使其更适应当前网络环境。例如,采用自适应调整策略,结合往返时间(RTT)和往返时间变化(RTTVAR)动态调整重传超时(RTO)值。减小不必要的重传延迟,提高TCP传输性能。

(2)启用快速重传与快速恢复(Enabling Fast Retransmission and Fast Recovery)

快速重传与快速恢复机制可以减小因数据包丢失导致的延迟。当发送方连续收到三个重复确认报文时,立即进行重传,而不再等待重传计时器超时。快速恢复算法则在快速重传之后,允许发送方继续传输新数据包,避免全局同步现象,提高网络吞吐量。

(3)使用选择性确认(Selective Acknowledgment)

启用选择性确认(SACK)机制,让接收方更精确地告知发送方哪些数据包已收到,哪些需要重传。这样,发送方可以避免不必要的全量重传,仅补发丢失的数据包,提高传输效率。

(4)优化拥塞控制算法(Optimizing Congestion Control Algorithms)

选择更适合当前网络环境的拥塞控制算法,如CUBIC、BBR等,以降低拥塞触发的重传。这些算法可以更有效地控制发送速率,避免因拥塞导致的数据包丢失和延迟增加。

(5)利用前向纠错技术(Forward Error Correction, FEC)

前向纠错技术可以在不增加重传次数的情况下,提高数据传输的可靠性。通过在数据包中添加冗余信息,接收方可以在收到部分损坏或丢失的数据包时,仍然尝试恢复原始数据。这样,即使在丢包率较高的网络环境下,也可以保证数据传输的完整性和准确性。

通过优化重传策略,我们可以在不影响TCP可靠性的前提下,提高网络性能和用户体验。具体的优化方法需要根据实际网络环境和应用需求进行选择和调整。

二、TCP超时(TCP Timeout)

2.1 超时检测原理(Timeout Detection Principles)

TCP超时是指发送方在发送数据包后等待接收方返回确认报文的过程中,未能在预定的时间内收到确认报文。超时检测是TCP协议中确保数据可靠传输的关键机制之一。在本节中,我们将详细讨论TCP超时检测的原理。

(1)往返时间(Round-Trip Time, RTT)

往返时间是指数据包从发送方发送出去到接收方返回确认报文所需的时间。发送方需要对RTT进行估算,以便根据网络状况设置合适的超时阈值。RTT的估算通常基于已发送且已确认的数据包所需的时间。

(2)重传超时(Retransmission Timeout, RTO)

RTO是发送方等待接收方返回确认报文的最大时间。当发送方在RTO内未收到确认报文时,将触发重传机制。为了适应不同网络环境,发送方需要根据RTT动态调整RTO值。

(3)加权平均往返时间(Smoothed Round-Trip Time, SRTT)与往返时间变化(Round-Trip Time Variation, RTTVAR)

TCP发送方通常使用加权平均往返时间(SRTT)和往返时间变化(RTTVAR)来估算当前网络的RTT。SRTT是对历史RTT的加权平均值,而RTTVAR是历史RTT的变化幅度。这两个值结合起来,可以更准确地反映网络状况,帮助发送方设置合适的RTO。

(4)Karn/Partridge算法

Karn/Partridge算法是一种用于处理重传数据包的RTT估算问题的方法。当数据包被重传时,直接使用原始RTT可能会导致RTO的误估计。Karn/Partridge算法通过在重传过程中不更新SRTT和RTTVAR值,避免了误估计问题,提高了超时检测的准确性。

综上所述,TCP超时检测原理主要包括RTT估算、RTO设置、SRTT与RTTVAR计算以及Karn/Partridge算法。了解这些原理有助于我们更好地理解TCP超时机制,并为优化网络性能提供依据。

2.2 超时检测优化(Timeout Detection Optimization)

为了减小TCP超时对网络性能的影响,我们可以从以下几个方面对超时检测机制进行优化:

(1)准确估算往返时间(Accurate RTT Estimation)

提高往返时间估算的准确性有助于设置合适的重传超时阈值。发送方可以通过对历史RTT进行加权平均和计算RTT变化幅度来估算当前网络的RTT。更准确的RTT估算可以避免过早或过晚触发重传,提高网络性能。

(2)动态调整重传超时(Dynamic RTO Adjustment)

根据网络状况动态调整重传超时阈值。发送方可以结合SRTT和RTTVAR值来计算合适的RTO。动态调整RTO可以使发送方更灵敏地响应网络变化,减小不必要的重传延迟。

(3)使用更准确的超时检测算法(Employing More Accurate Timeout Detection Algorithms)

选择更准确的超时检测算法,如Karn/Partridge算法,以提高超时检测的准确性。Karn/Partridge算法可以在处理重传数据包时避免误估计问题,从而提高超时检测的准确性和网络性能。

(4)尝试使用更先进的传输协议(Exploring Advanced Transport Protocols)

考虑使用一些具有更优超时检测机制的先进传输协议,如QUIC。QUIC协议使用单一的加密连接,减少了握手和超时的延迟。此外,QUIC还采用了一种新的丢包恢复机制,可以在不依赖重传超时的情况下进行数据包重传,从而降低延迟。

通过优化超时检测机制,我们可以在保持TCP可靠性的同时,降低超时对网络性能的影响。具体的优化方法需要根据实际网络环境和应用需求进行选择和调整。

2.3 超时对网络性能的影响(Impact of Timeout on Network Performance)

TCP超时机制在确保数据传输可靠性的同时,对网络性能产生了一定的影响。在本节中,我们将讨论超时如何影响网络性能。

(1)延迟增加(Increased Latency)

当TCP超时发生时,发送方需要等待重传计时器超时后才能重新发送数据包。这会增加数据传输的总时长,从而导致网络延迟的增加。在丢包率较高的网络环境下,延迟问题可能会变得更为严重。

(2)吞吐量降低(Decreased Throughput)

TCP超时可能导致发送方的发送窗口减小,从而限制了发送速率。由于发送方需要等待确认报文,较长的超时时间可能导致发送方长时间处于等待状态,进一步降低了网络吞吐量。

(3)拥塞控制受影响(Affected Congestion Control)

TCP超时与拥塞控制密切相关。当超时发生时,发送方通常会认为网络出现拥塞,从而触发拥塞控制算法。这会导致发送方降低发送速率,以减轻网络拥塞。然而,在某些情况下,过早或过晚的超时可能导致拥塞控制算法的误判,影响网络性能。

(4)全局同步现象(Global Synchronization)

TCP超时可能导致全局同步现象。当多个TCP连接同时经历超时和重传时,它们的发送窗口大小和发送速率可能会同步减小,从而导致网络吞吐量的波动。全局同步现象可能导致网络资源的浪费和性能下降。

通过理解超时对网络性能的影响,我们可以更好地优化TCP协议,提高网络性能。在实际应用中,我们可以通过调整超时检测策略、优化拥塞控制算法以及尝试使用先进的传输协议等方法来降低超时对网络性能的影响。

2.4 Linux C++ TCP超时检测代码

示例一:setsockopt设置超时时间

#include <iostream>

#include <sys/socket.h>

#include <netinet/in.h>

#include <arpa/inet.h>

#include <unistd.h>

#include <string.h>

#include <stdexcept>

int main() {

int sockfd = socket(AF_INET, SOCK_STREAM, 0);

if (sockfd < 0) {

perror("socket creation failed");

return -1;

}

struct sockaddr_in server_addr;

memset(&server_addr, 0, sizeof(server_addr));

server_addr.sin_family = AF_INET;

server_addr.sin_port = htons(12345);

inet_pton(AF_INET, "127.0.0.1", &server_addr.sin_addr);

if (connect(sockfd, (struct sockaddr*)&server_addr, sizeof(server_addr)) < 0) {

perror("connect failed");

close(sockfd);

return -1;

}

// 设置接收超时

struct timeval timeout;

timeout.tv_sec = 3; // 超时时间设置为3秒

timeout.tv_usec = 0;

if (setsockopt(sockfd, SOL_SOCKET, SO_RCVTIMEO, (char *)&timeout, sizeof(timeout)) < 0) {

perror("setsockopt failed");

close(sockfd);

return -1;

}

char buffer[1024];

ssize_t recv_len = recv(sockfd, buffer, sizeof(buffer) - 1, 0);

if (recv_len < 0) {

if (errno == EWOULDBLOCK || errno == EAGAIN) {

std::cout << "TCP receive timeout" << std::endl;

} else {

perror("recv failed");

}

close(sockfd);

return -1;

}

buffer[recv_len] = '\0';

std::cout << "Received message: " << buffer << std::endl;

close(sockfd);

return 0;

}

示例二:通过select设置超时时间

#include <iostream>

#include <sys/socket.h>

#include <netinet/in.h>

#include <arpa/inet.h>

#include <unistd.h>

#include <string.h>

#include <sys/select.h>

int main() {

int sockfd = socket(AF_INET, SOCK_STREAM, 0);

if (sockfd < 0) {

perror("socket creation failed");

return -1;

}

struct sockaddr_in server_addr;

memset(&server_addr, 0, sizeof(server_addr));

server_addr.sin_family = AF_INET;

server_addr.sin_port = htons(12345);

inet_pton(AF_INET, "127.0.0.1", &server_addr.sin_addr);

if (connect(sockfd, (struct sockaddr*)&server_addr, sizeof(server_addr)) < 0) {

perror("connect failed");

close(sockfd);

return -1;

}

fd_set read_fds;

FD_ZERO(&read_fds);

FD_SET(sockfd, &read_fds);

// 设置超时时间为3秒

struct timeval timeout;

timeout.tv_sec = 3;

timeout.tv_usec = 0;

int max_fd = sockfd + 1;

int result = select(max_fd, &read_fds, nullptr, nullptr, &timeout);

if (result < 0) {

perror("select failed");

close(sockfd);

return -1;

} else if (result == 0) {

std::cout << "TCP receive timeout" << std::endl;

close(sockfd);

return -1;

} else {

if (FD_ISSET(sockfd, &read_fds)) {

char buffer[1024];

ssize_t recv_len = recv(sockfd, buffer, sizeof(buffer) - 1, 0);

if (recv_len < 0) {

perror("recv failed");

close(sockfd);

return -1;

}

buffer[recv_len] = '\0';

std::cout << "Received message: " << buffer << std::endl;

}

}

close(sockfd);

return 0;

}

三、TCP拥塞控制与重传(TCP Congestion Control and Retransmission)

3.1 重传与超时的实际应用场景(Practical Application Scenarios of Retransmission and Timeout)

TCP重传与超时机制在不同类型的网络应用场景中发挥着关键作用。本节将介绍几个实际应用场景,说明重传与超时在这些场景中的重要性。

(1)文件传输(File Transfer)

在文件传输应用中,如FTP和HTTP文件下载,数据的完整性和正确性至关重要。TCP重传与超时机制可以确保数据包在传输过程中的可靠性,即使在网络环境不稳定的情况下也能保证文件完整无误地传输。

(2)实时通信(Real-time Communication)

实时通信应用,如VoIP和视频会议,对延迟和数据完整性有较高要求。TCP重传与超时机制可以在一定程度上确保数据传输的可靠性。然而,由于实时通信对延迟非常敏感,过多的重传和超时可能导致通信质量下降。因此,在实时通信场景中,需要权衡可靠性与延迟,可能会采用其他协议如UDP来传输实时数据。

(3)在线游戏(Online Gaming)

在线游戏通常对延迟和数据完整性都有较高要求。游戏中的关键数据,如玩家操作和状态更新,需要通过TCP重传与超时机制确保可靠传输。同时,为了降低延迟,游戏开发者需要对重传策略和超时检测进行优化,以提高游戏性能和用户体验。

(4)流媒体传输(Streaming Media)

流媒体传输应用,如在线视频和音频播放,通常需要在保证数据传输可靠性的同时,降低延迟和缓冲。TCP重传与超时机制可以确保流媒体数据的正确传输,但过多的重传和超时可能导致播放卡顿。在这些场景中,可能会采用自适应流传输技术,结合TCP和其他协议如UDP,实现高效的数据传输。

综上所述,TCP重传与超时机制在不同类型的网络应用场景中具有重要作用。理解这些应用场景及其对重传与超时的要求,有助于我们更好地优化网络性能和提高用户体验。

3.2 重传与超时的挑战与改进方向(Challenges and Improvement Directions of Retransmission and Timeout)

TCP重传与超时机制在保证数据传输可靠性方面发挥了关键作用,但在实际应用中仍然面临一些挑战。本节将讨论这些挑战及改进方向。

(1)准确识别丢包原因(Accurate Identification of Packet Loss Causes)

在TCP传输过程中,数据包丢失可能是由于网络拥塞或其他原因(如链路错误)导致的。发送方需要准确识别丢包原因,以采取合适的重传策略。然而,当前的TCP重传与超时机制很难准确识别丢包原因,可能导致误判和性能下降。未来的改进方向包括研究更准确的丢包识别技术,以提高重传策略的智能性。

(2)区分不同应用场景的需求(Distinguishing Different Application Scenario Requirements)

不同类型的网络应用对重传与超时的要求各异。例如,实时通信和在线游戏对延迟敏感,而文件传输和流媒体传输则更关注数据完整性。未来的TCP协议改进需要针对不同应用场景,提供更灵活的重传与超时策略。

(3)提高网络拥塞控制效果(Enhancing Network Congestion Control)

TCP重传与超时机制与网络拥塞控制密切相关。当前的拥塞控制算法可能在某些情况下出现误判,影响网络性能。未来的改进方向包括研究更准确和高效的拥塞控制技术,降低重传与超时对网络性能的影响。

(4)探索新型传输协议(Exploring New Transport Protocols)

考虑到TCP协议的局限性,研究人员和工程师正在开发新型传输协议以提高网络性能。例如,QUIC协议在传统TCP协议的基础上,引入了一系列改进措施,如加密连接、更有效的丢包恢复机制等。探索新型传输协议有助于解决TCP重传与超时机制面临的挑战,提升网络性能。

通过应对这些挑战并采取相应的改进措施,我们可以进一步提高TCP重传与超时机制的性能,更好地满足不同网络应用场景的需求。

3.3 评估与监控重传与超时的方法(Evaluation and Monitoring Methods for Retransmission and Timeout)

为了优化TCP重传与超时机制,我们需要对其进行评估与监控。本节将介绍几种用于评估与监控重传与超时的方法。

(1)网络抓包工具(Packet Sniffing Tools)

网络抓包工具,如Wireshark,可以捕获经过网络接口的数据包,帮助我们分析TCP连接中的重传与超时现象。通过分析抓取到的数据包,我们可以计算丢包率、重传次数、重传超时等指标,从而评估TCP重传与超时机制的效果。

(2)网络性能测试工具(Network Performance Testing Tools)

网络性能测试工具,如Iperf,可以在两个网络节点之间建立TCP连接,以测量网络延迟、吞吐量等性能指标。通过这些工具,我们可以评估TCP重传与超时机制对网络性能的影响,从而进行优化。

(3)应用层性能监控(Application-layer Performance Monitoring)

在应用层,我们可以通过监控应用的响应时间、吞吐量等指标来评估TCP重传与超时机制的效果。例如,我们可以使用APM(Application Performance Management)工具来收集和分析应用性能数据,从而找出与重传与超时相关的性能瓶颈。

(4)机器学习与大数据分析(Machine Learning and Big Data Analysis)

借助机器学习与大数据分析技术,我们可以从海量的网络数据中挖掘出有关TCP重传与超时的信息。通过训练机器学习模型,我们可以预测网络中可能出现的重传与超时现象,从而提前采取措施进行优化。

(5)仿真与建模(Simulation and Modeling)

通过建立TCP协议的仿真模型,我们可以在受控的环境中评估不同重传与超时策略对网络性能的影响。例如,我们可以使用NS-3等网络模拟器来模拟TCP连接,研究不同网络条件下的重传与超时行为。

通过采用这些评估与监控方法,我们可以更好地了解TCP重传与超时机制的运行情况,从而针对性地进行优化,提高网络性能。

3.4 Linux C++ 代码示例

#include <iostream>

#include <sys/socket.h>

#include <netinet/in.h>

#include <arpa/inet.h>

#include <unistd.h>

#include <cstring>

#include <ctime>

#include <chrono>

#define SERVER_IP "127.0.0.1"

#define PORT 8080

#define BUFFER_SIZE 1024

#define TIMEOUT_DURATION 500 // ms

bool send_with_timeout(int sockfd, const char *buffer, size_t len, int flags, unsigned int max_retries) {

auto start = std::chrono::steady_clock::now();

auto end = std::chrono::steady_clock::now();

std::chrono::milliseconds timeout(TIMEOUT_DURATION);

// 当前重传次数

unsigned int retries = 0;

while (retries < max_retries) {

ssize_t sent = send(sockfd, buffer, len, flags);

// 数据发送成功,返回 true

if (sent == len) {

return true;

}

end = std::chrono::steady_clock::now();

// 超时,增加重传次数,重置计时

if (std::chrono::duration_cast<std::chrono::milliseconds>(end - start) > timeout) {

retries++;

start = std::chrono::steady_clock::now();

}

}

// 达到最大重传次数仍未成功发送,返回 false

return false;

}

int main() {

int client_fd;

struct sockaddr_in server_addr;

char buffer[BUFFER_SIZE];

// 创建socket

client_fd = socket(AF_INET, SOCK_STREAM, 0);

// 设置服务器地址

server_addr.sin_family = AF_INET;

server_addr.sin_addr.s_addr = inet_addr(SERVER_IP);

server_addr.sin_port = htons(PORT);

// 连接到服务器

connect(client_fd, (struct sockaddr *)&server_addr, sizeof(server_addr));

// 与服务器进行数据通信

size_t window_size = 1;

size_t num_packets_sent = 0;

size_t num_acks_received = 0;

while (true) {

// 发送数据

for (size_t i = 0; i < window_size && num_packets_sent < 10; ++i) {

std::string packet = "Packet " + std::to_string(num_packets_sent);

std::cout << "Sending: " << packet << std::endl;

send_with_timeout(client_fd, packet.c_str(), packet.size(), 0, 3);

++num_packets_sent;

}

// 接收ACK

memset(buffer, 0, BUFFER_SIZE);

int read_size = recv(client_fd, buffer, BUFFER_SIZE, 0);

if (read_size <= 0) {

break;

}

std::cout << "Received ACK: " << buffer << std::endl;

++num_acks_received;

// 调整窗口大小

if (num_acks_received == num_packets_sent) {

window_size *= 2;

} else {

window_size = 1;

}

}

// 关闭连接

close(client_fd);

return 0;

}

四、TCP流量控制与重传(TCP Flow Control and Retransmission)

4.1 Selective Acknowledgment(SACK)机制(Selective Acknowledgment Mechanism)

为了进一步优化TCP重传与超时机制,研究人员和工程师们引入了选择性确认(Selective Acknowledgment,简称SACK)机制。本节将介绍SACK机制的基本原理及其优势。

(1)SACK机制的基本原理(Basic Principles of SACK Mechanism)

传统的TCP确认机制采用累积确认,接收方只确认按顺序接收到的最后一个数据包。当网络环境较差时,这种机制可能导致多次不必要的重传。SACK机制允许接收方更精确地确认接收到的数据包,即使这些数据包是乱序接收的。

在SACK机制中,接收方可以通过SACK选项(SACK Option)在TCP报文中携带接收到的非连续数据段信息,通知发送方正确接收到的数据包。发送方根据接收到的SACK信息,仅重传未被确认的数据包,从而减少不必要的重传。

(2)SACK机制的优势(Advantages of SACK Mechanism)

- 减少不必要的重传(Reducing Unnecessary Retransmissions):SACK机制可以帮助发送方准确地了解接收方已接收到的数据包,从而减少不必要的重传,提高网络性能。

- 提高拥塞控制效果(Enhancing Congestion Control):SACK机制可以减轻因重传导致的网络拥塞,从而提高拥塞控制效果。

- 适应乱序数据包的传输环境(Adapting to Out-of-order Packet Transmission Environments):SACK机制在乱序数据包较多的传输环境中具有更好的性能,例如,对于使用多路径传输(Multipath Transmission)的网络,SACK能有效地提高数据传输的可靠性和效率。

通过引入SACK机制,TCP协议能够更有效地处理数据包丢失和乱序的问题,进一步提高数据传输的可靠性与性能。

4.2 快速重传与快速恢复(Fast Retransmit and Fast Recovery)

快速重传与快速恢复是TCP协议中的两种优化机制,用于减少不必要的重传超时等待,从而提高网络性能。本节将介绍快速重传与快速恢复的基本原理及其优势。

(1)快速重传(Fast Retransmit)

快速重传机制的目的是在等待重传超时之前就检测到数据包丢失,并尽快进行重传。在TCP连接中,当接收方连续收到三个重复的ACK时,发送方认为最早的未确认数据包已丢失,并立即进行重传,而不需要等待重传计时器超时。这样可以降低数据包丢失时的等待时间,提高数据传输的效率。

(2)快速恢复(Fast Recovery)

快速恢复机制是在快速重传之后启动的,用于在一轮重传过程中更快地恢复拥塞窗口。当发送方进入快速恢复阶段时,它会把拥塞窗口减半,而不是像在传统拥塞控制中那样将拥塞窗口重置为1。这可以避免窗口大小过小导致的网络吞吐量下降。同时,发送方还会根据接收到的新ACK信息来调整拥塞窗口,以便在恢复期间继续发送数据。

(3)快速重传与快速恢复的优势(Advantages of Fast Retransmit and Fast Recovery)

- 减少重传延迟(Reducing Retransmission Delay):快速重传机制可以在重传计时器超时之前检测到数据包丢失,从而减少重传延迟。

- 避免全局同步(Avoiding Global Synchronization):快速恢复机制可以避免因窗口大小重置而导致的全局同步现象,保持网络吞吐量的稳定性。

- 提高拥塞控制效果(Enhancing Congestion Control):快速重传与快速恢复机制可以在一定程度上降低拥塞控制对网络性能的负面影响,从而提高网络性能。

综上所述,快速重传与快速恢复作为TCP协议的优化机制,可以显著提高网络性能,降低数据包丢失时的等待时间,提高数据传输的可靠性和效率。

4.3 拥塞窗口已验证的快速重传(TCP NewReno)

拥塞窗口已验证的快速重传,即TCP NewReno,是TCP Reno的一个改进版本,用于解决多个数据包同时丢失时的性能问题。本节将介绍TCP NewReno的基本原理及其优势。

(1)TCP NewReno的基本原理(Basic Principles of TCP NewReno)

TCP Reno在处理多个数据包丢失时存在一定的局限性,因为它只能在一轮超时周期内恢复一个丢失的数据包。TCP NewReno改进了这一问题,使得在一个超时周期内可以恢复多个丢失的数据包。

在TCP NewReno中,当发送方收到三个重复的ACK后,它会进入快速恢复阶段,同时设置一个“部分ACK”标志。当发送方收到部分ACK时,它会重传未被确认的数据包,而不是等待重传计时器超时。这样,在一个超时周期内,TCP NewReno可以恢复多个丢失的数据包。

(2)TCP NewReno的优势(Advantages of TCP NewReno)

- 更高效的丢包恢复(More Efficient Packet Loss Recovery):TCP NewReno可以在一个超时周期内恢复多个丢失的数据包,提高丢包恢复的效率。

- 降低重传延迟(Reducing Retransmission Delay):通过在收到部分ACK时立即重传未被确认的数据包,TCP NewReno可以减少重传延迟。

- 改善拥塞控制(Improved Congestion Control):TCP NewReno可以更好地处理多个数据包丢失的情况,从而提高拥塞控制的效果。

总之,TCP NewReno作为TCP Reno的改进版本,可以更有效地处理多个数据包丢失的情况,提高网络性能和数据传输的可靠性。通过采用TCP NewReno,我们可以进一步优化TCP重传与超时机制,以满足不同网络应用场景的需求。

4.4 流量控制和重传的实现步骤

- 导入必要的库:使用C++实现TCP流量控制和重传时,需要导入如下库:

#include <iostream> #include <cstdlib> #include <cstring> #include <unistd.h> #include <arpa/inet.h> #include <sys/socket.h> #include <netinet/in.h> #include <netinet/tcp.h> #include <fcntl.h> #include <errno.h> - 创建套接字:创建一个TCP套接字,并绑定到指定的地址和端口。然后使用

listen()函数监听连接请求。int sockfd = socket(AF_INET, SOCK_STREAM, IPPROTO_TCP); - 设置套接字选项:为了实现流量控制和重传,需要设置一些套接字选项,如TCP_NODELAY(禁用Nagle算法)和TCP_QUICKACK(启用快速确认)。

int flag = 1; setsockopt(sockfd, IPPROTO_TCP, TCP_NODELAY, (char *)&flag, sizeof(int)); setsockopt(sockfd, IPPROTO_TCP, TCP_QUICKACK, (char *)&flag, sizeof(int)); - 连接和接收数据:使用

accept()函数接收客户端连接,并创建一个新的套接字。然后使用recv()函数接收数据。int client_sock = accept(sockfd, (struct sockaddr *)&client_addr, &addr_len); char buffer[1024]; ssize_t bytes_received = recv(client_sock, buffer, sizeof(buffer), 0); - 实现流量控制:使用滑动窗口算法来实现流量控制。可以使用

setsockopt()函数设置SO_SNDBUF(发送缓冲区大小)和SO_RCVBUF(接收缓冲区大小)选项,以调整滑动窗口的大小。int send_buffer_size = 4096; int recv_buffer_size = 4096; setsockopt(sockfd, SOL_SOCKET, SO_SNDBUF, &send_buffer_size, sizeof(send_buffer_size)); setsockopt(sockfd, SOL_SOCKET, SO_RCVBUF, &recv_buffer_size, sizeof(recv_buffer_size)); - 实现重传机制:可以使用

select()函数或poll()函数监视套接字的可读性和可写性,以实现超时和重传机制。同时,可以使用setsockopt()函数设置TCP_USER_TIMEOUT选项,以指定重传超时时间。struct timeval timeout; timeout.tv_sec = 5; timeout.tv_usec = 0; fd_set read_fds; FD_ZERO(&read_fds); FD_SET(client_sock, &read_fds); int user_timeout = 5000; setsockopt(client_sock, IPPROTO_TCP, TCP_USER_TIMEOUT, &user_timeout, sizeof(user_timeout)); int ret = select(client_sock + 1, &read_fds, nullptr, nullptr, &timeout); if (ret < 0) { perror("select"); } else if (ret == 0) { std::cout << "Timeout, retransmitting data..." << std::endl; } else { if (FD_ISSET(client_sock, &read_fds)) { ssize_t bytes_received = recv(client_sock, buffer, sizeof(buffer), 0); // 处理接收到的数据 } } - 发送数据:使用

send()函数发送数据。在发送数据之前,可以检查套接字的可写性,以防止阻塞。ssize_t bytes_sent = send(client_sock, buffer, strlen(buffer), 0); - 关闭套接字:在完成数据传输后,使用

close()函数关闭套接字。close(client_sock); close(sockfd);

以上代码仅提供了一个简单的概述,用于实现TCP流量控制和重传。实际应用中,您需要根据具体需求对代码进行调整和优化。

4.5 流量控制和重传的完整代码

在代码中,我们使用一个名为unacked_packets的向量来存储未确认的数据包。每个数据包都有一个序列号,用于在发送方和接收方之间识别特定的数据包。接收方在成功接收一个数据包后,会向发送方发送一个确认消息(ACK),其中包含确认接收的数据包的序列号。

发送方在接收到ACK后,会检查unacked_packets向量,并根据接收到的ACK序列号更新它。向量中所有具有小于或等于ACK序列号的序列号的数据包都被视为已确认,因为这意味着接收方已经接收到了这些数据包。

#include <iostream>

#include <cstring>

#include <unistd.h>

#include <arpa/inet.h>

#include <sys/socket.h>

#include <netinet/in.h>

#include <netinet/tcp.h>

#include <sys/select.h>

#include <string>

#include <algorithm>

#include <vector>

#include <thread>

#define USE_SEPARATE_SEQUENCE_NUMBERS 1

struct Packet {

#if USE_SEPARATE_SEQUENCE_NUMBERS

uint32_t seq_number;

#endif

char data[1024];

int retry_count;

};

void retransmit_data(int client_sock, std::vector<Packet>& unacked_packets) {

const int max_retries = 5; // Maximum number of retransmission attempts

const int initial_backoff = 1000; // Initial backoff time in milliseconds (1 second)

std::vector<Packet> new_unacked_packets;

for (auto& packet : unacked_packets) {

// Check if the retry counter has reached the maximum number of attempts

if (packet.retry_count >= max_retries) {

#if USE_SEPARATE_SEQUENCE_NUMBERS

std::cerr << "Maximum number of retransmission attempts reached for sequence number: "

<< packet.seq_number << std::endl;

#else

std::cerr << "Maximum number of retransmission attempts reached for the packet" << std::endl;

#endif

continue;

}

// Send the packet

ssize_t bytes_sent = send(client_sock, &packet, sizeof(packet), 0);

// Error in send()

if (bytes_sent < 0) {

std::cerr << "Error in send: " << strerror(errno) << std::endl;

} else {

#if USE_SEPARATE_SEQUENCE_NUMBERS

std::cout << "Data retransmitted. Sequence number: " << packet.seq_number << std::endl;

#else

std::cout << "Data retransmitted." << std::endl;

#endif

// Increment the retry counter

++packet.retry_count;

// Apply exponential backoff

int backoff_time = initial_backoff * (1 << (packet.retry_count - 1));

std::this_thread::sleep_for(std::chrono::milliseconds(backoff_time));

new_unacked_packets.push_back(packet);

}

}

unacked_packets.swap(new_unacked_packets);

}

int main(int argc, char *argv[]) {

std::vector<Packet> unacked_packets;

// 1. 创建套接字

int sockfd = socket(AF_INET, SOCK_STREAM, IPPROTO_TCP);

if (sockfd < 0) {

std::cerr << "Error in socket: " << strerror(errno) << std::endl;

return -1;

}

// 2. 绑定地址和端口

struct sockaddr_in server_addr;

memset(&server_addr, 0, sizeof(server_addr));

server_addr.sin_family = AF_INET;

server_addr.sin_addr.s_addr = htonl(INADDR_ANY);

server_addr.sin_port = htons(8888);

if (bind(sockfd, (struct sockaddr *)&server_addr, sizeof(server_addr)) < 0) {

std::cerr << "Error in bind: " << strerror(errno) << std::endl;

close(sockfd);

return -1;

}

// 3. 监听连接

if (listen(sockfd, 5) < 0) {

std::cerr << "Error in listen: " << strerror(errno) << std::endl;

close(sockfd);

return -1;

}

// 4. 接受连接

struct sockaddr_in client_addr;

socklen_t addr_len = sizeof(client_addr);

int client_sock = accept(sockfd, (struct sockaddr *)&client_addr, &addr_len);

if (client_sock < 0) {

std::cerr << "Error in accept: " << strerror(errno) << std::endl;

close(sockfd);

return -1;

}

// 5. 设置流量控制

int send_buffer_size = 4096;

int recv_buffer_size = 4096;

setsockopt(client_sock, SOL_SOCKET, SO_SNDBUF, &send_buffer_size, sizeof(send_buffer_size));

setsockopt(client_sock, SOL_SOCKET, SO_RCVBUF, &recv_buffer_size, sizeof(recv_buffer_size));

// 6. 初始化select

fd_set read_fds;

FD_ZERO(&read_fds);

FD_SET(client_sock, &read_fds);

struct timeval timeout;

timeout.tv_sec = 5;

timeout.tv_usec = 0;

// 7. 使用select等待数据

// Initialize a temporary file descriptor set for select()

fd_set temp_fds;

// Main loop

while (true) {

// Update the timeout structure

timeout.tv_sec = 5;

timeout.tv_usec = 0;

// Copy the original file descriptor set (read_fds) to a temporary set (temp_fds)

temp_fds = read_fds;

// Use select() to wait for events on the client socket (data available to read or timeout)

// The last argument (timeout) specifies the maximum time select() should wait for an event

int ret = select(client_sock + 1, &temp_fds, nullptr, nullptr, &timeout);

// Error in select()

if (ret < 0) {

std::cerr << "Error in select: " << strerror(errno) << std::endl;

break;

}

// Timeout occurred, indicating that no ACK was received during the specified time interval

// This is used to detect lost packets and trigger retransmission

else if (ret == 0) {

std::cout << "Timeout, retransmitting data..." << std::endl;

retransmit_data(client_sock, unacked_packets);

continue;

}

// If data is available to read on the client socket, process the ACK

if (FD_ISSET(client_sock, &temp_fds)) {

//从客户端接收到的ACK序列号

uint32_t ack_seq_number;

ssize_t bytes_received;

#if USE_SEPARATE_SEQUENCE_NUMBERS

// Receive the ACK sequence number from the client

bytes_received = recv(client_sock, &ack_seq_number, sizeof(ack_seq_number), 0);

if(bytes_received<=0) goto ret_process;

#endif

Packet data_packet;

// Receive the ACK sequence number and data from the client

bytes_received = recv(client_sock, &data_packet, sizeof(data_packet), 0);

ack_seq_number = data_packet.seq_number;

ret_process:

if (bytes_received < 0) {

std::cerr << "Error in recv: " << std::strerror(errno) << std::endl;

if (errno == EAGAIN || errno == EWOULDBLOCK) { // No data available for reading temporarily

std::this_thread::sleep_for(std::chrono::milliseconds(100)); // Wait for 100ms before continuing the loop

continue;

} else if (errno == ECONNRESET) { // Connection reset by the other party

std::cout << "Connection reset by peer." << std::endl;

close(client_sock); // Close the socket

client_sock = socket(AF_INET, SOCK_STREAM, IPPROTO_TCP); // Create a new socket and reconnect

if (connect(client_sock, (struct sockaddr *)&server_addr, sizeof(server_addr)) < 0) {

std::cerr << "Error in connect: " << strerror(errno) << std::endl;

close(client_sock);

return -1;

}

continue;

} else { // Other error codes

std::cerr << "recv error: " << std::strerror(errno) << std::endl;

break;

}

}

// Client disconnected

else if (bytes_received == 0) {

std::cout << "Client disconnected." << std::endl;

break;

}

// Valid ACK received

else {

// Convert the received sequence number to host byte order

ack_seq_number = ntohl(ack_seq_number);

// Remove the acknowledged packets from the unacked_packets vector

#ifdef USE_SEPARATE_SEQUENCE_NUMBERS

// Handle separate sequence numbers for each packet

unacked_packets.erase(std::remove_if(unacked_packets.begin(), unacked_packets.end(),

[&ack_seq_number](const Packet& packet) {

return packet.seq_number == ack_seq_number;

}), unacked_packets.end());

#else

// Handle cumulative sequence numbers

unacked_packets.erase(std::remove_if(unacked_packets.begin(), unacked_packets.end(),

[&ack_seq_number](const Packet& packet) {

return packet.seq_number <= ack_seq_number;

}), unacked_packets.end());

#endif

std::cout << "Received ACK for sequence number: " << ack_seq_number << std::endl;

std::cout << "Received data: " << data_packet.data << std::endl;

}

}

}

// 8. 关闭套接字

close(client_sock);

close(sockfd);

return 0;

}

客户端:

#include <iostream>

#include <cstring>

#include <unistd.h>

#include <arpa/inet.h>

#include <sys/socket.h>

#include <netinet/in.h>

#include <netinet/tcp.h>

#include <string>

#include <thread>

#define USE_SEPARATE_SEQUENCE_NUMBERS 1

int main(int argc, char *argv[]) {

// 1. 创建套接字

int sockfd = socket(AF_INET, SOCK_STREAM, IPPROTO_TCP);

if (sockfd < 0) {

std::cerr << "Error in socket: " << strerror(errno) << std::endl;

return -1;

}

// 2. 连接到服务器

struct sockaddr_in server_addr;

memset(&server_addr, 0, sizeof(server_addr));

server_addr.sin_family = AF_INET;

server_addr.sin_addr.s_addr = inet_addr("127.0.0.1");

server_addr.sin_port = htons(8888);

if (connect(sockfd, (struct sockaddr *)&server_addr, sizeof(server_addr)) < 0) {

std::cerr << "Error in connect: " << strerror(errno) << std::endl;

close(sockfd);

return -1;

}

// 3. 发送数据和ACK序列号给服务器

uint32_t seq_number = 1;

while (true) {

std::string input;

std::cout << "Enter data to send: ";

std::getline(std::cin, input);

if (input == "exit") {

break;

}

// Convert the sequence number to network byte order

uint32_t network_seq_number = htonl(seq_number);

#if USE_SEPARATE_SEQUENCE_NUMBERS

// Send the ACK sequence number to the server

ssize_t bytes_sent = send(sockfd, &network_seq_number, sizeof(network_seq_number), 0);

if (bytes_sent < 0) {

std::cerr << "Error in send: " << strerror(errno) << std::endl;

break;

}

// Send the data to the server

bytes_sent = send(sockfd, input.c_str(), input.size() + 1, 0);

#else

struct Packet {

uint32_t seq_number;

char data[1024];

};

Packet data_packet;

data_packet.seq_number = network_seq_number;

strncpy(data_packet.data, input.c_str(), sizeof(data_packet.data));

// Send the data packet to the server

ssize_t bytes_sent = send(sockfd, &data_packet, sizeof(data_packet), 0);

#endif

if (bytes_sent < 0) {

std::cerr << "Error in send: " << strerror(errno) << std::endl;

break;

}

std::cout << "Data sent. Sequence number: " << seq_number << std::endl;

// Increment the sequence number

++seq_number;

}

// 4. 关闭套接字

close(sockfd);

return 0;

}

五、TCP重传与超时优化实践(TCP Retransmission and Timeout Optimization Practices)

5.1 引入TCP比较新的拥塞控制算法(Adopting Newer TCP Congestion Control Algorithms)

为了进一步优化TCP重传与超时机制,可以尝试采用一些比较新的拥塞控制算法。这些算法在不同的网络环境下具有更好的性能,可以有效地降低重传延迟和提高网络吞吐量。本节将介绍几种较新的TCP拥塞控制算法。

(1)CUBIC:CUBIC算法是一种面向高带宽网络和长距离传输的拥塞控制算法,通过引入三次方拥塞窗口增长函数,可以更好地平衡网络吞吐量和延迟。CUBIC算法在高速网络中表现尤为出色,可以显著提高数据传输性能。

(2)BBR(Bottleneck Bandwidth and RTT):BBR算法通过估计网络的瓶颈带宽和往返时延来调整拥塞窗口,避免了传统拥塞控制算法中对丢包的过度敏感。BBR算法在拥塞网络和高丢包率的环境中具有较好的性能。

(3)Compound TCP:Compound TCP是一种结合了拥塞窗口和接收窗口调整的拥塞控制算法,旨在改善高带宽网络中的性能。通过同时考虑拥塞窗口和接收窗口,Compound TCP可以更好地平衡网络吞吐量和延迟。

(4)Vegas:Vegas算法通过测量往返时延来预测拥塞,从而提前调整拥塞窗口。Vegas算法在低延迟和低丢包率的网络中表现较好,可以有效地减少拥塞和重传延迟。

通过引入这些较新的TCP拥塞控制算法,我们可以根据不同的网络环境和应用需求选择合适的算法,从而优化TCP重传与超时机制,提高网络性能。

5.2 使用前向纠错技术(Forward Error Correction, FEC)

前向纠错技术(FEC)是一种通过添加冗余数据来提高数据传输可靠性的方法。通过使用FEC,我们可以在一定程度上减少TCP重传的次数,从而降低重传延迟和提高网络性能。本节将介绍FEC的基本原理及其在TCP重传与超时机制中的应用。

(1)FEC的基本原理(Basic Principles of FEC)

FEC通过对原始数据添加冗余信息,使接收方在收到部分损坏或丢失的数据包时仍能重建原始数据。FEC编码的方法有很多,如海明码(Hamming Code)、里德-所罗门码(Reed-Solomon Code)等。这些编码方法可以在不增加太多额外开销的前提下,为数据传输提供一定程度的纠错能力。

(2)FEC在TCP重传与超时机制中的应用(Applications of FEC in TCP Retransmission and Timeout Mechanisms)

在TCP传输中,我们可以通过将FEC技术与传统的TCP重传机制相结合,以降低重传次数和提高网络性能。例如,发送方可以在发送数据包时附加FEC编码后的冗余数据,而接收方在收到部分损坏或丢失的数据包时可以利用这些冗余数据进行纠错,从而避免某些情况下的重传。

需要注意的是,FEC技术虽然可以在一定程度上减少TCP重传,但它会增加一定的计算和带宽开销。因此,在实际应用中,需要权衡FEC带来的性能提升与其开销之间的关系,以找到适合特定场景的最佳解决方案。

总之,FEC技术作为一种提高数据传输可靠性的方法,可以与TCP重传与超时机制相结合,进一步优化网络性能。通过使用FEC,我们可以在保证数据传输可靠性的同时,减少重传次数和降低重传延迟。

5.3 采用多路径传输(Multipath Transmission)

多路径传输是一种通过利用网络中的多条路径同时传输数据的方法,从而提高网络性能和可靠性。在TCP重传与超时机制中,可以通过使用多路径传输来降低数据包丢失的概率,减少重传次数和延迟。本节将介绍多路径传输的基本原理及其在TCP重传与超时机制中的应用。

(1)多路径传输的基本原理(Basic Principles of Multipath Transmission)

在多路径传输中,发送方将数据包分发到多个网络路径上进行传输,接收方则从不同路径上接收这些数据包并对它们进行重组。这样一来,即使某条路径出现问题导致数据包丢失,也可以通过其他路径上的数据包来保证数据的可靠传输。

(2)多路径传输在TCP重传与超时机制中的应用(Applications of Multipath Transmission in TCP Retransmission and Timeout Mechanisms)

在TCP传输中,可以通过实现多路径TCP(MPTCP)来支持多路径传输。MPTCP在传统TCP的基础上进行了扩展,允许在多个网络路径上同时建立TCP连接,从而提高数据传输的可靠性和性能。

通过使用多路径传输,可以降低数据包在单条路径上丢失的概率,从而减少TCP重传的次数和延迟。同时,多路径传输还可以在不同路径之间实现负载均衡,提高网络的吞吐量。

需要注意的是,多路径传输需要对现有的TCP协议进行扩展,可能会带来一定的复杂性。此外,多路径传输对网络中的路径选择和负载均衡策略也有较高的要求。因此,在实际应用中,需要根据具体场景和需求来选择是否采用多路径传输技术。

总之,多路径传输作为一种提高数据传输可靠性和性能的方法,可以与TCP重传与超时机制相结合,进一步优化网络性能。通过采用多路径传输,我们可以在保证数据传输可靠性的同时,降低重传次数和延迟。

5.3 采用多路径传输(Multipath Transmission)

多路径传输是一种通过利用网络中的多条路径同时传输数据的方法,从而提高网络性能和可靠性。在TCP重传与超时机制中,可以通过使用多路径传输来降低数据包丢失的概率,减少重传次数和延迟。本节将介绍多路径传输的基本原理及其在TCP重传与超时机制中的应用。

(1)多路径传输的基本原理(Basic Principles of Multipath Transmission)

在多路径传输中,发送方将数据包分发到多个网络路径上进行传输,接收方则从不同路径上接收这些数据包并对它们进行重组。这样一来,即使某条路径出现问题导致数据包丢失,也可以通过其他路径上的数据包来保证数据的可靠传输。

(2)多路径传输在TCP重传与超时机制中的应用(Applications of Multipath Transmission in TCP Retransmission and Timeout Mechanisms)

在TCP传输中,可以通过实现多路径TCP(MPTCP)来支持多路径传输。MPTCP在传统TCP的基础上进行了扩展,允许在多个网络路径上同时建立TCP连接,从而提高数据传输的可靠性和性能。

通过使用多路径传输,可以降低数据包在单条路径上丢失的概率,从而减少TCP重传的次数和延迟。同时,多路径传输还可以在不同路径之间实现负载均衡,提高网络的吞吐量。

需要注意的是,多路径传输需要对现有的TCP协议进行扩展,可能会带来一定的复杂性。此外,多路径传输对网络中的路径选择和负载均衡策略也有较高的要求。因此,在实际应用中,需要根据具体场景和需求来选择是否采用多路径传输技术。

总之,多路径传输作为一种提高数据传输可靠性和性能的方法,可以与TCP重传与超时机制相结合,进一步优化网络性能。通过采用多路径传输,我们可以在保证数据传输可靠性的同时,降低重传次数和延迟。

六、结语

本博客从TCP重传、超时、拥塞控制、流量控制等方面进行了深入探讨,以帮助读者更好地理解TCP协议在网络传输过程中如何确保数据的可靠性和高效性。我们详细分析了各种重传原理、触发条件和优化策略,以及超时检测、动态调整和与重传的关系。同时,我们还探讨了拥塞控制与流量控制在调整网络传输速率、协同作用以确保网络稳定性的重要性。

在实践中,我们针对不同的网络环境提供了优化策略,并对常见性能问题进行了分析和解决。此外,我们还展望了未来TCP重传与超时的发展趋势,为进一步提高网络性能提供了指导。文章来源:https://www.toymoban.com/news/detail-462828.html

我们相信,本博客对于那些希望深入了解TCP协议以解决网络传输中的挑战的读者具有很高的价值。请您收藏、关注并点赞,让更多的人受益于这些知识。我们期待您在未来的学习和实践中取得更多的成功!文章来源地址https://www.toymoban.com/news/detail-462828.html

到了这里,关于TCP重传与超时机制:解锁网络性能之秘的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!