本教程专注在怎么使用已经开源的模型和项目,构建一个可以私有化部署的问答知识库,而且整体效果要有所保障。

主要工作包括:

- 选择基础模型,openAI,claude 这些商用的,或者其他的开源的,这次我们选择 Vicuna-13B;

- 开源有很多的知识库问答系统,这次我们选择DB-GPT,优点是支持多端的访问;

- 根据项目的整体的要求,尤其是基础模型的要求选择适合的硬件设备,可以选用云服务,这次我们选择阿里云的云服务

- 根据项目说明部署

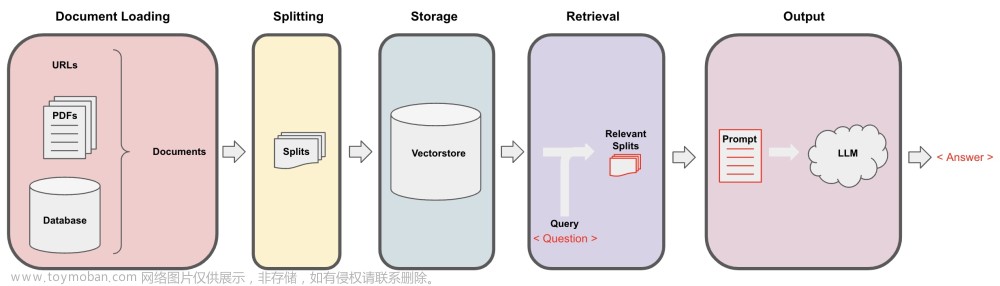

- 该架构主要由五部分组成,依次为知识库、Embedding、向量存储、大模型(如Vicuna-13B)以及生成(Generate)。整体流程是:知识库经过Embedding处理转化为向量形式,然后这些向量存储到数据库中,大模型通过吸收这些向量化的知识,实现推理和总结的能力,最后进行生成。

- 该架构分为四个步骤:知识库准备、Embedding、向量存储和利用大模型的能力。这是一个面向数据库领域的GPT,它准备了主流数据库的文档,并对其进行分类。Embedding阶段将文本转换成向量进行存储,存储媒介是向量数据库。Embedding后的知识会存储在向量数据库中,以备后续检索。最后,利用大模型的能力,通过In-Context-Learning(ICL),使大模型实现基于现有知识的推理、总结。

- 通过这种架构,可以实现一个基于现有知识库的问答(QA)项目。

LangChain是当前最受欢迎的大型语言模型(LLM)框架,它是一个基于LLM的应用开发框架。为了使应用更强大且独特,仅依赖大模型的API是不足的。LangChain的设计理念强调数据思维,即将大模型与其他元数据连接,以及代理思维,让语言模型能与环境互动。这个简单但符合自然法则的设计理念深深吸引了我们,因此我们选择了LangChain。

简单介绍什么是langchain:langchain是一个大语言模型应用开发框架,像django是web应用框架一样,langchain也是我们后面开发基于大语言模型应用的框架。而且可以方便的在应用中集成其他工具,这些工具能够弥补LLM的缺失的能力。

购买阿里云GPU实例

参考DB-GPT官方选择硬件

| GPU型号 | 显存大小 | 性能 |

|---|---|---|

| RTX4090 | 24G | 可以流畅的进行对话推理,无卡顿 |

| RTX3090 | 24G | 可以流畅进行对话推理,有卡顿感,但好于V100 |

| V100 | 16G | 可以进行对话推理,有明显卡顿 |

这次选择在阿里云购买GPU实例,参考如下

选择型号之后,还需要选择系统、GPU驱动、SSD存储、以及实例释放策略等选项。这里需要注意,云盘的规格不要选择太小,建议不小于200G, 同时去掉随实例释放的选项,这样后续我们可以只释放实例,模型数据可以保留。如果此实例,你想长期使用,建议给ECS做个快照备份。当然,考虑到价格原因,也可以挂一块NFS来存储数据

注意,这里推荐勾选不随实例释放,因为模型,显卡,环境,部署每一步都是钱堆上来的,指不定你什么时候就又要本地部署了,所以把这块盘存下来是明智的选择

网络配置

使用自己喜欢的SSH工具登录服务器,例如xshell

基础环境搭建

安装 git git-lfs ,下载模型需要

g++ docker docker.io,部署项目组件需要

apt-get install git git-lfs g++ docker docker.io -y

模型下载

在准备模型阶段,我们首先要下载模型。 这里我们依赖两个基础模型,分别是vicuna-13B以及sentence-transformer

git clone https://github.com/csunny/DB-GPT.git

git clone --progress https://huggingface.co/Tribbiani/vicuna-13b

git clone https://huggingface.co/sentence-transformers/all-MinilM-L6-v2

cd DB-GPT

mkdir models

cd models

mv ../../vicuna-13b/ ./

大概58G,需要一个小时才能下载完成

安装Mysql实例

直接使用官方仓库提供的命令如下:

docker run --name=mysql -p 3306:3306 -e MYSQL ROOT PASSWORD=aa12345678 -dit mysql:latest

安装python环境

python 环境我们要起是大于3.9,这里我们用3.10来进行安装首先我们需要安装conda环境,我们使用miniconda3

wget https://repo.anaconda. com miniconda/Miniconda3-py310 23.3.1-0-Linux-x86 64.sh

sh Miniconda3-py310 23.3.1-0-Linux-x86 64.sh

安装完成之后,需要生效一下环境变量,并创建虚拟环境和激活虚拟环境

source /root/.bashrc

conda create n dbgpt env python=3.10

conda activate dbgpt env

安装依赖

在项目目录下,执行下面的语句

pip install -r requirements.txt

注意,执行如下命令,配置项目路径

echo "/root/DB-GPT”> /root/miniconda3/env/dbgpt_env/lib/python3.10/site packages/dbgpt.pth

启动服务端和客户端 web

# 服务端启动

export PYTHONPATH=SPYTHONPATH:/root/DB-GPT

python pilot/server/llmserver.py

# 客户端启动

export PYTHONPATH=SPYTHONPATH:/root/DB-GPT/

python pilot/server/webserver.py

设置阿里云安全组

配置阿里云的安全组,这些可以在自己机器访问

访问IP:7860,看到什么了文章来源:https://www.toymoban.com/news/detail-464203.html

构建知识库

这样我们可以使用文档构建自己的问答知识库 文章来源地址https://www.toymoban.com/news/detail-464203.html

文章来源地址https://www.toymoban.com/news/detail-464203.html

到了这里,关于基于开源大模型Vicuna-13B构建私有制库问答系统的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!