预计更新

一、 爬虫技术概述

1.1 什么是爬虫技术

1.2 爬虫技术的应用领域

1.3 爬虫技术的工作原理

二、 网络协议和HTTP协议

2.1 网络协议概述

2.2 HTTP协议介绍

2.3 HTTP请求和响应

三、 Python基础

3.1 Python语言概述

3.2 Python的基本数据类型

3.3 Python的流程控制语句

3.4 Python的函数和模块

3.5 Python的面向对象编程

四、 爬虫工具介绍

4.1 Requests库

4.2 BeautifulSoup库

4.3 Scrapy框架

五、 数据存储和处理

5.1 数据存储格式介绍

5.2 数据库介绍

5.3 数据处理和分析

六、 动态网页爬取

6.1 动态网页概述

6.2 Selenium工具介绍

6.3 PhantomJS工具介绍

七、 反爬虫技术

7.1 反爬虫技术概述

7.2 User-Agent伪装

7.3 IP代理池

八、 数据清洗和预处理

8.1 数据清洗和去重

8.2 数据预处理和分析

九、 分布式爬虫和高并发

9.1 分布式爬虫概述

9.2 分布式爬虫框架介绍

9.3 高并发爬虫实现

十、 爬虫实战

10.1 爬取豆瓣电影排行榜

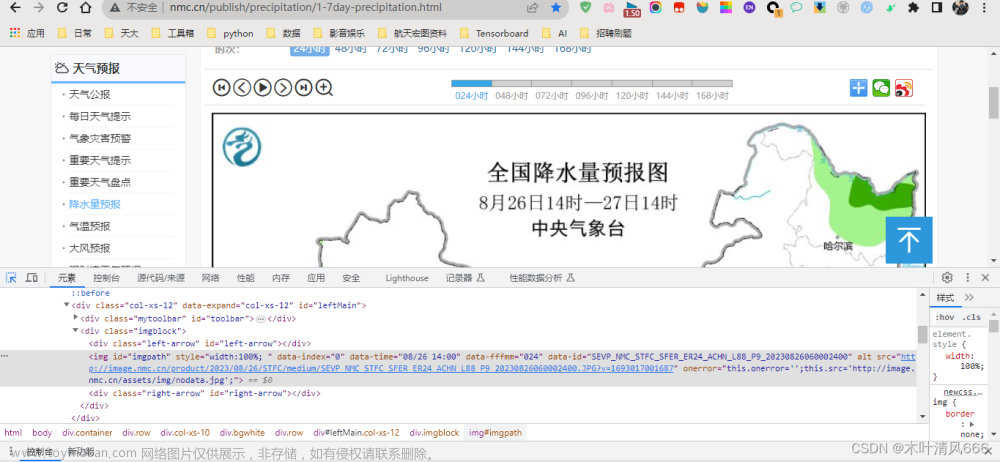

10.2 爬取天气数据

10.3 爬取新闻网站数据

六、 动态网页爬取

6.1 动态网页概述

6.2 Selenium工具介绍

6.3 PhantomJS工具介绍

动态网页概述

一、动态网页概述

随着互联网技术的发展,动态网页逐渐成为了互联网上最为流行的网页类型之一。相比于静态网页,动态网页具有更加丰富和交互性的内容,可以根据用户的需求和交互行为实时生成和更新内容,大大提高了用户的使用体验和网站的互动性。动态网页通常采用动态HTML(Dynamic HTML)技术,通过JavaScript、AJAX等技术实现网页的动态效果和交互功能。

动态网页通常包括两种类型。一种是服务器端动态网页,也称为动态网站,这种网页通过服务器端的程序动态生成网页内容,通常采用PHP、ASP、JSP等技术实现。另一种是客户端动态网页,也称为单页面应用(Single Page Application,SPA),这种网页通过JavaScript等技术在浏览器端动态生成和更新网页内容,通常采用React、Vue、Angular等前端框架实现。

动态网页的出现使得网站的开发和设计变得更加灵活和多样化,同时也给网页爬取带来了更大的挑战。与静态网页相比,动态网页的内容是在用户和服务器之间不断交互和更新的,因此传统的网页爬取方法难以获取到完整的网页内容和数据,需要采用更加高级和复杂的爬虫技术和工具。

二、动态网页的特点

- 实时更新

动态网页的最大特点就是实时更新和动态交互。与静态网页不同,动态网页的内容和数据不是一次性生成的,而是在用户和服务器之间不断交互和更新的。用户可以通过交互操作实时获取最新的网页内容和数据,网页内容也会根据用户的操作和需求实时更新和变化。

- 交互性强

动态网页通常具有更加强大的交互功能。用户可以通过交互操作与网页进行实时的交互,例如填写表单、提交数据、触发事件等。网页通过JavaScript等技术可以对用户的交互行为做出响应,并根据用户的操作实时更新网页内容和数据。

- 动态HTML

动态网页通常采用动态HTML技术(Dynamic HTML,简称DHTML)实现网页的动态效果和交互功能。DHTML是一种结合HTML、CSS、JavaScript等技术实现网页动态效果的技术,可以实现网页的动态更新、动态交互、动态样式等功能。

- 数据库支持

动态网页通常采用服务器端动态网页技术实现,可以通过服务器端的程序动态生成和更新网页内容。这种技术通常需要与数据库结合使用,可以将网页所需的数据存储在数据库中,并通过服务器端程序实时获取和更新数据。

三、动态网页爬取的难点

动态网页的实时更新和动态交互给网页爬取带来了更大的挑战。传统的网页爬取方法通常只能获取到静态网页的内容,难以获取到动态网页的实时更新和交互数据。以下是动态网页爬取的主要难点:

- 动态HTML

动态网页通常采用动态HTML技术实现网页的动态效果和交互功能。这种技术使得网页的内容和数据不是一次性生成的,而是在用户和服务器之间不断交互和更新的。传统的网页爬取方法难以获取到动态HTML生成的内容和数据,需要采用更加高级和复杂的爬虫技术和工具。

- AJAX

AJAX(Asynchronous JavaScript and XML)是一种在浏览器端通过JavaScript和XML实现异步数据交换的技术。动态网页通常采用AJAX技术实现与服务器端的数据交互和实时更新。由于AJAX数据交换是异步的,传统的网页爬取方法难以获取到通过AJAX获取的动态数据。

- 动态加载

动态网页通常采用动态加载技术,即在用户滚动页面时动态加载新的内容,实现网页的无限滚动效果。由于动态加载是通过JavaScript等技术实现的,传统的网页爬取方法难以获取到动态加载的新内容。

- 验证码

为了防止恶意爬取和自动化攻击,动态网页通常会加入验证码等验证机制。验证码通常是通过图片、声音等方式呈现的随机字符或数字,需要用户手动输入才能通过验证。传统的网页爬取方法难以自动识别和破解验证码,需要采用特殊的验证码识别技术和工具。

- 动态URL

动态网页通常采用动态URL,即URL中包含动态参数,通过动态参数来实现网页内容的动态生成和更新。传统的网页爬取方法难以获取到动态URL中的动态参数,需要采用特殊的技术和工具来识别和获取动态参数。

四、动态网页爬取的方法和技术

为了有效地爬取动态网页,需要采用特殊的爬虫方法和技术。以下是一些常用的动态网页爬取方法和技术:

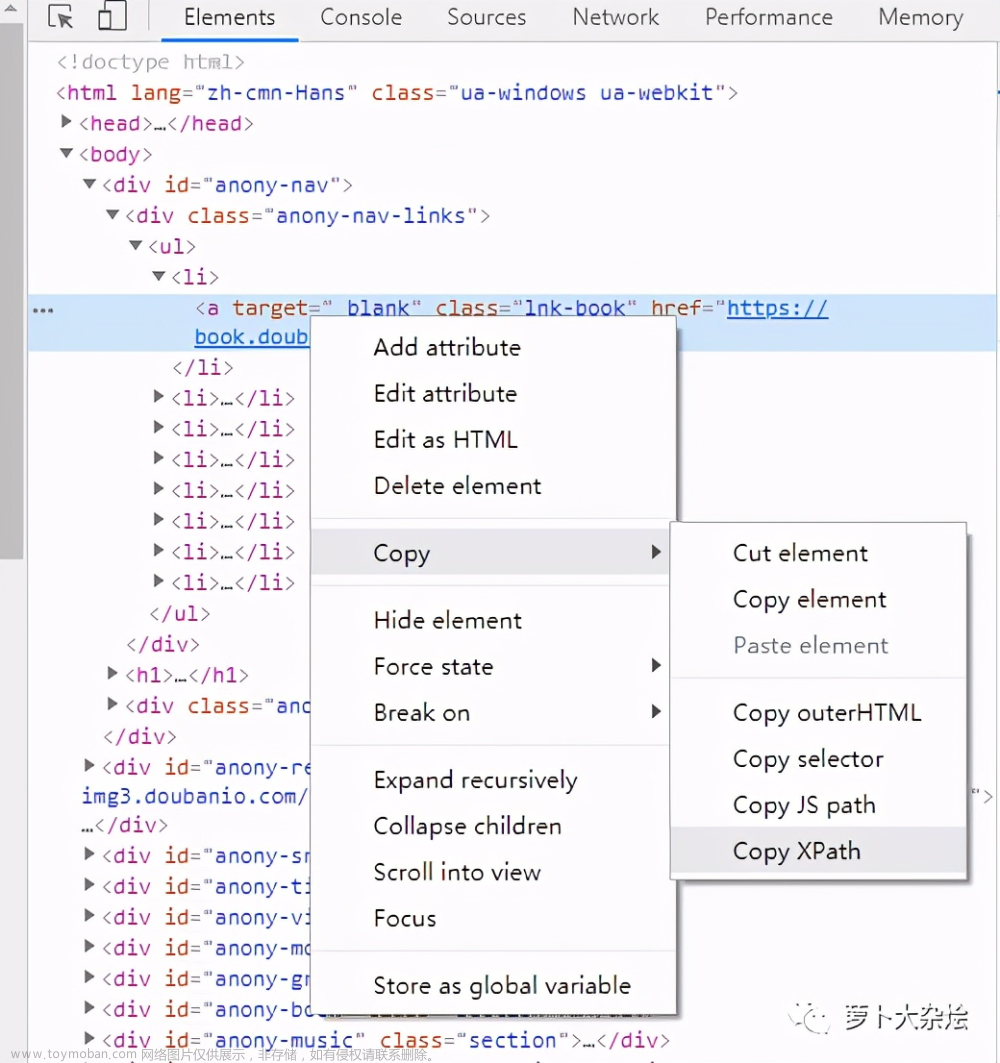

- 分析网页结构

在爬取动态网页之前,需要先分析网页的结构和数据交互方式。可以通过浏览器开发工具等工具来分析网页的HTML、JavaScript、AJAX等代码,了解网页的结构和数据交互方式,以便采用相应的爬虫技术和工具来获取网页内容和数据。

- 模拟浏览器行为

为了获取动态网页的实时更新和交互数据,可以采用模拟浏览器行为的方式来进行爬取。可以使用Selenium等工具来模拟浏览器的操作,自动化地获取网页内容和数据。

- 采用API接口

一些动态网页提供了API接口,可以通过API接口来获取网页的数据。可以通过分析网页源代码和API文档等方式来获取API接口的地址和参数,以便采用API接口来获取网页数据。

- 破解验证码

为了自动化地获取动态网页的数据,需要破解验证码等验证机制。可以采用OCR技术、机器学习等技术来识别验证码,或者通过第三方验证码识别服务来破解验证码。

- 采用代理IP

为了避免被网站封禁IP,可以采用代理IP的方式来进行爬取。可以使用第三方代理IP服务,或者通过自己搭建代理IP服务器来进行爬取。

总之,动态网页爬取需要采用更加高级和复杂的爬虫技术和工具,需要对网页结构和数据交互方式进行深入分析,以便采用相应的爬虫方法和技术来获取网页内容和数据。同时,需要遵守网站的爬虫规则和法律法规,避免恶意爬取和侵犯网站的合法权益。

五、动态网页爬取的注意事项

在进行动态网页爬取时,需要注意以下事项:

- 遵守网站规则

在进行动态网页爬取时,需要遵守网站的爬虫规则。一些网站可能会限制爬虫的频率、并发数等,需要根据网站的规定进行爬取。

- 不侵犯网站权益

在进行动态网页爬取时,需要遵守法律法规,不侵犯网站的合法权益。不得进行恶意爬取、盗取数据等行为,不得使用爬虫进行网络攻击等行为。

- 避免过度请求

在进行动态网页爬取时,需要注意不要过度请求网站,避免对网站的服务器造成负担和影响。可以采用合适的爬虫频率、并发数等设置来控制爬虫的请求量。

- 处理异常情况

在进行动态网页爬取时,需要处理异常情况,如网络超时、服务器错误、验证码错误等。可以采用重试机制、异常处理机制等方式来处理异常情况,保证爬虫的稳定性和可靠性。

- 防止被封禁IP

在进行动态网页爬取时,需要防止被网站封禁IP。可以采用代理IP、IP池等方式来进行爬取,避免对单一IP进行过度请求,同时可以定期更换IP以避免被封禁。

总之,动态网页爬取需要注意遵守网站规则和法律法规,避免侵犯网站的合法权益。同时需要注意爬虫的请求量、稳定性和可靠性,避免对网站服务器造成负担和影响。

Selenium工具介绍

一、Selenium工具介绍

Selenium是一种用于自动化测试Web应用程序的工具。它支持各种浏览器和操作系统,并提供了丰富的API接口,可以模拟用户在浏览器中的操作,例如点击、输入、选择等。Selenium可以用于测试网站的功能、性能和可靠性,也可以用于爬取动态网页。

Selenium提供了多种语言的API接口,包括Java、Python、Ruby、C#等。在使用Selenium进行爬取时,通常使用Python语言编写爬虫程序,并使用Selenium的Python API接口来控制浏览器进行爬取。

二、Selenium的安装和配置

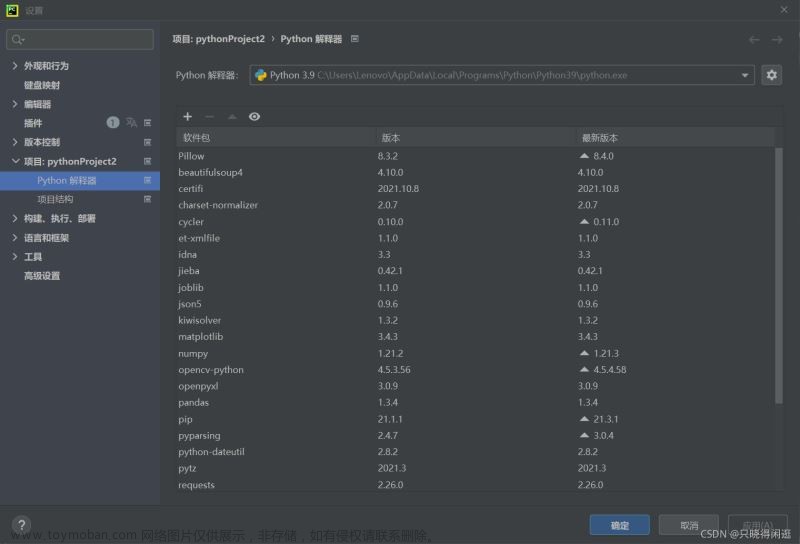

- 安装Python

首先需要安装Python环境,可以从官网下载安装包并安装:https://www.python.org/downloads/

- 安装Selenium

可以通过pip命令来安装Selenium:

pip install selenium

- 安装浏览器驱动程序

Selenium需要使用浏览器驱动程序来控制浏览器进行操作,可以从以下链接下载对应的浏览器驱动程序:

Chrome驱动程序:http://chromedriver.chromium.org/downloads

Firefox驱动程序:https://github.com/mozilla/geckodriver/releases

Safari驱动程序:https://webkit.org/blog/6900/webdriver-support-in-safari-10/

下载后将驱动程序放置到系统PATH环境变量中即可。

三、Selenium的基本用法

- 启动浏览器

使用Selenium可以启动多种浏览器,例如Chrome、Firefox、Safari等。以下是使用Chrome浏览器启动的示例代码:

from selenium import webdriver

driver = webdriver.Chrome()

- 打开网页

使用Selenium可以打开指定的网页,例如:

driver.get("http://www.example.com")

- 查找元素

Selenium提供了多种方法用于查找元素,例如按ID查找、按名称查找、按标签名查找等。以下是按ID查找元素的示例代码:

element = driver.find_element_by_id("element_id")

- 操作元素

使用Selenium可以模拟用户对网页中的元素进行操作,例如点击、输入、选择等。以下是点击按钮的示例代码:

button = driver.find_element_by_id("button_id")

button.click()

- 等待元素加载

在爬取动态网页时,需要等待网页中的元素加载完成后再进行操作,以避免操作失败。Selenium提供了多种等待方式,例如隐式等待和显式等待。以下是使用显式等待等待元素加载的示例代码:

from selenium.webdriver.common.by import By

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

element = WebDriverWait(driver, 10).until(

EC.presence_of_element_located((By.ID, "element_id"))

)

以上代码将等待最多10秒钟,直到ID为"element_id"的元素出现在网页中。

四、Selenium爬取动态网页的实现

在进行动态网页爬取时,可以使用Selenium来模拟用户在浏览器中的操作,以获取网页中的动态内容。以下是使用Selenium进行动态网页爬取的示例代码:

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

driver = webdriver.Chrome()

# 打开网页

driver.get("http://www.example.com")

# 查找元素

input_element = driver.find_element_by_id("input_id")

button_element = driver.find_element_by_id("button_id")

# 输入搜索关键字

input_element.send_keys("search keyword")

# 点击搜索按钮

button_element.click()

# 等待搜索结果加载完成

element = WebDriverWait(driver, 10).until(

EC.presence_of_element_located((By .ID, "result_id"))

)

# 获取搜索结果

result = element.text

# 关闭浏览器

driver.quit()

以上代码使用Chrome浏览器打开了一个网页,并在网页中输入了搜索关键字,点击搜索按钮后等待搜索结果加载完成,并获取了搜索结果的文本内容。

在实际使用中,需要根据网页的具体情况进行操作。例如,如果网页中存在滚动条,可以使用Selenium模拟滚动操作来加载更多内容;如果网页中存在弹出窗口,可以使用Selenium模拟点击关闭弹窗等操作。

需要注意的是,在使用Selenium进行动态网页爬取时,需要遵守网站的规定,避免进行恶意爬取、盗取数据等行为,同时也需要注意爬虫的请求量、稳定性和可靠性,避免对网站服务器造成负担和影响。

五、Selenium的优缺点

使用Selenium进行动态网页爬取具有以下优缺点:

优点:

-

支持多种浏览器和操作系统,可以适应不同的爬取需求和环境。

-

提供了丰富的API接口,可以模拟用户的各种操作,包括点击、输入、选择等,可以获取网页中的动态内容。

-

可以使用Python等多种语言编写爬虫程序,并可以与其他爬虫框架结合使用。

-

可以进行调试和测试,可以验证爬虫程序的正确性和稳定性。

缺点:

-

需要安装和配置浏览器驱动程序,增加了一定的学习和使用成本。

-

爬取速度较慢,与直接爬取静态网页相比,需要进行更多的操作和等待。

-

受限于网站的限制和反爬机制,可能存在被封禁IP等风险。

-

对硬件资源的消耗较大,需要较高配置的计算机和网络环境。

六、总结文章来源:https://www.toymoban.com/news/detail-466598.html

Selenium是一种用于自动化测试Web应用程序的工具,可以用于爬取动态网页。使用Selenium进行动态网页爬取需要安装和配置Python环境、Selenium库和浏览器驱动程序,并编写相应的爬虫程序。在使用时需要遵守网站的规定,避免进行恶意爬取、盗取数据等行为,同时也需要注意爬虫的请求量、稳定性和可靠性,避免对网站服务器造成负担和影响。Selenium具有多种优点和缺点,需要根据具体的爬取需求和环境进行选择和使用。

PhantomJS工具介绍

一、前言

在网络爬虫中,有一类网页被称为动态网页,即网页中的内容是通过JavaScript等脚本动态生成的,而不是静态的HTML页面。对于动态网页的爬取,传统的爬虫工具如urllib、requests等不能满足需求,需要使用一些特殊的工具来模拟浏览器行为,获取动态生成的内容。本文将介绍一种常用的动态网页爬取工具——PhantomJS,并详细介绍其安装、使用和优缺点。

二、什么是PhantomJS

PhantomJS是一个基于WebKit的无界面的浏览器,可以将网页加载并渲染成图片或PDF等格式,支持JavaScript、DOM操作、CSS选择器等Web标准特性,可以模拟浏览器行为,用于测试Web应用程序和动态网页爬取等场景。PhantomJS使用C++编写,支持多种操作系统和编程语言,包括Python、Java、JavaScript等。

三、PhantomJS的安装和配置

PhantomJS的安装和配置相对简单,可以在官网(https://phantomjs.org/download.html)下载对应操作系统的二进制文件,解压后即可使用。此外,还需要安装Python的selenium库,用于控制PhantomJS进行动态网页爬取。以下是在Windows操作系统上安装和配置PhantomJS和selenium库的步骤:

- 下载PhantomJS

在官网(https://phantomjs.org/download.html)下载Windows版本的PhantomJS二进制文件,解压到本地目录。

- 安装selenium库

打开命令行窗口,使用pip安装selenium库:

pip install selenium

- 配置PhantomJS路径

将PhantomJS安装目录添加到系统环境变量中,或在Python代码中指定PhantomJS的路径。以下是在Python代码中指定PhantomJS路径的方法:

from selenium import webdriver

# 指定PhantomJS路径

driver_path = 'C:\\phantomjs-2.1.1-windows\\bin\\phantomjs.exe'

# 创建PhantomJS浏览器对象

driver = webdriver.PhantomJS(executable_path=driver_path)

# 使用PhantomJS打开网页

driver.get('https://www.baidu.com')

# 获取网页标题

print(driver.title)

# 关闭浏览器

driver.quit()

四、PhantomJS的使用

PhantomJS的使用与普通浏览器类似,可以打开网页、模拟用户操作、获取网页内容等。以下是使用PhantomJS进行动态网页爬取的例子:

from selenium import webdriver

# 指定PhantomJS路径

driver_path = 'C:\\phantomjs-2.1.1-windows\\bin\\phantomjs.exe'

# 创建PhantomJS浏览器对象

driver = webdriver.PhantomJS(executable_path=driver_path)

# 使用PhantomJS打开网页

driver.get('https://www.baidu.com')

# 在搜索框中输入关键字

element = driver.find_element_by_id('kw')

element.send_keys('Python')

# 点击搜索按钮

button = driver.find_element_by_id('su')

button.click()

# 等待搜索结果加载完成

result = None

while result is None:

try:

# 查找搜索结果

element = driver.find_element_by_id('content_left')

result = element.text

except:

# 等待一段时间后重试

time.sleep(1)

# 获取搜索结果

print(result)

# 关闭浏览器

driver.quit()

以上代码使用PhantomJS打开了一个网页,并在网页中输入了搜索关键字,点击搜索按钮后等待搜索结果加载完成,并获取了搜索结果的文本内容。

在实际使用中,需要根据网页的具体情况进行操作。例如,如果网页中存在滚动条,可以使用PhantomJS模拟滚动操作来加载更多内容;如果网页中存在验证码等验证机制,可以使用PhantomJS模拟人工操作来通过验证等。

五、PhantomJS的优缺点

PhantomJS作为一种动态网页爬取工具,具有以下优缺点:

优点:

-

模拟浏览器行为,可以获取动态生成的内容。

-

支持多种Web标准特性,包括JavaScript、DOM操作、CSS选择器等。

-

可以将网页渲染成图片或PDF等格式,方便保存和分析。

-

支持多种操作系统和编程语言,具有较好的兼容性和可扩展性。

缺点:

-

运行速度较慢,相比于传统的爬虫工具,PhantomJS需要加载和渲染网页,耗时较长。

-

资源占用较高,PhantomJS需要占用较多的内存和CPU资源,对服务器性能有一定影响。

-

不支持JavaScript异步请求,如果网页中存在异步请求,需要进行额外的处理。

-

不支持JavaScript代码压缩,如果网页中的JavaScript代码经过压缩处理,需要进行额外的处理。

六、总结

PhantomJS作为一种常用的动态网页爬取工具,可以模拟浏览器行为,获取动态生成的内容。PhantomJS具有较好的兼容性和可扩展性,可以支持多种操作系统和编程语言,但也存在一些缺点,如运行速度较慢、资源占用较高等。在使用PhantomJS进行动态网页爬取时,需要根据具体的网页情况进行操作,避免出现问题。文章来源地址https://www.toymoban.com/news/detail-466598.html

到了这里,关于Python动态网页爬取的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[爬虫篇]Python爬虫之爬取网页音频_爬虫怎么下载已经找到的声频](https://imgs.yssmx.com/Uploads/2024/04/855397-1.png)