-

理论依据

【基本思想】

1.多元线性回归分析的基本原理

多元线性回归模型是指含有多个自变量的线性回归模型,用于解释因变量与其他多个自变量之间的线性关系。多元线性回归模型数学表达式为:

式中,因变量y的变化可由两个部分解释:一是由k个自变量x的变化引起的y的变化部分;二是由其他随机因素引起的y的变化部分。

2.回归系数的检验

多元线性回归分析中,回归系数显著性检验的原假设为

,即第i个偏回归系数与0无显著差异。

3.回归方程的检验

多元线性回归方程显著性检验的原假设为

,式中,k为解释变量的个数,n为样本数。SPSS自动将F值与概率P值相对应,如果P值小于给定的显著性水平α,则拒绝原假设。

4.多元线性回归分析的基本步骤

(1)确定因变量与自变量,并初步设定多元线性回归方程。

(2)估计参数,确定估计多元线性回归方程。

(3)利用检验统计量对回归预测模型进行各项显著性检验。

(4)检验通过后,可利用回归模型进行预测,分析评价预测值。

【实验目的】

1.准确理解多元线性回归分析的方法原理。

2.熟练掌握多元线性回归分析的SPSS操作。

3.掌握样本回归系数和回归方程显著性检验的方法。

4.掌握如何利用回归方程进行预测。

5.培养运用多元线性回归分析方法解决身边实际问题的能力。

-

实验内容

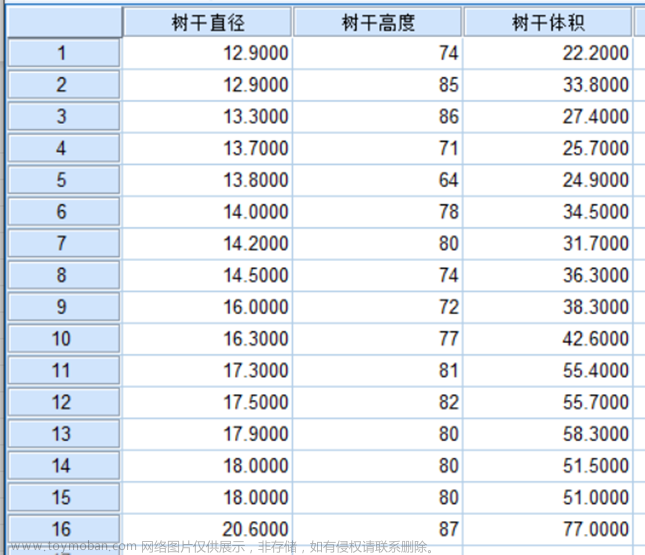

大家都知道,软饮料需求受价格、人均收入和季节的影响。因此,可以用经验数据(时间序列数据或截面数据)建立回归方程对需求进行估计,从而针对不同的收入人群、在不同的季节制定不同的生产和销售计划。数据集“data15-1. sav”列出的是美国48个邻近州的截面数据。

此数据集包含州(z)、罐/(人·年)(Y)、6罐装饮料价格(P)、收入/人(I)、平均气温(T)5个变量的48条观测。罐/(人·年)(Y)是每年每人的软饮料需求量,6罐装饮料价格(P)是6罐装饮料的价格,收入/人(I)是人均年收入,平均气温(T)是平均气温,这4个变量均为数值型变量。

下面以每年每人的软饮料需求量为因变量,以6罐装饮料的价格、人均收入、平均气温为自变量建立多元线性回归模型,来研究三种影响因素对因变量的影响程度,计算软饮料需求的价格弹性,估计解释变量发生变化时,软饮料需求的变动。

-

操作步骤

(1)确定因变量与自变量,初步设定回归方程

以每年每人的软饮料需求量为因变量Y,以6罐装饮料的价格P、人均收入I、平均气温T为自变量建立多元线性回归模型:

(2)估计参数,建立回归预测模型

1)打开数据集“data15-1. sav”,选择菜单:【Analyze】→【Regression】→【Linear】。

图7-1:选择菜单步骤

2)弹出如图7-2所示的对话框,在此对话框中选择罐/(人·年)[Y]进入“Dependent”框内;选择6罐装饮料价格[P]、收入/人[I]、平均气温[T]进入“Independent(s)”框内。需要注意的是,可以通过点击“Previous”与“Next”按钮切换,选择不同的自变量构建模型,每个模型中可以对不同的自变量采用不同的方法进行回归。

图7-2:“Linear”对话框

3)在“Method”下拉框中有5个选项,代表着5种回归方法。

①“Enter”选项是强行进入法,即所选变量全部进入回归模型,该选项是默认方法。

②“Remove”选项是消去法,建立回归方程时根据设定的条件剔除部分自变量。

③“Forward”选项是向前选择法,从模型中无自变量开始,然后依据在“Options”对话框中所设定的内容,每次将一个最符合条件的变量引入模型,直至所有符合判断依据的变量都进入模型为止。第一次进入回归模型的变量应该是与因变量的相关系数绝对值最大的变量。如果指定的判断依据是F值,每次将方差分析的F值最大的变量引入模型。

④“Backward”选项是向后剔除法,先建立全模型,然后根据在“Options”对话框中所设定的判断依据,每次剔除一个最不符合进入模型判断依据的变量,直到回归方程中不再含有不符合判断依据的自变量为止。

⑤“Stepwise”选项是逐步回归法,它是向前选择法与向后剔除法的结合。根据在“Options”对话框中所设定的判据,选择符合条件且对因变量贡献最大的自变量进入回归方程。然后根据向后剔除法,将模型中F值最小且符合剔除判据的变量剔除出模型,重复进行,直到回归方程中的自变量均符合进入模型的依据,模型外的变量均不符合进入模型判据为止。

这几种回归方法均可选择,最后所得出的有效回归方程表达式应当是相同的。本实验中选择“Stepwise”选项(如图7-2所示)。

点击“Statistics”按钮,弹出如图7-3所示的对话框,输出各种常用判别统计量。

图7-3:“Statistics”对话框

①在“Regression Coefficients”框中,选择“Estimates”,输出回归系数、回归系数的标准差、对回归系数检验的t统计量及P值。

②选择“Confidence intervals”,输出每个非标准化回归系数的95%的置信区间。

③选择“Covariance matrix”,输出非标准化回归系数的协方差矩阵、各变量的相关系数矩阵。

④选择“Model fit”,输出各种默认值:判定系数、调整的判定系数、回归方程的标准误差、回归方程显著的F检验的方差分析表。

⑤选择“R squared change”复选项,输出当回归方程中引入或剔除一个变量后R²的变化,如果该变化较大,说明进入和从方程中剔除的可能是一个较好的回归自变量。

⑥选择“Descriptives”选项输出的是合法观测量的数量、变量的平均值、标准差、相关系数矩阵及单侧检验显著性水平矩阵。

⑦选择“Part and partial correlations”选项,输出部分相关系数、偏相关系数与零阶相关系数。

⑧选择“Collinearity diagnostics”选项,输出用来诊断自变量共线性的各种统计量,如容忍度、方差膨胀因子、特征值、条件指标、方差比例等。其中,容忍度Tolerance越接近于0,表示复共线性越强,越接近于1,复共线性越弱。方差膨胀因子VIF的值越接近于1,解释变量之间的多重共线性越弱,如果VIF值大于或等于10,说明一个解释变量与其他解释变量之间有严重的多重共线性。

⑨在“Residuals”框中,选择“Durbin-Watson”选项,判断相邻残差序列的相关性(截面数据一般不存在序列相关性)。

⑩选择“Casewise diagnostics”选项,要求进行样本奇异值判断,并在“Outliersoutside”的参数框中键入3,设置观测标准差大于等于3的奇异值。

5)点击“Continue”,返回主对话框。

6)在主对话框中点击“Plots”按钮,弹出如图7-4的对话框,该对话框主要通过图形进行残差序列分析。

图7-4:“Plots”对话框

①选取“ZRESID”为Y轴,“ZPRED”为X轴绘制图形,研究观测变量的分布规律、异常值,点击“Next”可以选择其他组合进行观测。

②在“Standardized Residual Plots”框中选择“Histogram”,输出带有正态曲线的标准化残差的直方图。

③选择“Normal probability plot”输出标准化残差图,观测残差波动幅度。

7)点击“Continue”返回主对话框。

8)在主对话框中点击“Save”按钮,弹出如图7-5所示的对话框,该对话框的操作主要是保存一些统计量值。

图7-5:“Save”对话框

①在“Predicted Values”框中选择“Unstandardized”,输出由方程计算出的因变量的非标准化预测值。

②在“Distances”框中,选择“Mahalanobis”,计算马氏距离;选择“Cook's”,计算Cook距离;选择“Leverage values”,计算中心化杠杆值。由这些距离的计算找到强影响点和高杠杆点。

③在“Prediction Intervals”框下选择输出预测区间。选择“Individual”项,将输出个别值预测区间。

④在“Residuals”框中,选择“Unstandardized”项,输出非标准化残差。

⑤通过“Influence Statistics”框中的选项,输出强影响点的统计量,选择“DfBeta(s)”观测因排除一个特定的观测值所引起的回归系数的变化值。一般情况下,如果此值大于临界值2/n,则认为被排除的观测值有可能是影响点。

⑥选择“Save to New File”,将回归系数保存在一个指定的文件中。

⑦选择“Export model information to XML file”,可将模型的信息输出到指定的文件夹中。

9)点击“Continue”按钮,返回主对话框。

10)在主对话框中点击“Options”按钮,弹出如图7-6所示的对话框。

图7-6:“Statistics”对话框

①在“Stepping Method Criteria”框中,选择“Use probability of F”项,采用F检验的概率值作为依据。系统默认的Entry值为0.05, Removal值为0.10。当一个变量的Sig值≤Entry值时,该变量被引入方程,当一个变量的Sig值≥Removal值时,该变量从方程中剔除。

②选择“Include constant in equation”选项,在回归方程中加入常数项。

③在“Missing Values”框中,选择“Exclude cases listwise”项,排除缺失值。

11)点击【Continue】→【OK】,系统输出全部结果。

-

结果分析

从描述统计表中可以看出,模型因变量饮料需求量和自变量收入、平均气温的平均值、方差、个案数。

表7-1:描述统计表

Descriptive Statistics | |||

Mean |

Std. Deviation |

N |

|

罐/(人/年) |

158.21 |

67.367 |

48 |

收入/人 |

16.144 |

3.7748 |

48 |

平均气温 |

53.60 |

9.243 |

48 |

从模型变量相关系数表中可以看出,饮料需求量、收入、平均气温之间的相关系数及检验值,其中各变量之间的相关系数显著性P值均小于0.05,因此相关关系显著。其中,自变量收入与因变量饮料需求量呈负相关,相关系数为-0.334;自变量平均气温与因变量饮料需求量呈正相关,相关系数为0.685。

表7-2:模型变量相关系数表

Correlations | ||||

罐/(人/年) |

收入/人 |

平均气温 |

||

Pearson Correlation |

罐/(人/年) |

1.000 |

-.334 |

.685 |

收入/人 |

-.334 |

1.000 |

-.321 |

|

平均气温 |

.685 |

-.321 |

1.000 |

|

Sig. (1-tailed) |

罐/(人/年) |

. |

.010 |

.000 |

收入/人 |

.010 |

. |

.013 |

|

平均气温 |

.000 |

.013 |

. |

|

N |

罐/(人/年) |

48 |

48 |

48 |

收入/人 |

48 |

48 |

48 |

|

平均气温 |

48 |

48 |

48 |

|

从回归方法输入变量表中可以看出,模型采用逐步回归法(Stepwise),剔除变量收入I,保留变量平均气温T。

表7-3:回归方法输入变量

Variables Entered/Removeda | |||

Model |

Variables Entered |

Variables Removed |

Method |

1 |

平均气温 |

. |

Stepwise (Criteria: Probability-of-F-to-enter <= .050, Probability-of-F-to-remove >= .100). |

a. Dependent Variable: 罐/(人/年) | |||

从模型摘要表7-4中可以看出,模型的复相关系数R、R2、调整的R2,调整后模型解释度为45.8%,解释变量与被解释变量之间线性关系明显。F检验统计量为40.709,显著性P值为0.000 < 0.05,因此通过F检验,即认为线性回归整体显著。其中DW统计量为2.118,其中当k=2(包括截距),n>=45时,dl=1.43,du=1.615。又因为DW大于等于du,小于等于4-du。因此可以认为随机扰动项不存在序列相关问题。

表7-4:模型摘要

Model Summaryb | ||||||||||

Model |

R |

R Square |

Adjusted R Square |

Std. Error of the Estimate |

Change Statistics |

Durbin-Watson |

||||

R Square Change |

F Change |

df1 |

df2 |

Sig. F Change |

||||||

1 |

.685a |

.469 |

.458 |

49.598 |

.469 |

40.709 |

1 |

46 |

.000 |

2.118 |

a. Predictors: (Constant), 平均气温 | ||||||||||

b. Dependent Variable: 罐/(人/年) | ||||||||||

线性回归分析不应只关注R方和线性回归方程,要重视数据检验。首先是ANOVA表,通过ANOVA表中的F检验,我们可以了解线性回归分析是否具有统计学意义。下表为回归变量的方差分析,其中F检验的P值为0.000 < 0.05,表明线性关系整体显著,即通过F检验,可以认为回归整体线性显著,具有统计学意义。

表7-5:回归模型方差分析表

ANOVAa | ||||||

Model |

Sum of Squares |

df |

Mean Square |

F |

Sig. |

|

1 |

Regression |

100142.753 |

1 |

100142.753 |

40.709 |

.000b |

Residual |

113159.164 |

46 |

2459.982 |

|||

Total |

213301.917 |

47 |

||||

a. Dependent Variable: 罐/(人/年) | ||||||

b. Predictors: (Constant), 平均气温 | ||||||

从表7-6中可以得到非标准化的回归系数、标准化的回归系数、t检验、显著性、置信区间、相关性等。其中平均气温的t检验显著性为0.000 < 0.05,说明回归系数显著,通过t检验,其中平均气温的95%的置信区间给出了自变量为(3.418,6.569)的范围。同时自变量与因变量相关系数为0.685 > 0,说明两者呈显著正相关。从多重共线性检验的角度看,模型容忍度为1.000 > 0.1,其倒数为1.000 < 10,因此模型不存在多重共线性问题。

最终,得到模型表达式为:

表7-6:回归系数及t检验表

Coefficientsa | |||||||||||||

Model |

Unstandardized Coefficients |

Standardized Coefficients |

t |

Sig. |

95.0% Confidence Interval for B |

Correlations |

Collinearity Statistics |

||||||

B |

Std. Error |

Beta |

Lower Bound |

Upper Bound |

Zero-order |

Partial |

Part |

Tolerance |

VIF |

||||

1 |

(Constant) |

-109.486 |

42.563 |

-2.572 |

.013 |

-195.160 |

-23.812 |

||||||

平均气温 |

4.994 |

.783 |

.685 |

6.380 |

.000 |

3.418 |

6.569 |

.685 |

.685 |

.685 |

1.000 |

1.000 |

|

a. Dependent Variable: 罐/(人/年) | |||||||||||||

从表中可以得到未选入模型的变量I的标准化的回归系数、t检验、显著性、相关性、多重共线性检验等统计量。其中收入与饮料需求呈负相关,但收入的t检验显著性为0.264 > 0.05,说明回归系数不显著,未通过t检验。因此不引入变量收入。

表7-7:未选入变量的回归系数及t检验表

Excluded Variablesa | ||||||||

Model |

Beta In |

t |

Sig. |

Partial Correlation |

Collinearity Statistics |

|||

Tolerance |

VIF |

Minimum Tolerance |

||||||

1 |

收入/人 |

-.128b |

-1.132 |

.264 |

-.166 |

.897 |

1.115 |

.897 |

a. Dependent Variable: 罐/(人/年) | ||||||||

b. Predictors in the Model: (Constant), 平均气温 | ||||||||

从下表7-8中可以得到诊断回归模型的共线性诊断表,从表中可以知道方差比例和条件指数。从方差比例来看,某个特征值能够解释的方差比例不全都超过50%,因此不存在多重共线性现象。从条件指数来看,模型解释变量对应的条件指数都不是很大(均在12以下),这也印证了模型不存在多重共线性现象。

表7-8:共线性诊断表

Collinearity Diagnosticsa | |||||

Model |

Dimension |

Eigenvalue |

Condition Index |

Variance Proportions |

|

(Constant) |

平均气温 |

||||

1 |

1 |

1.986 |

1.000 |

.01 |

.01 |

2 |

.014 |

11.806 |

.99 |

.99 |

|

a. Dependent Variable: 罐/(人/年) | |||||

从下表7-9中可以得到回归模型的残差统计表,从表中可以知道预测因变量、预测标准差、预测值的标准误差、调整的预测值等统计量的最大值、最小值、平均值、方差、个案数。

表7-9:残差统计表

Residuals Statisticsa | |||||

Minimum |

Maximum |

Mean |

Std. Deviation |

N |

|

Predicted Value |

65.30 |

300.01 |

158.21 |

46.159 |

48 |

Std. Predicted Value |

-2.013 |

3.072 |

.000 |

1.000 |

48 |

Standard Error of Predicted Value |

7.166 |

23.350 |

9.636 |

3.138 |

48 |

Adjusted Predicted Value |

51.91 |

333.05 |

158.59 |

48.659 |

48 |

Residual |

-116.015 |

144.845 |

.000 |

49.068 |

48 |

Std. Residual |

-2.339 |

2.920 |

.000 |

.989 |

48 |

Stud. Residual |

-2.651 |

2.962 |

-.004 |

1.024 |

48 |

Deleted Residual |

-149.050 |

149.031 |

-.382 |

52.740 |

48 |

Stud. Deleted Residual |

-2.849 |

3.257 |

.004 |

1.064 |

48 |

Mahal. Distance |

.002 |

9.438 |

.979 |

1.603 |

48 |

Cook's Distance |

.000 |

1.001 |

.040 |

.151 |

48 |

Centered Leverage Value |

.000 |

.201 |

.021 |

.034 |

48 |

a. Dependent Variable: 罐/(人/年) | |||||

下图为回归标准化残差直方图,横轴表示与回归相联系的标准化残差,纵轴表示残差的评率,并且右上可以看到标准差和平均值。本题数据符合正态分布假设。

图7-7:回归标准化残差直方图

下图为残差P-P图,横轴是实测累计概率,纵轴表示预期累计概率。由图可见所有散点均匀分布在正方形斜对角附近,表明模型满足随机扰动项服从正态分布这一假设。

图7-8:残差P-P图

下图为残差散点图,本例中反映了饮料需求作为因变量其散点图的标准化残差。以纵轴0点为对称轴,各散点平均分布在其附近,没有明显的偏正或偏负,也没有表现出明显的规律性,因此可以认为随机扰动项不存在序列相关和异方差问题。文章来源:https://www.toymoban.com/news/detail-468335.html

图7-9:残差散点图文章来源地址https://www.toymoban.com/news/detail-468335.html

到了这里,关于多元线性回归分析的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!