【论文介绍】

EnlightenGan是第一个成功地将非配对训练引入微光图像增强的工作。

【题目】:EnlightenGAN: Deep Light Enhancement Without Paired Supervision

【DOI】:10.1109/TIP.2021.3051462

【时间】:2019-06-17上传于arxiv

【会议】:2019 IEEE Transactions on Image Processing(TIP)

【机构】:美国-得克萨斯大学(University of Texas System)

【论文链接】:https://arxiv.org/abs/1906.06972

【代码链接】:https://github.com/VITA-Group/EnlightenGAN【提出问题】

基于深度学习的方法在图像恢复和增强方面取得了显著的成功,但是在缺乏配对训练数据的情况下它们仍然具有竞争力吗?

【解决方案】

使用从输入本身提取的信息来规范非配对训练,而不是使用ground truth数据监督学习,提出了一个高效的无监督生成对抗网络,称为 EnlightenGAN,可以在没有低光/正常光图像对的情况下进行训练,可用于增强来自不同领域的真实世界低光图像。

【创新点】

- 无监督:EnlightenGan是第一个成功地将非配对训练引入微光图像增强的工作。

- 全局-局部鉴别器:除了全局改善光照之外,自适应地增强局部区域。

- 自正则化的思想:由自特征保持损失和自正则化注意力机制共同实现。

【EnlightenGAN网络构架】

- 采用自调整注意力引导的 U-Net 作为生成器。

- 使用双判别器来引导全局和局部信息。

- 使用自特征保留损失来指导训练过程并保持纹理和结构。

- 利用低光输入的照度信息作为深度特征每一层的自规则化注意图来规范无监督学习。

1、自调整注意力引导的U-Net生成器

- 取输入RGB图像的照明通道 I,将其归一化为[0,1],然后使用1-I(元素差异)作为自正则化 attention map。

- 然后,resize attention map 的大小以适应每个 feature map,并将其与所有中间 feature map 以及输出图像相乘。

- 每个卷积块有两个3×3卷积层,然后是 BN 和 Leakyrelu。

- 在上采样阶段,用一个双线性上采样层和一个卷积层代替标准的反卷积层,以减轻伪影。

U-Net通过提取不同深度层的多层次特征,保留了丰富的纹理信息,并利用多尺度上下文信息合成高质量的图像。

【论文笔记】—图像分割—U-Net—2015-MICCAI_chaikeya的博客-CSDN博客

2、全局-局部判别器

动机:采用对抗性损失来最小化真实和输出正常光分布之间的距离。

问题:图像级普通鉴别器在空间变化的光图像上经常失败。如果输入图像有一些局部区域需要与其他部分不同地增强,例如,整体黑暗背景中的小亮区域,单独的全局图像鉴别器通常无法提供所需的自适应性。

解决方案:受先前工作 [37] 的启发,除了全局改善光照之外,为了自适应地增强局部区域,提出了一种新颖的全局-局部鉴别器结构,两者都使用 PatchGAN 进行真假鉴别。

局部判别器:从输出和真实正常光图像中随机裁剪局部块,并学习区分它们是真实的(来自真实图像)还是假的(来自增强的输出)

全局鉴别器:利用最近提出的相对论鉴别器结构[38],它估计真实数据比假数据更真实的概率,并指导生成器合成比真实图像更真实的假图像。 相对论判别器的标准函数是:

【损失函数】

1、对抗损失

采用对抗性损失来最小化真实和输出正常光分布之间的距离。

其中D表示鉴别器的网络,xr和xf分别从真假分布中采样,σ 表示sigmoid函数。我们稍微修改相对论鉴别器,用最小二乘GAN (LSGAN) [39] 损失代替sigmoid函数。最后,全局鉴别器D和生成器G的损失函数为:

对于局部鉴别器,每次从输出和真实图像中随机裁剪 5 个patch。 这里采用原始的 LSGAN 作为对抗性损失,如下:

2、自特征保留损失

自规范化对我们的模型成功至关重要,因为没有强大的外部监督形式可用的非配对设置。

感知损失:

为了限制感知相似性,Johnson等人[40]通过采用预先训练的VGG来建模图像之间的特征空间距离,提出了感知损失,这被广泛应用于许多低级视觉任务[28],[41]。通常的做法是限制输出图像与其真实图像之间的提取特征距离。

在未配对设置中限制输入低光与其增强的正常光输出之间的 VGG 特征距离。并称其为自特征保留损失,以强调其自正则化效用,在增强前后将图像内容特征保留给自身,自特征保持损失 LSFP 定义为:

其中 I^L 表示输入低光图像,G(I^L) 表示生成器的增强输出。φi,j 表示从在 ImageNet 上预训练的 VGG-16 模型中提取的特征图。i 代表它的第 i 个最大池化,j 代表它在第 i 个最大池化层之后的第 j 个卷积层。Wi,j 和 Hi,j 是提取的特征图的维度。 默认情况下,i = 5,j = 1。

3、总损失

对于局部鉴别器,来自输入和输出图像的裁剪的局部块也通过类似定义的自特征保持损失Llocal SFP来正则化。此外,在输入LSFP和LLocal SFP之前,在VGG特征图之后添加了一个实例归一化层[43],以稳定训练。因此,训练启发的总损失函数写为:

【数据集】

训练集:从 [47], [5] and also HDR sources [15], [25], 中发布的几个数据集中组装了 914 个低光和 1016 个正常光图像的混合图像,无需保留任何一对。手动检查和选择执行以去除中等亮度的图像。所有这些照片都转换为 PNG 格式并调整为 600×400 像素。

[47] Raise数据集 paper ,[5] LOL数据集 paper,[15] HDR sources paper,[25] SICE数据集 paper

低照度图像数据集_chaikeya的博客-CSDN博客

测试集:选择以前工作中使用的那些标准图像(NPE [19], LIME [21], MEF [48], DICM [49], VV, 2 etc.)。

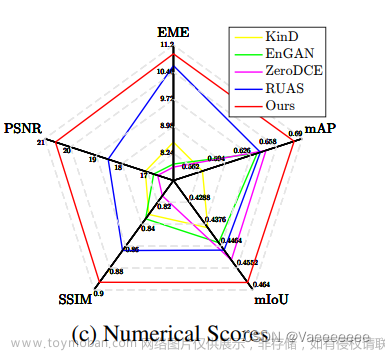

【实验结果】

1、定量分析

表1:在整个测试集(All)和每个子集(MEF、LIME、NPE、VV、DICM)上的 NIQE 得分。 较小的 NIQE 表示较高的整体自然度。

2、定性分析

图1:EnlightenGAN增强效果:从左到右:列1、3和5是低光输入图像;而第2、4、6列及其相应的增强图像。

图3:消融实验

图4:与其他先进方法比较文章来源:https://www.toymoban.com/news/detail-468358.html

文章来源地址https://www.toymoban.com/news/detail-468358.html

文章来源地址https://www.toymoban.com/news/detail-468358.html

到了这里,关于【论文笔记】—低照度图像增强—Unsupervised—EnlightenGAN—2019-TIP的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!