数据采集技术是指通过各种手段和技术手段,从互联网、移动设备、传感器等各种数据源中获取数据,并将其存储、处理和分析,以便为业务决策和应用提供支持。本文将介绍数据采集技术的实现原理,包括数据采集的基本流程、数据采集技术的分类、数据采集技术的实现原理等方面。

一、数据采集的基本流程

数据采集的基本流程包括以下几个步骤:

-

确定数据采集目标:确定需要采集的数据类型、数据源、数据量、数据格式等。

-

确定数据采集方式:根据数据源的不同,选择合适的数据采集方式,如爬虫、API接口、传感器等。

-

数据采集:根据确定的数据采集方式,采集数据并存储到数据库或文件中。

-

数据清洗:对采集到的数据进行清洗、去重、格式化等处理,以保证数据的准确性和一致性。

-

数据存储:将清洗后的数据存储到数据库或文件中,以便后续的数据分析和应用。

-

数据分析:对存储的数据进行分析和挖掘,以发现数据中的规律和趋势,为业务决策提供支持。

二、数据采集技术的分类

数据采集技术可以根据数据源的不同进行分类,主要包括以下几种:

-

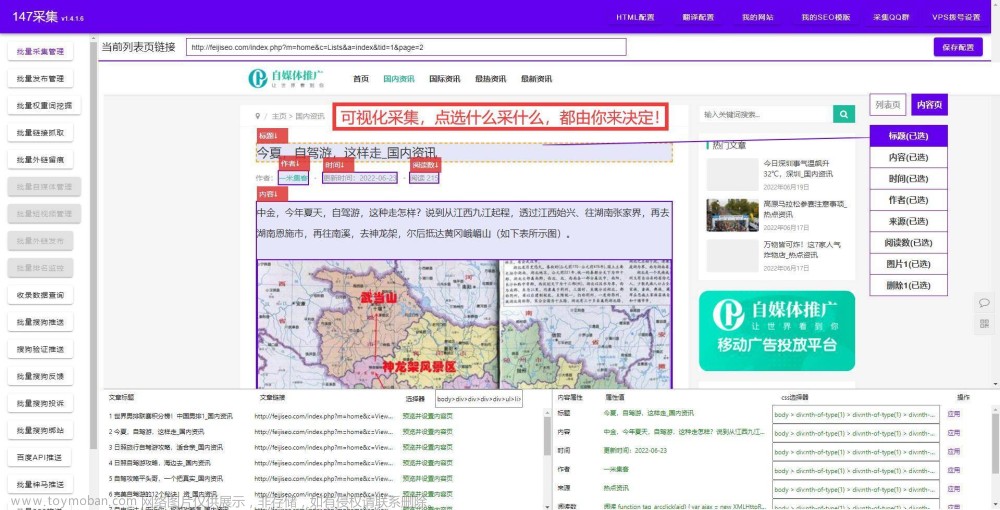

网络爬虫:网络爬虫是一种自动化的数据采集技术,通过模拟人类浏览器的行为,从互联网上抓取数据。网络爬虫可以采集各种类型的数据,如文本、图片、音频、视频等。

-

API接口:API接口是一种标准化的数据交互方式,通过调用API接口,可以获取到指定数据源中的数据。API接口可以提供各种类型的数据,如天气、股票、新闻等。

-

传感器:传感器是一种物理设备,可以感知周围环境的变化,并将感知到的数据转换成电信号输出。传感器可以采集各种类型的数据,如温度、湿度、光强、声音等。

-

数据库:数据库是一种专门用于存储和管理数据的软件系统,可以通过SQL语言进行数据的查询和操作。数据库可以存储各种类型的数据,如文本、图片、音频、视频等。

三、数据采集技术的实现原理

- 网络爬虫的实现原理

网络爬虫的实现原理主要包括以下几个步骤:

(1)确定爬虫的起始URL:爬虫需要从一个起始URL开始,通过该URL获取到页面中的其他URL,以便继续爬取。

(2)获取页面内容:爬虫通过HTTP协议向服务器发送请求,获取页面的HTML代码。

(3)解析HTML代码:爬虫使用解析器对HTML代码进行解析,提取出需要的数据和其他URL。

(4)存储数据:爬虫将提取出的数据存储到数据库或文件中。

(5)继续爬取:爬虫根据提取出的URL,继续爬取其他页面,直到达到预设的停止条件。

- API接口的实现原理

API接口的实现原理主要包括以下几个步骤:

(1)注册API接口:开发者需要注册API接口,并获得API接口的访问密钥。

(2)构造请求:开发者使用API接口提供的文档,构造请求参数和请求头。

(3)发送请求:开发者使用HTTP协议向API接口发送请求,并等待API接口的响应。

(4)解析响应:开发者使用解析器对API接口的响应进行解析,提取出需要的数据。

(5)处理数据:开发者对提取出的数据进行处理,如清洗、格式化等。

(6)存储数据:开发者将处理后的数据存储到数据库或文件中。

- 传感器的实现原理

传感器的实现原理主要包括以下几个步骤:

(1)感知环境:传感器感知周围环境的变化,并将感知到的数据转换成电信号输出。

(2)信号放大:传感器的输出信号很小,需要通过放大器进行放大,以便后续的处理。

(3)信号处理:传感器的输出信号需要进行滤波、放大、数字化等处理,以保证数据的准确性和稳定性。

(4)数据存储:处理后的数据存储到数据库或文件中。

- 数据库的实现原理

数据库的实现原理主要包括以下几个步骤:

(1)建立数据库:管理员需要建立数据库,并定义数据表的结构和字段。

(2)插入数据:用户通过SQL语言向数据库中插入数据。

(3)查询数据:用户通过SQL语言查询数据库中的数据。

(4)更新数据:用户通过SQL语言更新数据库中的数据。文章来源:https://www.toymoban.com/news/detail-469670.html

(5)删除文章来源地址https://www.toymoban.com/news/detail-469670.html

到了这里,关于数据采集技术的实现原理有哪些?的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!