第十一章 Python第三方库纵览

11.1 网络爬虫方向

网络爬虫是自动进行HTTP访问并捕获HTML页面的程序。Python语言提供了多个具备网络爬虫功能的第三方库。这里介绍两个常用的Python网络爬虫库:requests和scrapy。

11.1.1 requests

<requests库是一个简洁且简单的处理HTTP请求的第三方库,其最大优点是程序编写过程更接近正常URL访问过程。这个库建立在Python语言的urllib3库基础上。

requests库支持非常丰富的链接访问功能,包括国际域名和URL获取、HTTP长连接和连接缓存、HTTP会话和cookie保存、浏览器使用风格的SSL验证、基本的摘要认证、有效的键值对cookie记录、自动解压缩、自动内容解码、文件分块上传、HTTP(S)代理功能、连接超时处理、流数据下载等。文章来源:https://www.toymoban.com/news/detail-473466.html

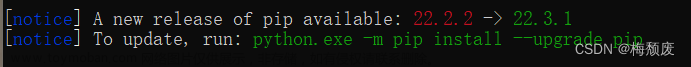

安装requests库方法如下:文章来源地址https://www.toymoban.com/news/detail-473466.html

到了这里,关于第十一章 Python第三方库纵览的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!