目录

第11章 Hadoop 基础

11.1 大数据与Hadoop

11.2 Hadoop框架的主要组件

11.3 用Hadoop分析大数据

表(Table)

元组(Tuple)

11.4 Hadoop分布式文件系统——HDFS

cat

chgrp

chmod

chown

count

cp

du

dus

expunge

get

getmerge

Is

Isr

mkdir

mv

put

rm

rmr

setrep

stat

tail

test

text

touchz

大数据第12章 IBM InfoSphere BigInsights

一、实验内容

二、实验目的

三、实验设备

四、实验步骤

1.下载与安装IBM

步骤一:进入官网

步骤2:注册IBM账号

2.环境配置

3.入门练习

五、实验结果

六、实验小结

第11章 Hadoop 基础

在众多的大数据技术中,Hadoop是一个著名的大数据技术,其主要优点是具有快速处理大数据集的能力。

与传统技术不同,Hadoop不会在内存中复制整个远程数据来执行计算,而是在数据存储处执行任务。

Hadoop减轻了网络与服务期间的通信负荷。

Hadoop还有一个优点,能够在保证分布式环境中的容错性的同时运行程序。为了确保该优点的实施,它通过复制服务器上的数据来防止数据丢失。

IBM InfoSphere BigInsights的基本版包括HDFS、HBase、MapReduce、Hive、Mahout、Oozie、Pig、ZooKeeper、Hue和其他一些开源工具。

本篇将以 IBM InfoSphere BigInsights 为主线,全面介绍 Hadoop 的主要组件。这些组件包括:① 分布式文件系统 HDFS; ② Hadoop 的编程模型 MapReduce: ③ 大数据查询语言JAQL;④大数据仓库 Hive 与 HBase;⑤ MapReduce 编码的更高级别的编程环境 Pig;⑥ Hadoop 与结构化数据存储间传送批量数据的工具 Sgoop;⑦ 旨在收集、汇总与将来自不同源的日志数据移动到中央位置的一种分布式系统 Flume; ⑧ 管理 Hadoop 工作流的工具 Oozie;⑨ 用于管理集群同步的工具 ZooKeeper; @ Hadoop 的机器学习组件 Mahout。

11.1 大数据与Hadoop

Hadoop的核心由HDFS和MapReduce组成。

Hadoop的基本框架:通用模块、HDFS(分布式存储)、YARN框架、MapReduce(分布式计算)。

11.2 Hadoop框架的主要组件

Hadoop框架的主要组件包括:HDFS、MapReduce、Jaql、Hive与Hue、Pig、Sqoop、Flume、Hadoop Streaming、Oozie、HBase、FlumNG、Whirr、Mahout、Fuse、Zookeeper。

11.3 用Hadoop分析大数据

关系数据库模型是主要的数据模型,主要有:表(Table)和元组(Tuple)。

表(Table)

在关系数据模型中,关系以表的格式存储。这个格式存储了实体间的关系。一个表具有行和列,其中行表示记录,列表示属性。

元组(Tuple)

表单的一行,包含关系的单个记录,称为元组。元组与属性的关系

11.4 Hadoop分布式文件系统——HDFS

cat

用法:hadoop fs –cat URI[URI…]

将原路径复制到标准输出

例如:

hadoop fs -cat hdfs:/mydir/test_file1 hdfs:/mydir/test_file2

hadoop fs –cat file:///file3/user/hadoop/file4

chgrp

用法:hadoop fs –chgrp [-R] GROUP URI[URI…]

更改文件的组关联

使用-R,递归的=地通过目录结构进行更改

chmod

用法:hadoop fs –chmod [-R]<MODE[,MODE]…|OCTALMODE>

更改文件权限

使用-R,递归地通过目录结构进行更改

chown

用法:hadoop fs –chown [-R] [OWNER][:[GROUP]]URI[URI]

使用-R,递归地通过目录结构进行更改

copyFromLocal

用法:hadoop fs –copyFromLocal<localsrc>URI:

copyToLocal

用法:hadoop fs –copyToLocal [-ignoreCre] [-crc] URI<localdst>

count

用法:hadoop fs –count[-q]<path>

统计与指定文件模式匹配的路径下的目录、文件和字节数。

输出栏为: DIR_COUNT,FILE_COUNT,COUNT_SIZE FILE_NAME

用-q输出的栏为:

QUOAT,REMAINING_QUATA,SPACE_QUOTA,

REMAINING_SPACE_QUATA,DIR_COUNT,FILE_COUNT,

CONTENT_SIZE,FILE_NAME

例如:

hadoop fs-count hdfs:/mydir/test_file1 hdfs:/mydir/test_file2

hadoop fs –count –q hdfs:/mydir/test_file1

cp

用法:hadoop fs –cp URI[URI…]<dest>

从源文件拷贝到目标文件

该命令允许多个源文件,但目标必须是一个目录

例如:

hadoop fs –cp hdfs:/mydir/test_file file:///home/hdpadmin/foo

hadoop fs –cp file:///home/hdpadmin/foo file:///home/hdpadmin/boo

hdfs:/mydir

du

用法:hadoop fs –du URI[URI…]

显示包含在目录中的文件的合计长度或只有一个文件的文件长度

例如:

Hadoop fs –du file:///home/hdpadmin/test_file hdfs:/mydir

dus

用法:hadoop fs –dus <args>

显示文件的总计长度

expunge

用法:hadoop fs -expunge

清空垃圾

get

用法:hadoop fs –get [-ignoreCre][-crc]<src><localdst>

将文件拷贝到本地文件系统

—CRC校验失败的文件可以用-ignoreCre选项复制。

—可以用-crc选项复制文件和CRC.

例如:

Hadoop fs –get hdfs:/mydir/file file:///home/hdpadmin/loca file

getmerge

用法:hadoop fs -getmerge<src><localdst>[addn1]

将源文件和目标文件作为输出,源文件中的连接文件连接到目标本地文件。

可以设置一个附加选项来在每个文件的末尾添加换行符

Is

用法:hadoop fs -Is<args>

对于文件,使用下面格式返回文件中的统计信息:

—permissions number_of_replicas userid groupid filesize modification_date modification_time filemane

对于目录,它将返回其直接子目录列表,如在UNIX中。目录列表如下:

—permissions userid grougid modification_date modification_time dirname

例:

hadoop fs –Is hdfs:/mydir/test_file

Isr

用法:hadoop fs –Isr<args>

Is的递归版本。与Unix的Is –R相似。

例如:

hadoop fs –Isr hdfs:/mydir

mkdir

用法:hadoop fs –mkdir<paths>

将uri作为路径参数并创建目录。这种行为非常像Unix mkdir –p沿路径创建父目录

例如:

hadoop fs –mkdir hdfs:/mydir/foodir hdfs:/mydir/boodir

mv

用法:hadoop fs –mv URI[URI…]<dest>

将文件从源移动到目标

这个命令允许多个源。在这种情况下,目标必须是一个目录。

跨文件系统移动文件是不允许的。

例如:

hadoop fs –mv file:///home/hdpadmin/test_file file:///home/hdpadmin/test_file1

hadoop fs –mv hdfs:/mydir/file1 hdfs:/mydir/file2 hdfs:/mydir3

put

用法:hadoop fs –put<localsrc>…<dst>

将单源或多源从本地文件系统拷贝到目标文件系统

从stdin中读取输入并写入目标文件系统

注意,它可以是同一个文件系统。

例如:

hadoop fs –put file:///home/hdpadmin/test_file hdfs:/mydir

hadoop fs –put localfile1 localfile2 hdfs:/mydir

hadoop fs –put- hdfs://mydir/input_file1(从stdin中读取输入)

rm

用法:hadoop fs –rm[-skip Trash]URI[URI…]

删除指定参数的文件

仅删除非空目录及文件

例如:

hadoop fs –rm hdfs:/home/hdpadmin/test_file file://home/hdpadmin/test_file

rmr

用法:hadoop fs –rmr[-skipTrash]URI[URI…]

删除的迭代版本

例如:

hadoop fs –rmr file:///home/hdpadmin/mydir

hadoop fs –rmr –skipTrash hdfs:/mydir

setrep

用法:hadoop fs –setrep[-w][ -R]<path>

改变文件的复制因子

例如:

-hadoop fs –setrep –w 5 –R hdfs:/user/hadoop/dir1

stat

用法:hadoop fs –stat URI[URI…]

返回路径上的统计信息

例如:

-hadoop fs –stat hdfs:/mydir/test_file

tail

用法:hadoop fs –tail[-f] URI

将文件的最后1K字节显示到stdout中。-f选项可用于Unix中。

例如:

-hadoop fs –tail hdfs:/mvdir/test file

test

用法:hadoop fs –test-[ezd] URI

-e 查看文件是否存在,如果存在则返回0。

-z 查看文件的长度是否为0,如果为真,则返回0。

-d 查看路径是否是目录,如果是真,则返回0。

例如:

hadoop fs –test –e hdfs:/mydir/test_file

text

用法:hadoop fs –text<src>

将原文和输出文件转换为文本格式

touchz

用法:hadoop fs –touchz URI[URI]

创建长度为0的文件

例如:

hadoop fs –touchz hdfs:/mydir/test_file

大数据第12章 IBM InfoSphere BigInsights

一、实验内容

请独立完成12.3的练习,提交练习结果。(提交练习过程中的实施步骤和相关界面截图)

二、实验目的

IBM InfoSphereBigInsights是一个用于分析与可视化的大数据平台,是在Apache Hadoop开源的分布式计算平台上开发的。

InfoSphereBigInsights可以帮助企业或机构中的应用程序开发人员、数据科学家和管理人员快速构建和部署自定义分析系统,从数据中获取有用的价值。这些数据通常集成到现有的数据库、数据仓库和商业智能基础设施中。通过使用 InfoSphereBigInsights,用户可以从这些数据中提取新的内涵,从而增强对业务的了解。

三、实验设备

PC

四、实验步骤

1.下载与安装IBM

步骤一:进入官网

https://www-01.ibm.com/marketing/iwm/iwm/web/preLogin.do?source=swg-i bmibqse&S_CMP=web_dwchina_rt_swd&S_PKG=ov13483〈=zh_CN

步骤2:注册IBM账号

注册后并登陆,同意协议,进入下一界面。

下载 3.0.0.2 版本镜像,下载完成后在进行解压缩。

打开 Vmware,点击打开虚拟机。进入到解压目录,打开虚拟机配置文件,配置结束后可开启此虚拟机。

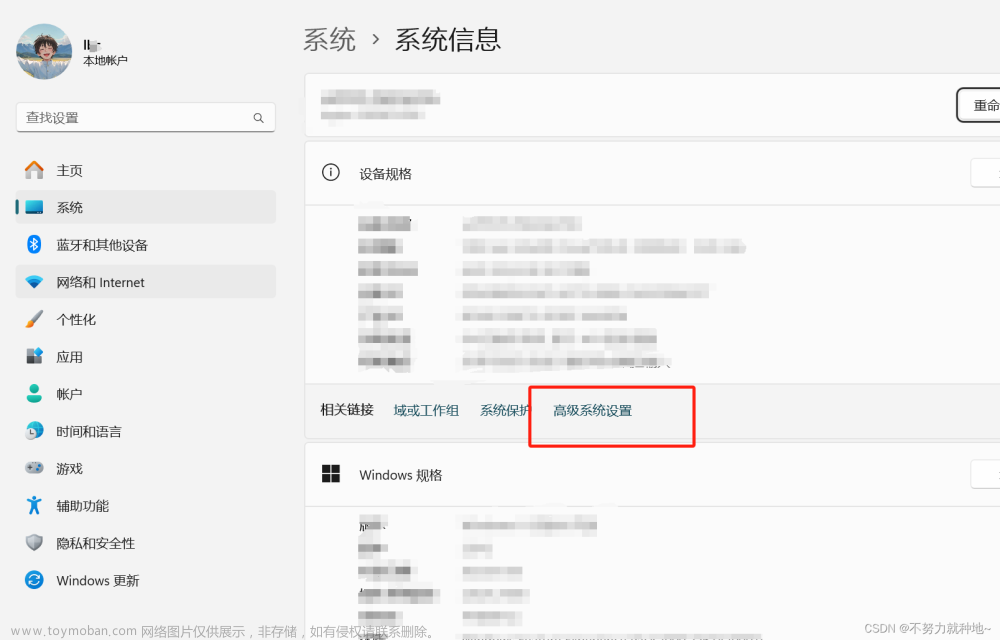

2.环境配置

VMware映像的设置参数如下图所示。

3.入门练习

五、实验结果

文章来源:https://www.toymoban.com/news/detail-476208.html

文章来源:https://www.toymoban.com/news/detail-476208.html

六、实验小结

1. 通过练习,可以更好的管理大数据环境。

2. IBM所提供的加速,对开发和实现大数据分析应用程序提供了良好的解决方案。 文章来源地址https://www.toymoban.com/news/detail-476208.html

到了这里,关于大数据技术⑥|大数据第11章·Hadoop 基础|大数据第12章·IBM InfoSphere BigInsights|大数据技术|20:20~21:20的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!