目录

BiFPN

语义信息

单stage物体检测算法

双stage

skip connection,low-level feature,high level-feature,top-dowm path

backbone通常分为几个stage

efficiendet

完整代码链接+UI界面

BiFPN是双向特征金字塔网络的缩写,是计算机视觉中用于目标检测和分割任务的一种神经网络架构。

传统的特征金字塔网络在提取不同尺度的特征时存在信息丢失和几余的问题,BiFPN则通过引入双向流动的特征信息,有效地解决了这些问题。具体而言,BiFPN通过逐层融合上下采样的特征图,同时引入横向连接和纵向连接,从而使得不同尺度的特征能够更好地融合和利用。

BiFPN的引入在目标检测和分割任务中取得了很好的效果,尤其是在处理尺度变化和遮挡等复杂场景时具有很强的鲁棒性。

语义信息

图像特征越抽象,语义信息越高级。

高语义信息通常指的是对于图像、视频或自然语言等数据中最重要、最有意义的语义信息的提取和利用。这些信息可能包括对象类别、物体实例、场景语义、情感倾向等方面的信息,这些信息可以对于对于计算机视觉和自然语言处理中的各种任务有重要的帮助,如目标检测、语义分割、实例分割、自动问答、机器翻译、情感分析等。

相比于一般的语义信息,高语义信息更加重要和有用,因为它们是在所有语义信息中最具有区分性和代表性的,能够更好地表示输入数据的含义和上下文。因此,在图像处理和自然语言处理中,提取高语义信息一直是一个重要的研究方向,涉及到许多领域,如深度学习、特征提取、网络设计等。

单stage物体检测算法

单阶段 (single-stage) 物体检测算法中,"stage" 通常指的是检测网络的层数或模型的组成部分。与双阶段 (two-stage) 物体检测算法相比,单阶段物体检测算法只有一个阶段,即直接从输入图像中提取特征并输出检测结果,不需要显式地进行候选区域提取(RegionProposal) 和目标分类两个阶段的分步操作。

在单阶段物体检测算法中,一般采用卷积神经网络 (Convolutional Neural Network,CNN)作为主干网络,通过一系列卷积和池化等操作来提取特征,然后通过一些附加的卷积和全连接层等操作,来输出目标的类别和位置信息。常见的单阶段物体检测算法包括 YOLO(You Only Look Once) 、SSD (Single Shot MultiBox Detector) 和 RetinaNet 等.

相对于双阶段物体检测算法,单阶段物体检测算法具有计算效率高、实时性强等优点,因此在实际应用中得到了广泛的应用。

双stage

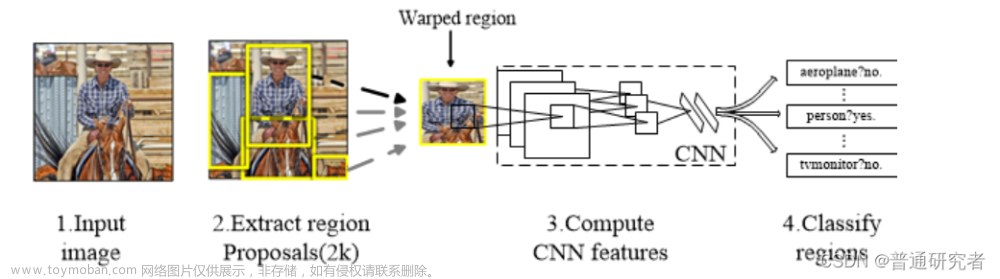

双阶段 (two-stage) 物体检测算法相对于单阶段物体检测算法,分为两个阶段来进行目标检测。

1:第一阶段是候选区域提取 (Region Proposal) ,即通过一些手段,例如 SelectiveSearch 或 RPN (Region Proposal Network) ,生成一系列候选框 (regionproposals)。

2:第二阶段是目标分类和位置回归,即对每个候选框进行目标分类和位置回归得到最终的检测结果。

在第一阶段中,常用的候选区域提取方法包括 Selective Search、EdgeBoxes 和 RPN 等其中 RPN 是一种基于深度学习的方法,可以直接在卷积特征图上生成候选框。在第二阶段中,常用的目标分类和位置回归方法包括 Fast R-CNN、Faster R-CNN 和 Mask R-CNN

与单阶段物体检测算法相比,双阶段物体检测算法的精度通常更高,因为它对目标的位置和大小更加准确地进行了估计。但是由于需要进行两个阶段的操作,双阶段物体检测算法通常需要更多的计算资源和时间,因此在实时性要求高的场景中,可能不太适用。

skip connection,low-level feature,high level-feature,top-dowm path

1. Skip connection: 指跨越了多个网络层次的直接连接。在深度卷积神经网络中,由于信息在网络中不断被压缩和抽象,导致了低级别的特征信息丢失,而skip connection可以通过绕过某些层,直接将原始信息传递到高层网络中,从而保留了低层次的特征信息,提高了网络的性能。

2:Low-level feature: 指图像或视频等输入数据中低层次的特征信息。在图像中,低层次特征包括像素值、颜色和边缘等基础信息,与高层次特征相比,它们更加基础和原始,但同时也更加具有区分度和代表性,可以用于图像的细节和局部信息的提取。

3:High-level feature: 指图像或视频等输入数据中高层次的特征信息。在图像中,高层次特征包括物体类别、场景语义等抽象的语义信息,与低层次特征相比,它们更加抽象和综合,可以用于图像的全局信息的提取和分类。

4:Top-down path: 指从高层次特征到低层次特征的传递路径。在深度卷积神经网络中,由于信息在网络中不断被压缩和抽象,导致了低级别的特征信息丢失,因此需要一种机制来从高层次的特征向低层次的特征进行传递,以便保留低层次的信息。这种传递路径通常是通过上采样和skip connection等方式实现的。

backbone通常分为几个stage

在目标检测任务中,backbone通常是指特征提取网络,例如常用的ResNet、VGG.

EfficientNet等网络结构。这些网络结构由多个卷积层组成,用于提取输入图像的特征。

以ResNet为例,它由多个残差块组成,每个残差块包含多个卷积层和一个跨层连接。通常网络结构中跨度较小的残差块 (例如ResNet50中的前几个残差块) 提取的特征比较”浅”,即特征图尺寸较大,用于检测小物体;跨度较大的残差块 (例如ResNet50中的后几个残差块)提取的特征比较”深”,即特征图尺寸较小,用于检测大物体。因此,将这些残差块分成多个阶段 (即stage),每个阶段包含多个残差块,可以更好地平衡检测不同大小物体的性能.(yolo系列是个很好例子)

具体来说,将backbone分为多个stage的原因是为了根据不同的物体大小和形状,提取不同尺度和层次的特征,以更好地完成目标检测任务。每个stage定义为一个金字塔层级的一部分,因为每个stage中最深的层通常具有最强的特征,而所有层的输出特征尺寸相同,以便进行级联或融合操作,最终得到具有不同尺度和层次的特征。

通常情况下,stage内的layer不包括上采样和下采样,而是只包括卷积操作。skipconnection可能会用于连接不同层级之间的特征图,但并不是每个layer都有skipconnection。上采样和下采样通常是在stage之间或者stage外部进行的。

efficiendet

使用BIFPN实现efficiendet进行目标检测,速率略于v5,但准确率高于v5文章来源:https://www.toymoban.com/news/detail-479342.html

完整代码链接+UI界面

视频,笔记和代码,以及注释都已经上传网盘,放在主页置顶文章文章来源地址https://www.toymoban.com/news/detail-479342.html

到了这里,关于BiFPN,one-stage,two-stage的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!