最小二乘法、极大似然估计和交叉熵是常用的三种损失函数。

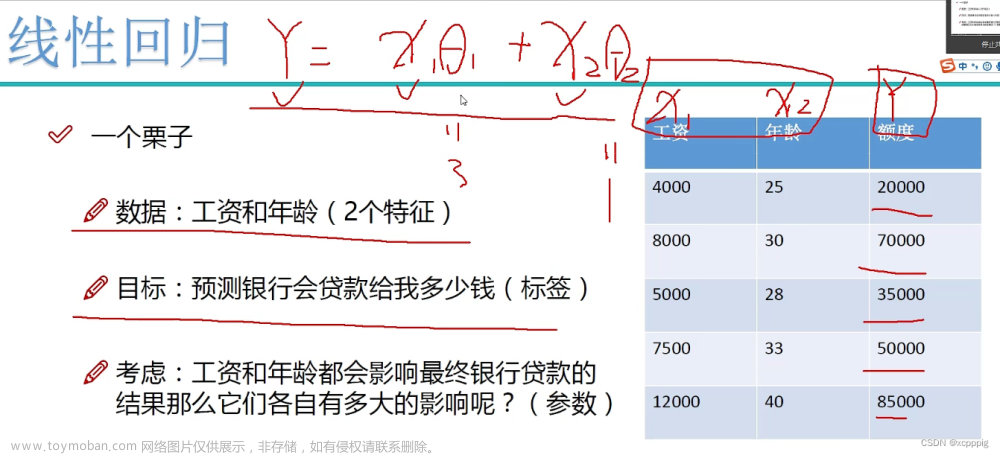

最小二乘法是一种回归问题中常用的损失函数,用于衡量预测值与实际值之间的误差平方和。它常用于线性回归问题中,目标是最小化预测值与真实值之间的均方误差(MSE)。

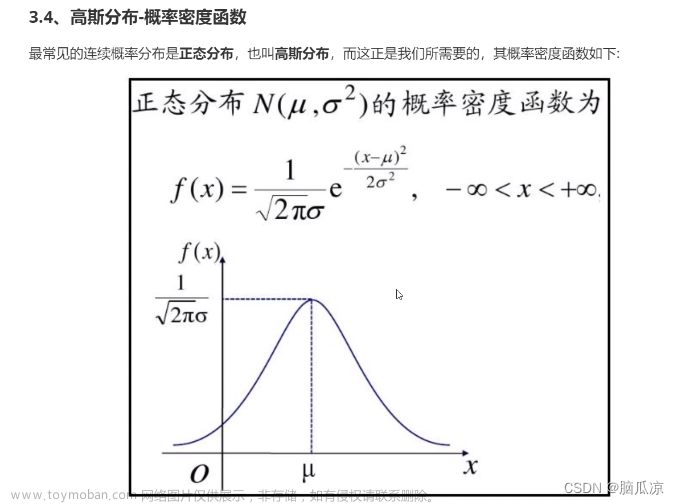

极大似然估计(Maximum Likelihood Estimation,MLE)是一种统计学习中的方法,用于估计模型的参数。在分类问题中,MLE可以被用于估计分类模型的参数。它通过最大化对数似然函数来估计模型参数,从而使得模型预测的概率分布与真实概率分布的差距最小。

交叉熵(Cross Entropy)是一种常用的分类问题中的损失函数,用于衡量模型输出概率分布与真实标签之间的差异。它在深度学习中广泛应用于分类问题中,尤其是在图像识别、自然语言处理等领域。它能够将模型预测的概率分布与真实标签之间的差距最小化文章来源:https://www.toymoban.com/news/detail-482218.html

以上是我本人对于三个公式的推导过程,不喜勿喷。谢谢,如有错误,也希望指正。文章来源地址https://www.toymoban.com/news/detail-482218.html

到了这里,关于最小二乘法,极大似然估计,交叉熵的公式推导的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!