之前由于ChatGpt处处受限,又没法注册的同学们有福了,我们可以在自己电脑上本地化部署一套AI语言模型,且对于电脑配置要求也不是非常高,对它就是RWKV。

关于RWKV

RWKV是一个开源且允许商用的大语言模型,灵活性很高且极具发展潜力,它是一种纯 RNN 的架构,能够进行语言建模,目前最大参数规模已经做到了 14B,该模型训练由Stability赞助。本文发布时RWKV在GitHub上已获得7.8k stars,还在迅速增长中。

RWKV官方仓库:https://github.com/BlinkDL/RWKV-LM

RWKV-Runner

开源仓库地址:https://github.com/josStorer/RWKV-Runner

下载地址(RWKV目录):https://pan.baidu.com/s/1wchIUHgne3gncIiLIeKBEQ?pwd=1111

RWKV-Runner是RWKV的管理和启动工具,由大神 国服第一海豹 制作并开源,它旨在降低大语言模型的使用门槛,做到人人可用,提供了全自动化的依赖和模型管理,你只需要直接点击运行,跟随引导,即可完成本地大语言模型的部署,工具本身体积极小,只需要一个exe即可完成一键部署。

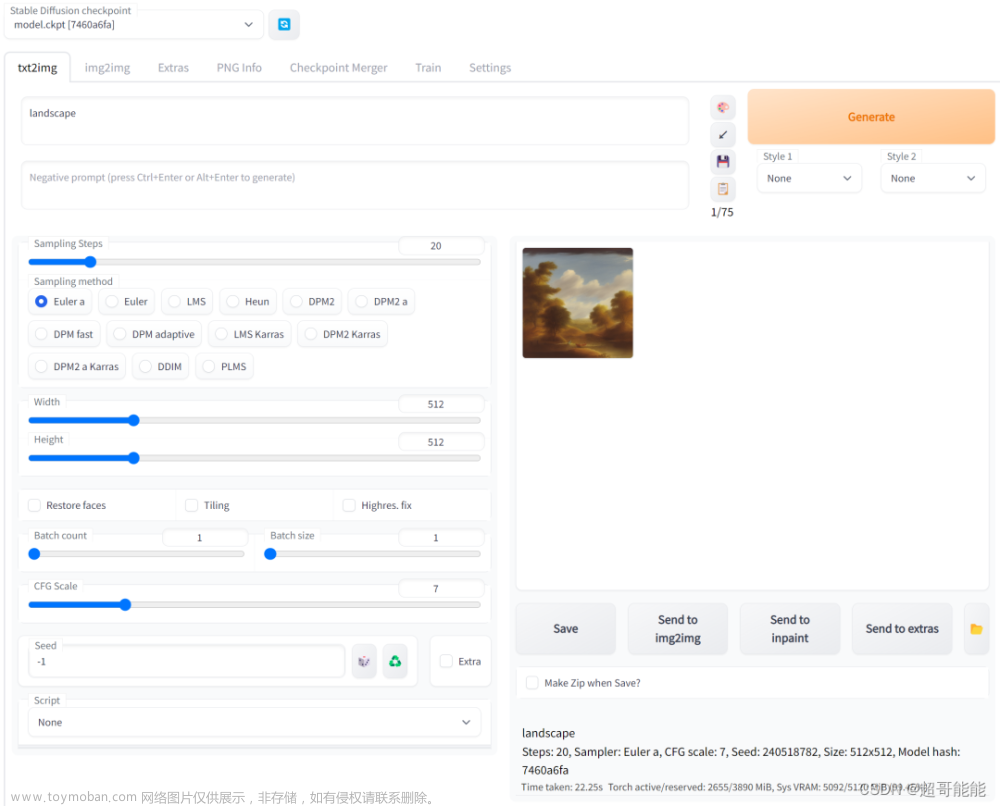

此外,RWKV也提供了与OpenAI API完全兼容的接口,这意味着你可以把任意ChatGPT客户端用作RWKV的客户端,实现能力拓展,而不局限于聊天。

项目介绍

部署RWKV

访问 RWKV开源仓库地址

进入 Release 找到最新版1.1.0

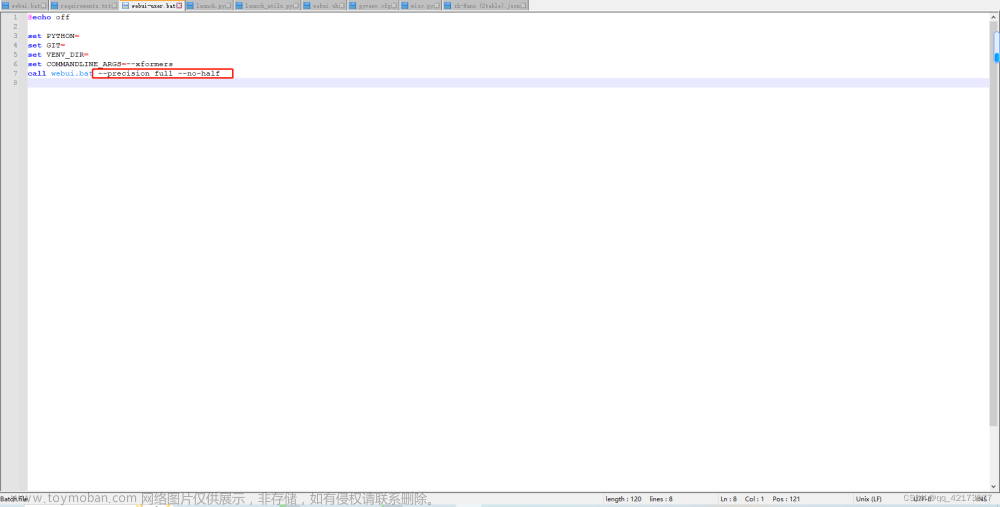

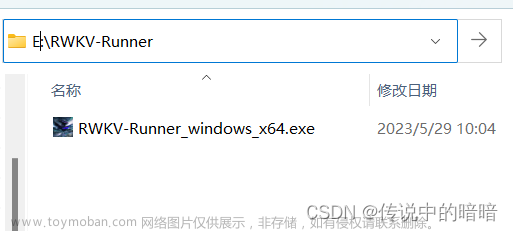

下载 RWKV-Runner_windows_x64.exe 文件

将执行程序存放到单独目录中,此目录将作为系统根目录,执行启动器后所有的依赖将安装至此

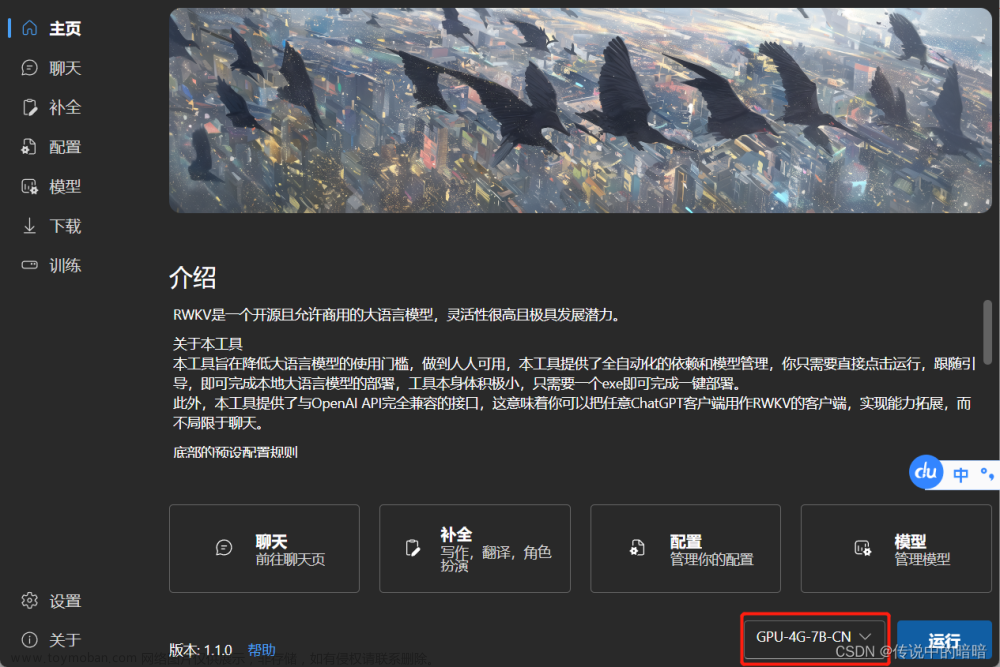

启动程序,根据自己的PC显卡配置选择语言模型,并点击启动

程序启动后自动安装Python、Pytouch等依赖,以及所选择的模型语言库,等所所有需要的内容都下载完毕后就可以开始体验了,部署就是如此简单。

主页

聊天

补全

配置

模型管理

下载管理

设置

聊天实例

启动中文模型,由于我的笔记本电脑配置并不是很高,只能启用 GPU-4G-7B-CN 这个模型,当看到 模型状态:运行中 变绿时就可以开始提问了。

我简单提了两个问题,计算机在收到问题后开始疯狂的运算,文字输出并不快,移动鼠标会感觉到电脑卡顿,在经过几分钟的等待后,RWKV给出了完整的回答。

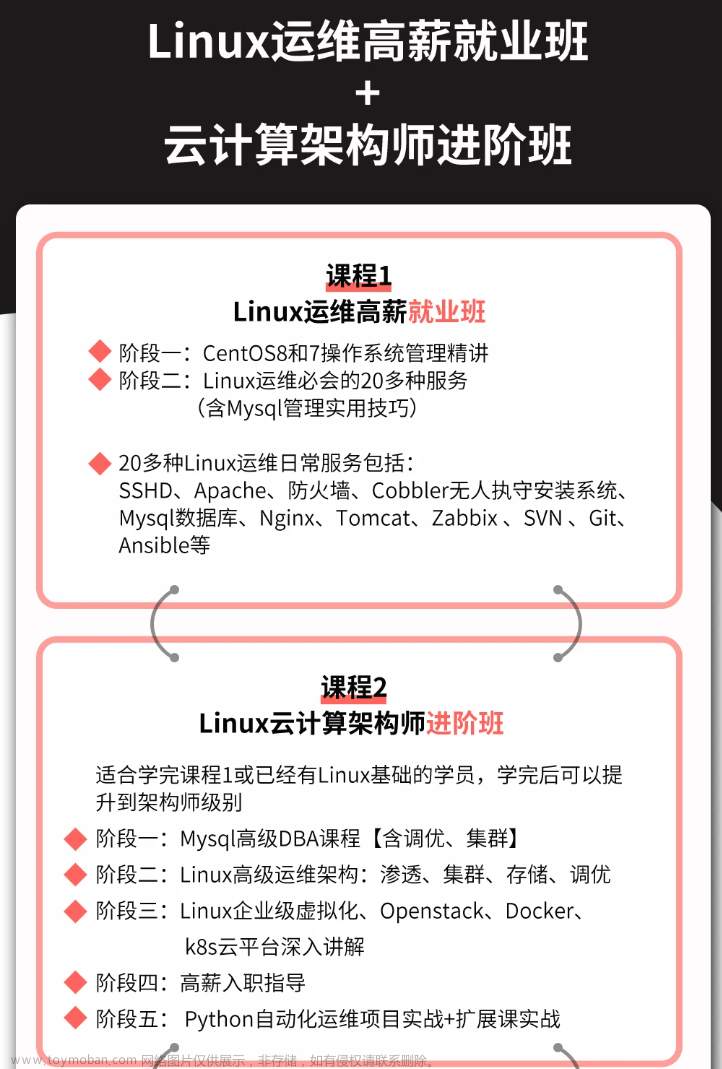

介绍一下 linux

Linux是一种开源的操作系统,它具有高度的可定制性和灵活性。Linux可以在多种硬件上运行,包括服务器、个人电脑、移动设备等。Linux被广泛用于Web服务器、嵌入式系统、桌面应用程序等领域。

如何学习Linux

学习Linux的最佳方法是通过阅读相关的书籍和文档,以及参加在线课程和培训。此外,还可以参加Linux社区的活动和讨论,与其他Linux用户交 学习Linux的最佳方法是通过实践和经验积累。以下是一些学习Linux的建议:

阅读文档和手册:Linux的用户手册和官方文档非常详细,它们可以帮助你了解Linux的基本概念、系统组件和命令行工具。

安装Linux操作系统:在学习Linux之前,你需要先安装一个Linux操作系统。你可以选择使用Ubuntu、Debian或Fedora等流行的发行版。

编写Shell脚本:Shell脚本是用于自动化任务的脚本文件,它们可以帮助你更高效地管理服务器和网络设置。

参加社区活动:参加Linux社区活动可以帮助你与其他开发人员交流并学习新技能。

持续学习: Linux是一个不断发展的领域,因此保持对新技术和趋势的关注非常重要。通过阅读技术博客、参加线上课程或与其他开发人员交流来保持对最新技术的了解。

总之,学习Linux需要耐心和时间,但通过不断实践和探索,你将获得更深入的了解和更广泛的应用场景。

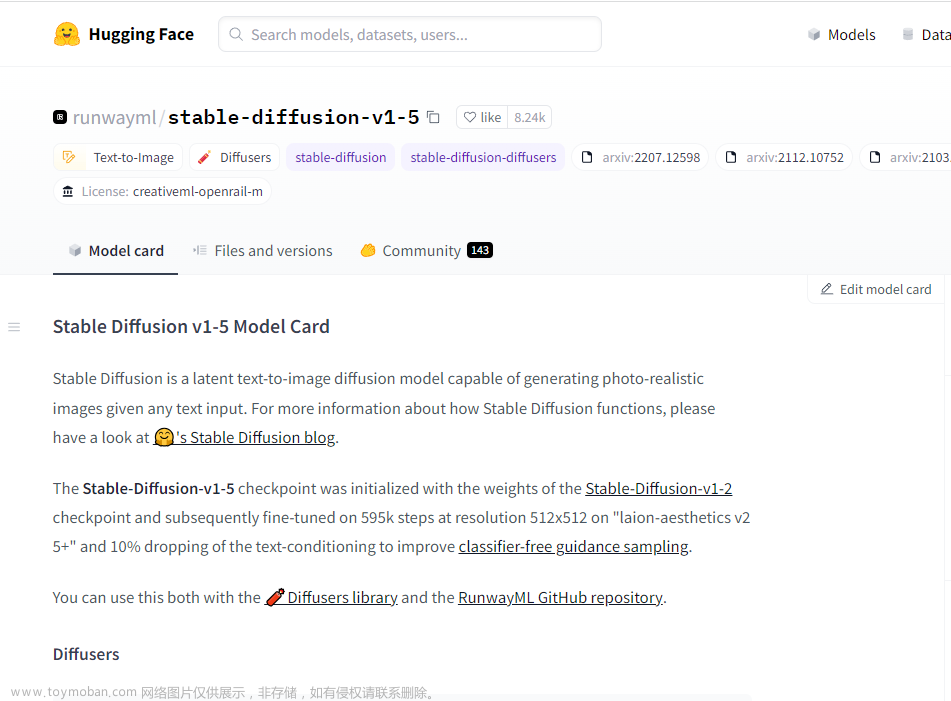

整合包

到目前为止 huggingface 应该很多地区都无法访问,导致模型文件无法下载,以下提供本人的一键整合包,解压后直接运行目录下的 RWKV-Runner_windows_x64.exe 启动即可,整合包内包含模型文件

RWKV-4-Raven-7B-v11-Eng49%-Chn49%-Jpn1%-Other1%-20230430-ctx8192.pth 文章来源:https://www.toymoban.com/news/detail-482485.html

选择的 GPU-4G-7B-CN 启动,也可以在配置页面中行转换后再使用。文章来源地址https://www.toymoban.com/news/detail-482485.html

链接:https://pan.baidu.com/s/1MqxMQ9hjvZ1ZtQo9RG2QRQ?pwd=36h7

提取码:36h7

到了这里,关于本地化部署AI语言模型RWKV指南,ChatGPT顿时感觉不香了。的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!