CVPR 2023

Co-SLAM: Joint Coordinate and Sparse Parametric Encodings for Neural Real-Time SLAM

input: RGB-D

contribution:

1.场景表示:多分辨率哈希网格(加速&保留高频特征)

2.编码方式:one-blob(提升未观察到区域的补全能力和一致性)编码方式根据场景表示(hash网格)制定

3.改进关键帧:支持在所有关键帧上执行BA

Related Work

iMap:由于实时性的要求,iMap使用系数采样和减少迭代次数提升效率,造成丢失高频细节&增大误差。

场景表示:如八叉树、哈希/体素网格等虽然可以提升效率,但缺乏MLP固有的平滑性和一致性先验,导致无法填补未观察到区域的空洞。如Nice-SLAM不能填补空洞,导致相机位姿出现漂移。

总体流程:

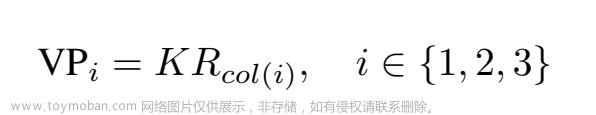

1)场景表示:联合坐标+参数编码-------MLP---------->RGB和SDF

2)tracking:最小化损失函数优化pose

3)mapping:从所有帧采样的全局射线进行全局BA,联合优化map&pose文章来源地址https://www.toymoban.com/news/detail-484293.html

vMAP: Vectorised Object Mapping for Neural Field SLAM

文章来源:https://www.toymoban.com/news/detail-484293.html

到了这里,关于NeRF+SLAM论文阅读笔记的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[论文阅读]Coordinate Attention for Efficient Mobile Network Design](https://imgs.yssmx.com/Uploads/2024/02/732600-1.png)