(零)前言

本篇主要提到ControlNet新版本的使用,和旧版本的变化,并偷懒参考了别人很不错的文章。

更多不断丰富的内容参考:🔗《继续Stable-Diffusion WEBUI方方面面研究(内容索引)》

(一)ControlNet

WEBUI的插件里,ControlNet是少数几个不需要翻译的插件,因为翻译了也没意思:控制网络?

它的作用是,用模型进一步(精确)控制生成的图片内容(主要是人像,也包括建筑风景等),

可用多种算法检测已有图片的边缘,深度,身体手部姿态。或则来自涂鸦,生成新的图片。

需要精确控制图片输出时使用,参考:ControlNet|使用教程

比如(很多控制,这里只放2个例子,简单看看吧):

-

OpenPose 姿态检测

-

Canny 边缘检测

(二)ControlNet(v1.1)

目前ControlNet升级了版本变化很大,主要是多了很多预处理器,并且模型也都更新了。

我正准备写几句,突然发现🔗openai.wiki 里更新了相关的文章,分3篇详细介绍了新版各种新模型和使用,那我就偷懒不用具体写了,参考:🔗ControlNet|V1.1版使用教程【上】

主要变化如下:

(2.1)模型

旧的模型放在:xxxx\SDWEBUI\models\ControlNet\目录中,8个模型文件,每个大约5.5GB左右。

新的模型放在:xxxx\SDWEBUI\extensions\sd-webui-controlnet\models\目录中,我这14个,每个1.5GB左右。

PS:旧模型配新预处理器也可以用?不过建议大家还是从🔗openai.wiki 的文章中去下载整合的包。

因为不仅要模型,预处理器也需要在线下载一些文件,有时网速很难完成,简直是拼人品。

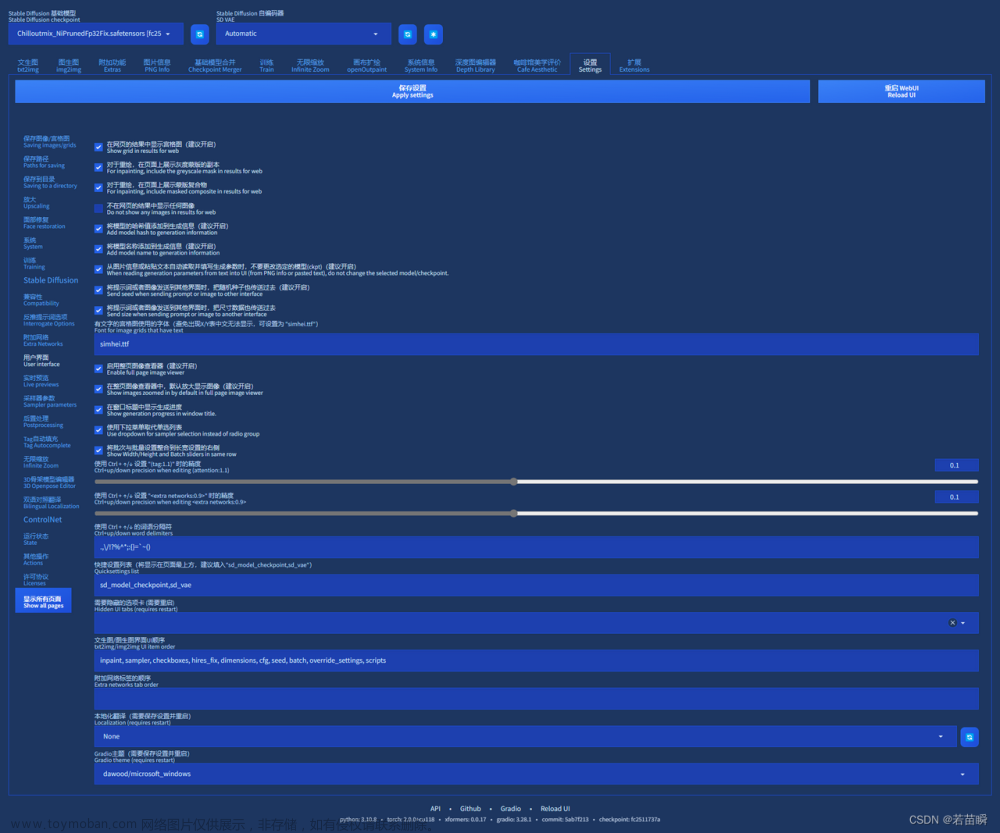

(2.2)新版界面

版本1.1是一个很大的升级,而且目前ControlNet继续疯狂的更新中。但基本用法和以前一样。

就是从已有的图片中,提取某种模型的特征信息,用于生成新的图片。

界面和以前稍微有区别,例子如下:

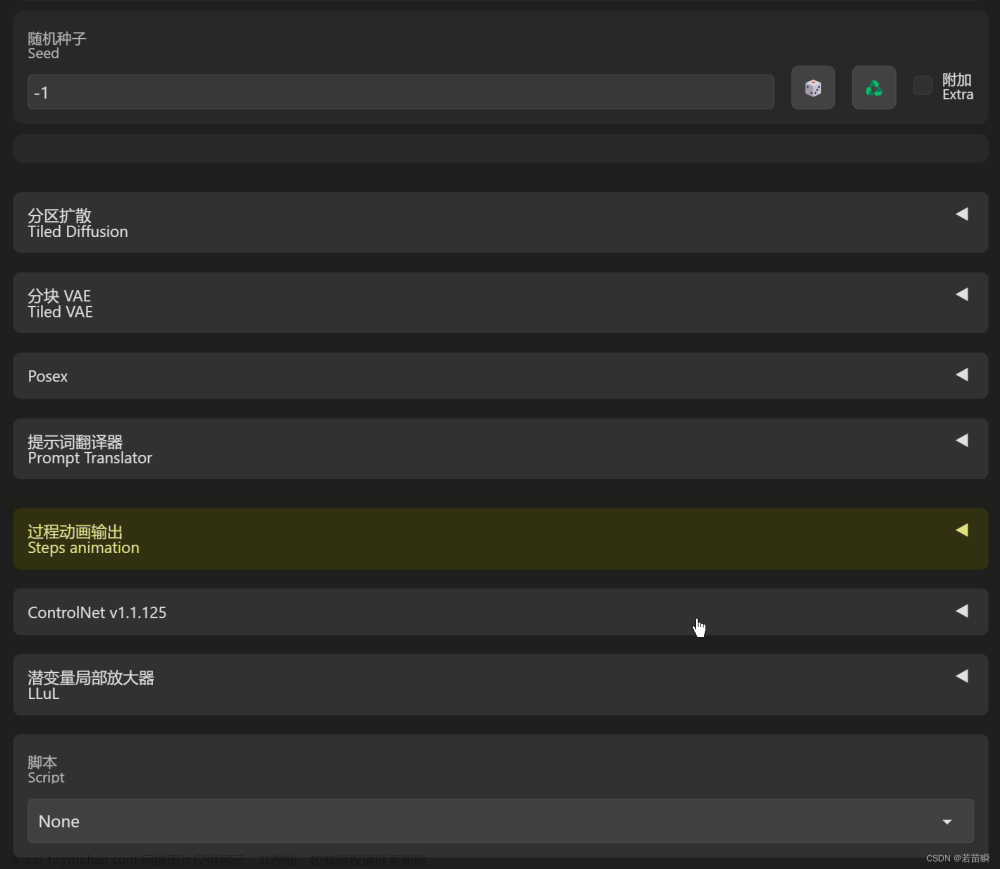

(2.3)预处理器

具体仍然看🔗openai.wiki 里面很详细。

预处理器一大堆,这里截图展示不完,下面还有一些(翻译后更加占用垂直空间-_-)。

我粗略翻译了一下:🔗Stable-Diffusion WEBUI 简体中文语言包(2023.05.01更新)

所以我这里列表看上去大概如下: 文章来源:https://www.toymoban.com/news/detail-485897.html

文章来源:https://www.toymoban.com/news/detail-485897.html

(三)偷懒

就这样了,因为别人🔗openai.wiki 的文章真的写的很清楚很详实了,希望详细了解就去看看呗。文章来源地址https://www.toymoban.com/news/detail-485897.html

到了这里,关于探索【Stable-Diffusion WEBUI】的插件:ControlNet 1.1的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!