现代企业的成功转型离不开创新,而创新离不开人工智能等前沿技术的推动。随着全球经济的发展和竞争的日益激烈,企业需要更快、更高效地交付新产品、服务和解决方案,以更好地满足客户需求并保持市场竞争力,应用研发效率提升企业竞争力已成为趋势。AIGC时代来临,通过AI智能编程工具降低企业研发投入成本、提高编程效率、减轻研发人员工作压力已成为企业数智化转型的必要手段。

aiXcoder作为国内首款已商业化落地的AI智能编程系统,基于当前SOTA的代码大模型,不仅可通过自然语言实现方法级代码生成,还能完成整行及多行的智能代码补全,帮助开发者在编写代码时保持专注力和创造性,提高软件开发效率。

在免费服务个人开发者的同时,aiXcoder同步推出企业级智能开发应用——aiXcoder「企业版」。aiXcoder「企业版」核心优势在于可进行私有化部署,并对企业代码进行个性化训练,进一步提升企业研发效率和代码质量,助力企业快速响应市场需求。

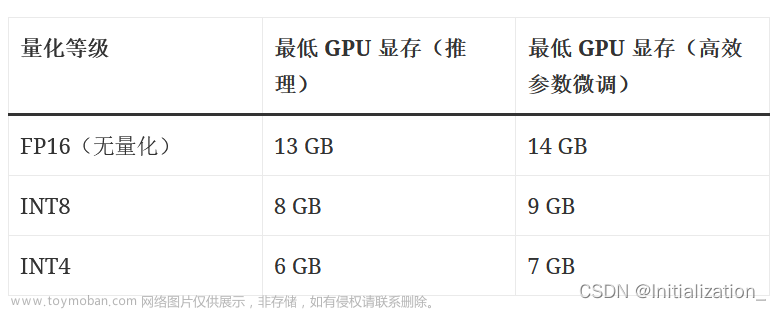

企业私有化部署包括百亿级参数大模型部署和个性化训练两部分。下面为大家详细介绍:

企业私有化部署:文章来源:https://www.toymoban.com/news/detail-486049.html

具体是指在企业内部环境下,用基于Docker的容器化技术配置好运行环境后,将aiXcoder的整套软件(包括大模型和代码)部署在企业内网的深度学习服务器上。在不连外网的情况下,企业也能使用aiXcoder提供的智能编程服务,保障企业信息及代码安全。文章来源地址https://www.toymoban.com/news/detail-486049.html

到了这里,关于aiXcoder私有化部署与大模型个性化训练:如何将AIGC应用到您的企业中?的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!