Stable Diffusion

AI 绘画最近成功破圈,成了炙手可热的热门话题。DALLE,GLIDE,Stable Diffusion 等基于扩散机制的生成模型让 AI 作图发生质变,让人们看到了“AI 转成生产力”的曙光。

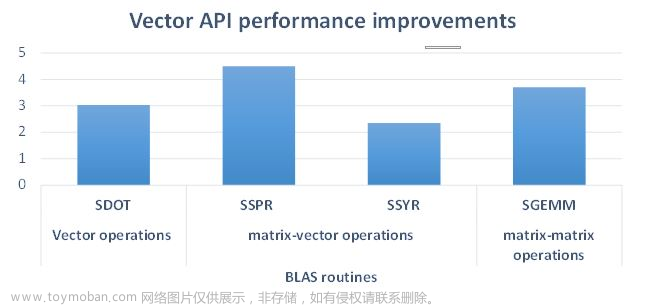

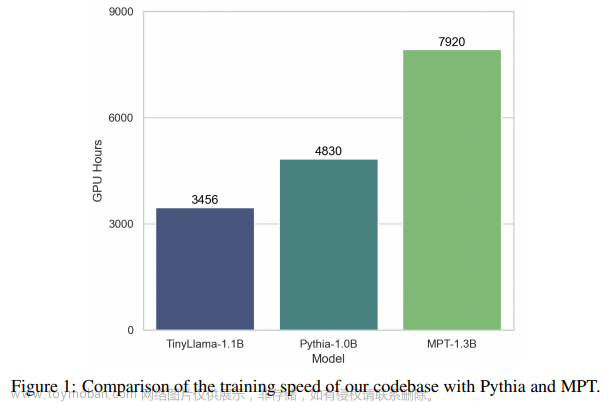

在这些扩散模型中,Stable Diffusion 以其优秀的效果和开源的权重成为了其中的代表,受到广泛的关注和体验。其基于 Laion5B 超大规模“文本 - 图像”对数据集,Stable AI 宣称用了 5000 张 A100 耗时几个月训练而成。幻方 AI 近期在萤火二号上使用 Google Caption 数据集复现了 Stable Diffusion 的训练,并进行了优化。通过幻方自研的 hfai.pl 插件将源代码 Pytorch Lightning 框架与萤火集群的特性轻松整合,并通过 3FS、hfreduce、算子等优化工具对模型训练提速。

本文将分享我们对 Stable Diffusion 训练优化的心得体验,帮助研究者和开发者们降低研究门槛。

论文标题:High-Resolution Image Synthesis with Latent Diffusion Models

原文地址:https://arxiv.org/abs/2112.10752文章来源:https://www.toymoban.com/news/detail-486050.html

<文章来源地址https://www.toymoban.com/news/detail-486050.html

到了这里,关于萤火跑模型 | 高性能 Stable Diffusion 助力高质量 AI 绘图的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!