Rust实现的纯 CPU 运算的 LLaMA 模型

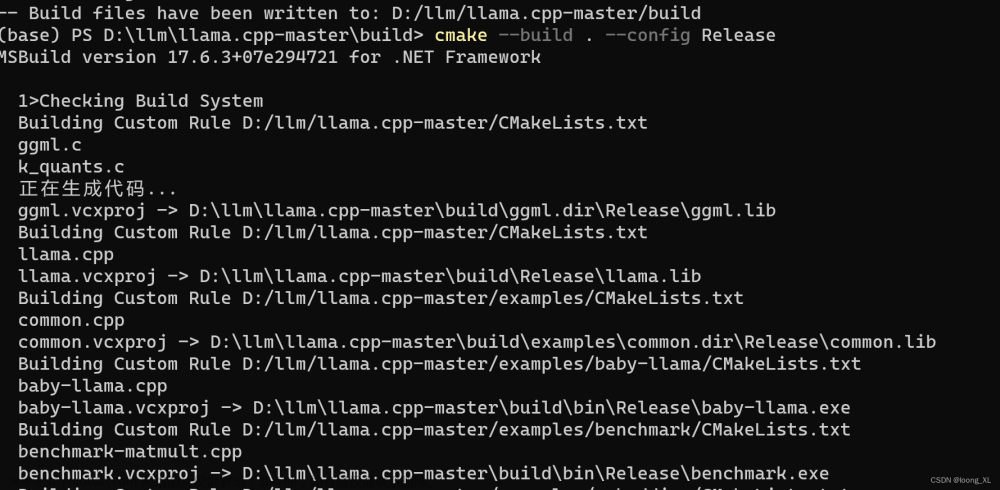

我试图让 LLaMA 语言模型在纯 CPU实现上工作,灵感来自于这里的一个很棒的CPU实现:https://github.com/ggerganov/ggml,它可以运行GPT-J 6B模型。

在我的蹩脚的 OpenCL 的代码下,我的GTX 3090上可以实现每个 Token 耗时 270毫秒。在Ryzen 3950X上使用纯 CPU 和 OpenCL,我可以使每个 Token 700ms左右。而在没有任何 OpenCL 的情况下,只用纯Rust代码,加上我手写的一些 AVX2 实现,每个令牌大约1秒。所有这些都运行在LLaMA-7B模型上。

ReadMore: https://github.com/Noeda/rllama

Sqlx 编译速度分析

sqlx真的很好,但你肯定会对编译时间印象深刻。即使使用Ryzen 3700,cargo check 也需要比较长的时间才能运行结束,而这成了一个喝咖啡休息的好借口。我想要看下到底在这背后发生了什么。

ReadMore: https://cosmichorror.dev/posts/speeding-up-sqlx-compile-times/

Rust编码风格

这篇文章是高阶一点的针对 Rust 编码风格的讨论(因为它没有涉及到具体的细节),部分灵感来自于面向数据的设计,部分灵感来自于基于ML的函数式编程语言,我认为这很自然地适用于Rust,并使得 API 更人性化且灵活易于扩展。这不是什么高级的东西,但我希望这对刚接触Rust的人起到一些作用。

ReadMore: https://tzemanovic.gitlab.io/posts/rust-coding-style/

From 日报小组 Koalr

社区学习交流平台订阅:

Rustcc论坛: 支持rss文章来源:https://www.toymoban.com/news/detail-487132.html

微信公众号:Rust语言中文社区文章来源地址https://www.toymoban.com/news/detail-487132.html

到了这里,关于【Rust日报】2023-03-14 Rust实现的纯 CPU 运算的 LLaMA 模型的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[llama懒人包]ChatGPT本地下位替代llama-7b,支持全平台显卡/CPU运行](https://imgs.yssmx.com/Uploads/2024/02/521746-1.png)