什么是Python3网络爬虫?

定义:

网络爬虫(Web Spider),又被称为网页蜘蛛,是一种按照一定的规则,自动地抓取网站信息的程序或者脚本。爬虫其实是通过编写程序,模拟浏览器上网,然后让其去互联网上抓取数据的过程。

爬虫的价值:

抓取互联网上的数据,为我所用,有了大量的数据,就如同有了一个数据银行一样,下一步就是如何将这些数据产品化、商业化。

爬虫是否合法

网络爬虫在法律中是不被禁止,但是具有违法风险,通常来说爬虫分为善意的爬虫和恶意的爬虫。爬虫带来的风险可以体现在如下两个方面:

- 爬虫干扰了被访问网站的正常运营

- 爬虫抓取了受法律保护的特定类的数据或信息

那么我们如何在使用编写爬虫的过程中避免进入局子的厄运呢?

- 时常优化自己的程序,避免干扰被访问网站的正常运行

- 在使用、传播爬取到的数据时,审查抓取到的内容,如果发现涉及到用户隐私或者商业机密等敏感内容,需要及时停止爬取或传播

爬虫在使用场景中的分类

- 通用爬虫抓取系统重要组成部分,抓取的是一整张页面数据

- 聚焦爬虫是建立在通用爬虫的基础之上,抓取页面中特定的局部内容

- 增量式爬虫检测网站中数据更新的情况,只会爬取网站中最新更新出来的数据

爬虫的矛与盾

反爬机制:门户网站,可以通过制定相应的策略或者技术手段,防止爬虫程序进行网站数据的爬取。反反爬策略:爬虫程序可以通过制定相关的策略或者技术手段,破解门户网站中具备的反爬机制,从而可以获取门户网站中相关的数据。

下面,我们来了解一下网络爬虫中一个重要的协议:robots.txt协议。robots.txt协议是一个君子协议,协议中规定了网站中哪些数据可以被爬取哪些数据不能被爬取。

http协议和https协议

http协议:就是服务器和客户端进行数据交互的一种形式。http协议中常用的请求头信息:

- User-Agent:请求载体的身份标识

- Connection:请求完毕后,是断开连接还是保持连接http协议中常用的响应头信息:

- Content-Type:服务器响应回客户端的数据类型https协议其实就是一种安全的http协议

2.网页审查元素

在爬虫内容之前,我们需要先学习一项写爬虫的必备技能:审查元素(如果已掌握,可跳过此部分内容)。

审查元素

在浏览器的地址栏输入URL地址,在网页处右键单击,找到检查。(不同浏览器的叫法不同,Chrome浏览器叫做检查,Firefox浏览器叫做查看元素,但是功能都是相同的)

点击检查我们可以看到,右侧出现了一大推代码,这些代码就叫做HTML。什么是HTML?举个容易理解的例子:我们的基因决定了我们的原始容貌,服务器返回的HTML决定了网站的原始容貌。

为啥说是原始容貌呢?

文章来源地址https://www.toymoban.com/news/detail-488333.html

说这么多,什么意思呢?浏览器就是作为客户端从服务器端获取信息,然后将信息解析,并展示给我们的。我们可以在本地修改HTML信息,为网页”整容”,但是我们修改的信息不会回传到服务器,服务器存储的HTML信息不会改变。刷新一下界面,页面还会回到原本的样子。这就跟人整容一样,我们能改变一些表面的东西,但是不能改变我们的基因。

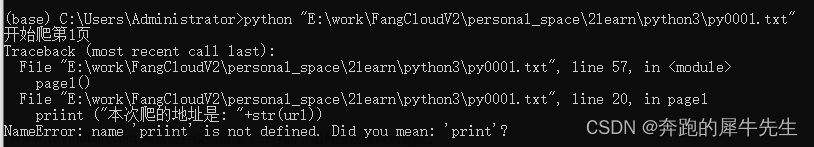

简单实例

网络爬虫的第一步就是根据URL,获取网页的HTML信息。在Python3中,可以使用urllib.request和requests进行网页爬取。

- urllib库是python内置的,无需我们额外安装,只要安装了Python就可以使用这个库。

- requests库是第三方库,需要我们自己安装。

requests库强大好用,所以本文使用requests库获取网页的HTML信息。requests库的github地址:GitHub - psf/requests: A simple, yet elegant, HTTP library.

安装request库

在cmd中,使用如下指令安装requests:

pip install requestseasy_install requestsrequests库的基础方法如下:

requests库的开发者为我们提供了详细的中文教程,查询起来很方便。本文不会对其所有内容进行讲解,摘取其部分使用到的内容,进行实战说明。

首先,让我们看下requests.get()方法,它用于向服务器发起GET请求,不了解GET请求没有关系。我们可以这样理解:get的中文意思是得到、抓住,那这个requests.get()方法就是从服务器得到、抓住数据,也就是获取数据。让我们看一个例子(以 www.gitbook.cn为例)来加深理解:

import requests

if __name__ == '__main__':

target = 'http://gitbook.cn/'

req = requests.get(url=target)

print(req.text)

文章来源:https://www.toymoban.com/news/detail-488333.html

到了这里,关于爬虫小白应该如何学习爬虫的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!