Abstract

对于一个 bot 来说,它一生中看到的最多的对话是出现在它被部署到生产环境之后,这就产生了大量未被利用的训练数据。本文提出一种 自馈对话机器人(self-feeding chatbot),它能够从它自己参与的对话中自动抽取新的训练样本。

在该 bot 参与对话的过程中,它还会评估用户的满意度。

- 当对话进展良好时,用户的回复成为需要模拟的训练样本

- 当 bot 认为自己犯了错误时,它会询问用户以获得反馈

- 学习预测这种反馈可以进一步提高 bot 的对话技能

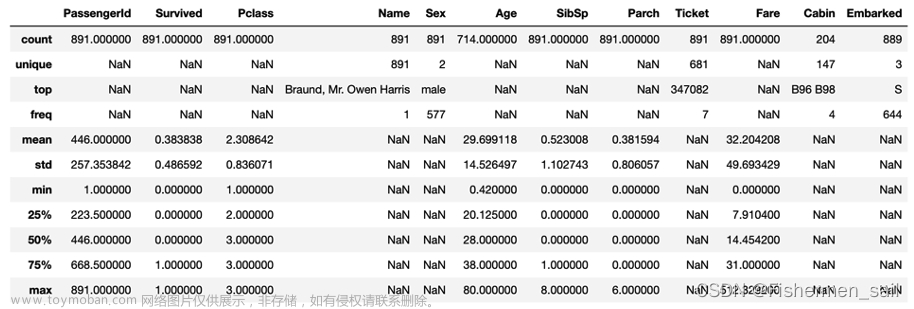

在 PERSONACHAT 闲聊数据集上(包含 131k 训练样本),我们发现无论传统监督的数量如何,使用自馈对话机器人从对话中学习都显著提高了性能。文章来源:https://www.toymoban.com/news/detail-488734.html

1 Introduction

训练一个 bot 使之像人类那样对话需要大量的监督。最常见的方式是训练一个模型来模拟大量众包或爬取的对话语料中的人类回复 (Serban et al., 2015)。这些对话语料要么收集代价高昂,要么其设置和真实的部署环境存在很大差别。相比之下,bot 最理想的学习方式是部署后从自己参与的对话中学习,因为此时遇到的样本往往是丰富、特定于具体任务、动态的以及廉价的。这和人类学习说话的方式类似,不仅仅是观察其他人进行 “专家级” 的对话,而是根据交织于我们自己的对话中的反馈,积极调整和纠正我们的对话。对于一个对话机器人来说,通过这项技能,它能够在它的一整个机生中持续提升和文章来源地址https://www.toymoban.com/news/detail-488734.html

到了这里,关于Learning from Dialogue after Deployment: Feed Yourself, Chatbot!的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!