【ROS】郭老二博文之:ROS目录

1、安装ROS1

【ROS】Ubuntu20.04安装ROS1

2、安装Anaconda

【AI】PyTorch入门(一):通过Anaconda安装PyTorch

【PyThon】Anaconda常用命令

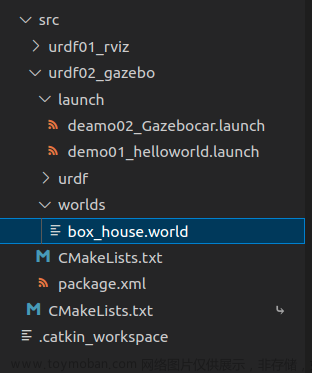

3、源码下载

使用论文 Goal-Driven Autonomous Exploration Through Deep Reinforcement Learning 的源码实例文章来源:https://www.toymoban.com/news/detail-490378.html

git clone https://github.com/reiniscimurs/DRL-robot-navigation

4、编译

conda activate pytorch

cd ~/DRL-robot-navigation/catkin_ws

catkin_make -DPYTHON_EXECUTABLE=/usr/bin/python3

注意文章来源地址https://www.toymoban.com/news/detail-490378.html

到了这里,关于【ROS】ROS+Gazebo强化学习:训练的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!