快速上手Python爬虫:网络爬虫基础介绍及示例代码

一、什么是网络爬虫?

网络爬虫,又称为 Web 爬虫、网络蜘蛛、网络机器人,在英文中被称为 web crawler,是一种自动化程序,能够在互联网上自动获取数据、抓取信息,并将其存储在本地或远程数据库中。它可以帮助我们自动化处理大量数据,提高工作效率,更好地利用互联网资源。

现代互联网上有亿万网页,如果要手工去访问每一个网页获取数据,无论从时间还是人力成本上来说,都是不可承受之重。而网络爬虫可以自动化地访问互联网上的网页、获取数据并存储到数据库中,进而为我们提供海量的数据资源。

二、网络爬虫的基本流程

首先,我们需要指定一个或多个目标 URL,这些 URL 是我们想要访问的网页。

接下来,我们需要向目标 URL 发送 HTTP 请求,并获取服务器返回的 HTML 文件内容。在发送请求时,我们可以通过设置请求头信息模拟浏览器行为,让服务器认为我们是真正的浏览器进行访问。

获取到 HTML 文件后,我们需要对其进行解析,提取出我们需要的信息。这里可以使用第三方库如 BeautifulSoup、lxml 等来进行解析,也可以手动编写正则表达式进行提取。

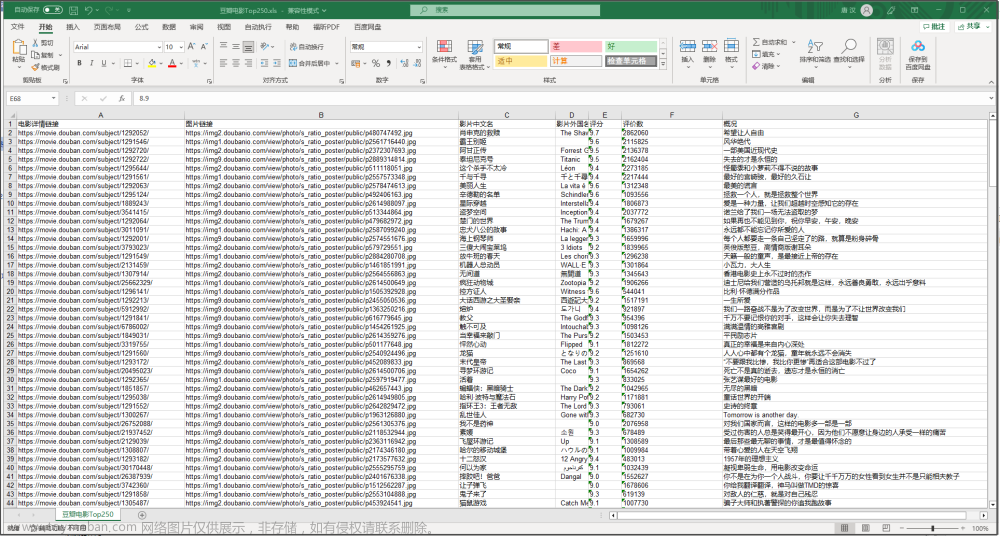

最后,我们可以将提取到的数据存储到本地或远程数据库中,以便后续的分析和使用。

三、Python 爬虫的示例代码

以下是一个 Python 爬虫的示例代码,用于获取百度搜索 “python” 的结果,并输出标题和链接。

import requests

from bs4 import BeautifulSoup

# 设置请求头,模拟浏览器

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'

}

# 发送请求,获取网页内容

url = 'https://www.baidu.com/s?wd=python'

response = requests.get(url, headers=headers)

html = response.text

# 解析 HTML,提取需要的信息

soup = BeautifulSoup(html, 'html.parser')

results = soup.find_all('div', attrs={'class': 'result'})

for result in results:

title = result.h3.get_text()

link = result.a['href']

print(title, link)

以上代码中,我们首先设置了请求头,随后使用 requests 库向目标 URL 发送 HTTP 请求,并设置请求头信息,之后获取服务器返回的 HTML 文件内容。接着,我们使用 BeautifulSoup 库解析 HTML 文件,并提取出需要的信息,这里我们选择提取每个搜索结果的标题和链接。最后,我们循环遍历所有搜索结果,打印输出标题和链接。文章来源:https://www.toymoban.com/news/detail-492738.html

四、网络爬虫的注意事项

在进行网络爬取时需要遵守法律法规并尊重网站的 robots.txt 规则,以免触犯法律或侵犯他人权益。另外,由于网络爬虫具有高效、快速的特点,在数据采集过程中还需注意不要对服务器造成过大的负荷,以免服务器被判定为恶意攻击并被拉入黑名单。文章来源地址https://www.toymoban.com/news/detail-492738.html

到了这里,关于快速上手Python爬虫:网络爬虫基础介绍及示例代码的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!