在自动驾驶感知系统中,一个目标(例如其他车辆或行人)的信息一般来自多个不同的传感器,如 LiDAR(激光雷达)、相机、毫米波雷达等。这些传感器提供的数据需要通过传感器融合技术进行整合,以得到目标的详细状态,包括位置、大小、朝向、速度以及其在图像或点云中的边界框(Bounding Box,简称BBX)。以下是大致的融合过程:

1. 数据预处理:首先,将各种传感器的原始数据进行预处理,包括去噪声、坐标转换等,使数据可以进行后续处理。

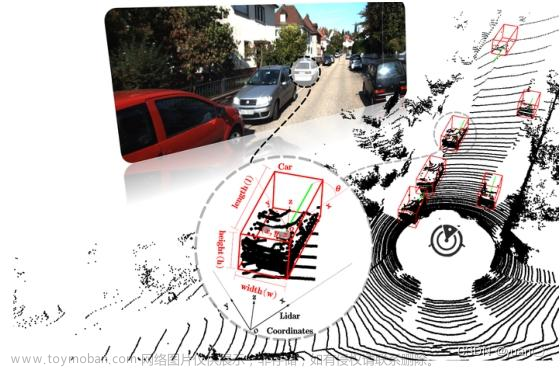

2. 物体检测:接着,在每个传感器的数据中进行物体检测。例如,对于 LiDAR,可能使用点云分割算法来检测出单独的物体;对于相机,可能使用深度学习的物体识别算法。每个物体都会被赋予一个边界框(Bounding Box)。

3. 数据关联与融合:然后,需要确定来自不同传感器的物体检测结果是否属于同一目标。这通常通过时间戳和空间位置来实现。如果两个检测结果被认为是同一个目标,那么就将它们融合在一起,生成一个“融合”边界框,这通常可以通过计算各个检测结果的加权平均来实现。

4. 状态估计:最后,根据融合后的边界框以及相关的传感器数据,可以计算出目标的位置、大小、朝向和速度。例如,位置通常就是边界框的中心,大小是边界框的尺度,朝向可能来自于检测算法的输出或者通过连续几帧的位置变化来估计,速度则可以通过连续几帧的位置差值除以时间差值来计算。

注意

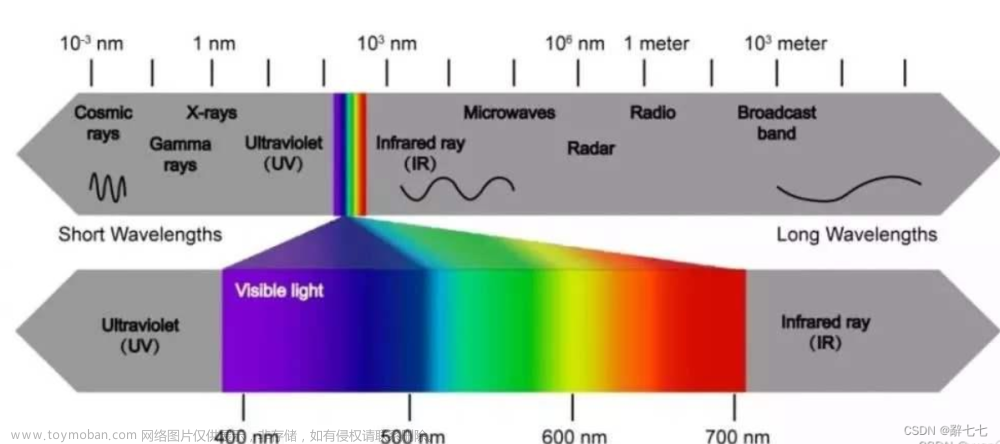

不同类型的传感器有不同的优势和局限性。例如,LiDAR 可以提供精确的距离和形状信息,但无法获取色彩信息;Camera 可以提供丰富的色彩和纹理信息,可以用于红绿灯状态识别,但在距离估计上不如 LiDAR 准确。因此,传感器融合的目标就是要结合所有传感器的优点,尽量减少各自的缺点,以获得最准确的目标状态。

关于感知物体 位置、速度的输出

在自动驾驶中,对于目标的位置、大小、朝向和速度的计算,通常是通过一种称为“多传感器融合”的策略来实现的。这个过程涉及到使用来自各种传感器(例如LiDAR、相机、毫米波雷达等)的数据,并将这些数据整合在一起以获得对物体特性的更准确估计。

-

位置:位置可以从LiDAR或者相机得到的边界框中计算出来,通常取边界框的几何中心作为目标的位置。具体地,对于二维边界框,位置就是其左上角和右下角坐标的平均值;对于三维边界框(如从LiDAR获取的),位置则是八个顶点坐标的平均值。

-

大小:大小通常由由三维LiDAR点云得到的边界框来定义,包括长、宽和高。对于一个三维边界框,长度、宽度和高度分别为其在x,y,z方向上的尺寸。

-

朝向:朝向可能由附在目标上的IMU(惯性测量单元)直接测量,或者根据连续几帧图像中目标移动的路径推断,或者通过主成分分析(PCA)等算法从点云数据中提取。

-

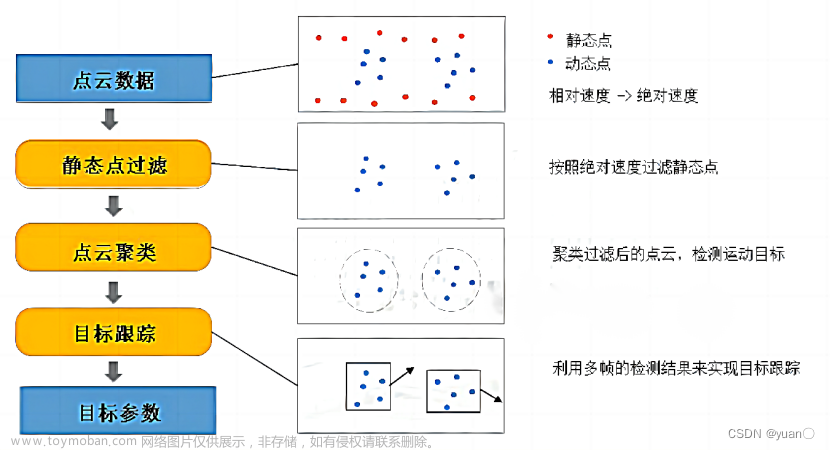

速度:速度也可以由IMU直接测量,或者通过分析连续几帧图像中目标位置的变化计算得到。

在带有雷达的系统中,雷达也可以提供额外的信息。例如,雷达可以测量物体的距离和相对速度(通过多普勒效应)。这些信息可以用来校正其他传感器的数据,或者在其他传感器无法工作(如在恶劣天气条件下)时提供额外的感知能力。

超声波在行车相关功能使用较少的原因

虽然超声波传感器在某些方面(例如,探测近距离目标)表现出色,但在自动驾驶应用中使用较少的原因包括:

1. 有限的检测范围:超声波传感器通常只能在短距离内有效地检测物体(通常不超过几米)。这对于自动驾驶系统来说远远不够,尤其是在高速行驶的情况下,该系统需要提前较长距离检测到障碍物。

2. 精度和分辨率限制:超声波传感器的空间分辨率较低,无法提供精细的物体形状和位置信息。对于复杂的自动驾驶环境,这可能导致识别和定位障碍物的能力较弱。

3. 易受环境干扰:超声波传感器可能受到风、雨、温度和其他噪音源的影响,从而降低其性能。

4. 数据处理复杂性:超声波传感器数据的解析和处理相比光学或雷达传感器要复杂得多,这增加了自动驾驶系统的计算负荷。

因此,虽然超声波传感器在某些特定应用(如停车辅助)中仍然有其用处,但在更广泛的自动驾驶场景中,激光雷达(LiDAR)、摄像头和毫米波雷达等设备往往更受欢迎,因为它们可以提供更远的检测距离,更高的精度和分辨率,以及更稳定的性能。

IMU

惯性测量单元(Inertial Measurement Unit,简称IMU)在自动驾驶中发挥着重要的角色。 IMU 是一种传感器设备,它通过内置的加速度计和陀螺仪来测量和报告一个设备的特定物理特性,包括:

- 角速度:陀螺仪可以测量设备绕其轴线旋转的速度,有助于确定设备的方向或者姿态。

- 线加速度:加速度计可以测量设备沿各个轴线的加速度,这可以用来推断设备的运动状态。

在自动驾驶系统中,IMU 的主要作用包括:

1. 提供车辆动态信息:IMU 可以实时提供车辆的加速度和角速度信息,这对于理解车辆的当前运动状态(如行驶速度、转弯角度等)非常重要。

2. 辅助定位和导航:通过积分加速度和角速度,可以得到车辆的相对位置和姿态变化,这在GPS信号不佳或丢失的情况下,可以提供关键的备份定位和导航信息。

3. 传感器融合:IMU 数据经常与其他传感器(如 GPS、LiDAR 和相机)的数据进行融合,以提高系统的整体性能。例如,GPS 可以提供绝对位置,但更新率较低,易受环境影响;而 IMU 可以提供高频率的相对移动信息,两者结合可以获得更稳定、准确的位置信息。

4. 状态估计和控制:IMU 数据也被用于车辆的状态估计和控制算法中,例如判断是否在上坡/下坡驾驶,是否在滑行等。文章来源:https://www.toymoban.com/news/detail-493473.html

尽管 IMU 在自动驾驶中起着重要作用,但它也有一些局限性,例如由于噪声和漂移的累积,使得长时间积分后的位置和姿态误差可能变大,因此需要定期通过其他传感器(如 GPS 或 LiDAR)进行校正。文章来源地址https://www.toymoban.com/news/detail-493473.html

到了这里,关于自动驾驶数据融合的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!