书接上回,本篇的目的是结合上篇生成虚拟的女生形象,以及上一篇生成的关于介绍AI绘画领域的脚本,让生成的虚拟形象来念这段文案。先进入正题说明怎么来生成想要的动态视频。

1. Yanderify项目

Yanderify 教程

来实际手把手操作一下这个项目

Yanderify:https://github.com/dunnousername/yanderifier

在其中找到“Release”链点,下载最新发布的Zip包即可。包有1.63个G,需要些下载时间

-

yanderify.zip解压后,

-

把checkpoint.tar 复制到 yanderify目录下。checkpoint.tar在界面的the chekepoint上,点击即可下载

-

去下面的链接单独下载一个ffmpeg-win32-v3.2.4.exe文件:https://github.com/imageio/imageio-binaries/tree/master/ffmpeg

找到ffmpeg-win32-v3.2.4.exe文件,点开后点击download(遇到无法打开网页时可参考这种方法) -

把ffmpeg-win32-v3.2.4.exe 复制到 “C:\Users\你的用户\AppData\Local\imageio\ffmpeg” 下(imageio\ffmepge需要新建)。

此处可以注意下,AppData\Local文件夹可能隐藏,点击文件资源管理器右上角的查看,勾选右下方隐藏的项目 -

双击启动yanderif.exe

这里首先选择你要参考的视频(歌唱或者说话视频),然后选择图片(让图片说话或唱歌)、然后select output是选择输出文件的命名和存放位置,都做好了之后output

测试Yanderify

选择视频:damedane

https://pan.baidu.com/share/init?surl=D1CaifLhwEzVXv-vLAsAwg 提取码:ssr5

选择图片

成果

yanderify生成视频

体验

没眼看,可能还是比较看重输入视频和输入图片的大小、位置的统一性的,就不再试了,有兴趣的朋友们再试试

注意:[软件本体,checkpoint.tar,ffmepg]缺一不可,否则会出现各种莫名其妙的闪退甚至打不开软件

-

不能下载解压后直接双击yanderif.exe:否则双击后黑屏提示电脑上没有ffmpeg-win32-v3.2.4.exe,会显示尝试下载,但也会error to fetch files

-

不能没有checkpoint.tar,否则loading后直接闪退

插一句

此外,博主参加了一个社区,内容是关于 AI的国内平台副业案例库 , 适合普通人的低门槛案例。适合想搞副业,但不知道玩法的普通人。专栏订阅后,永久可以查看,初始价格 19 元 ,一顿饭钱感觉很便宜就加入了,但后期据说每多加500人涨10块,同样有这方面想法的小伙伴可以赶在涨价前速速加一下哦~

扫下图的码即可

2. 让照片说话的软件有哪些?介绍几款好用的

参考这个链接中的几个APP,有书单视频助手、Wombo AI、Reface,感兴趣的同学可以尝试。

3. 另外还有开源模型:speech-driven-animation

End-to-End Speech-Driven Facial Animation with Temporal GANs

相关介绍:造假AI又进化!只要一张照片,说话唱歌视频自动生成,降维打击Deepfakes丨已开源,链接中包含效果视频

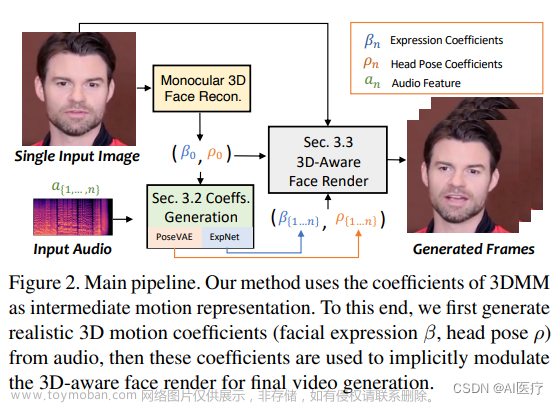

论文内容简介:

该论文的研究主旨是将语音信号与面部动画之间的联系进行建模,通过使用时序生成对抗网络(Temporal GANs)来实现端到端的语音驱动面部动画生成。

在该研究中,研究人员提出了一种基于时序GAN的端到端语音驱动面部动画生成方法,称为TDN (Temporal Dynamics Network)。研究人员借用这种时序生成对抗网络,使用两个时间鉴别器,对生成的视频进行视听对应,来生成逼真的面部动作。就是这样,无需造价高昂的面部捕捉技术,只需这样一个网络,就能将一张照片+一段音频组合成流畅连贯的视频了。

该研究还使用了大量的数据进行实验,并得到了比其他传统方法更好的结果。实验证明,TDN模型能够准确地捕捉语音信号和面部动画之间的联系,从而生成更加真实和自然的面部动画。这个研究为语音驱动面部动画生成领域提供了新的思路和方法,具有较高的理论和实际应用价值。

[1] [https://sites.google.com/view/facial-animation/home]

该网址为面部动画方面的资源网站,主要涵盖了Speech-Driven Facial Animation这篇论文呢的研究成果、技术方案等方面的内容,有很多示例视频,可以看出来效果都不错。网站还给出了模型和论文的地址。

开源模型:

https://github.com/DinoMan/speech-driven-animation

模型输入输出

但是这个模型并不可以直接输入文案,而是输入音频文件和照片,所以如果还想用自己的文案,就需要先文字转配音或者自己配音,可以随便百度个在线的文字转配音网站。

本文中用到的工具介绍:D-iD

网站:https://www.d-id.com/,只要输入图像和文本,就可以一键生成你想要的视频

d-id.com 是一家人工智能技术公司,其主要业务是提供面部动画服务。该服务可以让用户通过上传自己的照片或视频,然后使用 d-id 的 AI 技术进行面部动画转换,生成逼真而专业的人物动态视频。

使用 d-id 的面部动画服务非常简单,只需要在它们的网站上上传需要转换的照片或视频,然后选择你想要的面部动画风格即可。d-id 的 AI 技术会自动分析照片或视频中的面部特征,并根据所选的动画风格进行处理,最终生成一段高质量的、会说话的面部动画。

d-id 的收费标准因所需服务的不同而有所不同,可以前往他们的官方网站了解更多信息。此外,d-id 还为客户提供免费试用期,让客户先尝试其服务再进行购买决定,网站提供20个credits作为free trial。

步骤

-

登录 https://www.d-id.com/,点free trial

-

注册账号或者直接使用谷歌账号登录

-

选择“create video”选项,然后上传你想要进行面部动画处理的照片。

-

在上传完成后,选择所需的人像模板。d-id 提供多种人像模板供用户选择,如上图所示

-

在右边的script框里输入你想要的文案,然后选择语言类别,你想要的声音类型,以及风格等等,完成一些个性化设置

-

上述步骤都做完后,点击右上角generate video按钮,d-id 的 AI 技术会自动将你的照片转换为逼真的面部视频。该过程花费时间有文案长度而定。

-

预览并下载你的面部动画视频文件。在 d-id 网站上,你可以预览生成的面部动画,在确认满意后,你可以选择下载这个文件。花费的credit数会随着文案长度增加而增加

花费:生成了一段3分半钟的影片,使用了14个credits

结果

New creative video

个人看法

生成的效果有点太孬了,很粗糙,不知道是不是因为我生成的虚拟形象本身就不够真实,可以直接上传真实的网图人像搭配文案看看效果如何

首先不能涉及人像版权,所以可以先找找不涉及图像版权的

17个免费高质量无版权的图片、视频网站,抓紧收藏!

我就直接使用它官方给出的人物形象了

New creative video (1)

可以看出来嘴形还是很奇怪,唇语仿佛在讲粤语,干脆最后用同样的人物形象生成一个粤语的

New creative video (2)

果然!!!!!!生成粤语的嘴唇看起来就顺畅很多,可能这个软件不太适合mandarin吧文章来源:https://www.toymoban.com/news/detail-493953.html

教程来源:在youtube上的一个博主发布的教学视频文章来源地址https://www.toymoban.com/news/detail-493953.html

到了这里,关于AI绘画与虚拟人生成实践(三):让虚拟形象动起来!照片生成说话的视频的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!