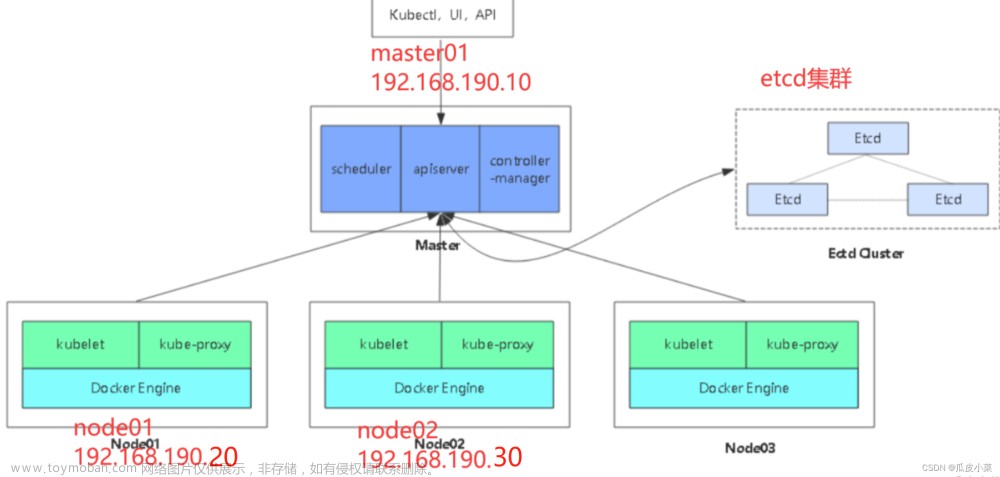

单master集群架构图:

实验环境(二进制搭建 Kubernetes v1.20)

注意:生产环境中,etcd集群和master、node节点都应该部署在不同的机器上,此处为了实验方便,将三台etcd节点分别部署在了master和node节点上了

k8s集群master01:192.168.126.27 kube-apiserver kube-controller-manager kube-scheduler etcd

k8s集群master02:192.168.80.21

k8s集群node01:192.168.80.11 kubelet kube-proxy docker

k8s集群node02:192.168.80.12

etcd集群节点01:192.168.126.27

etcd集群节点02:192.168.126.28

etcd集群节点03:192.168.126.29

负载均衡nginx+keepalive01(master):192.168.126.22

负载均衡nginx+keepalive02(backup):192.168.126.23

1.操作系统初始化配置

#以下三台同时操作

systemctl stop firewalld

systemctl disable firewalld

iptables -F && iptables -t nat -F && iptables -t mangle -F && iptables -X

#关闭selinux

setenforce 0

sed -i 's/enforcing/disabled/' /etc/selinux/config

#关闭swap

swapoff -a

sed -ri 's/.*swap.*/#&/' /etc/fstab

#根据规划设置主机名

hostnamectl set-hostname master01

hostnamectl set-hostname node01

hostnamectl set-hostname node02

#添加hosts

cat >> /etc/hosts << EOF

192.168.126.27 master01

192.168.126.28 node01

192.168.126.29 node02

EOF

#调整内核参数

cat > /etc/sysctl.d/k8s.conf << EOF

#开启网桥模式,可将网桥的流量传递给iptables链

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

#关闭ipv6协议

net.ipv6.conf.all.disable_ipv6=1

net.ipv4.ip_forward=1

EOF

sysctl --system #加载

#时间同步

yum install ntpdate -y

ntpdate time.windows.com2. 部署 etcd 集群(分布式键值对数据库)

etcd是CoreOS团队于2013年6月发起的开源项目,它的目标是构建一个高可用的分布式键值(key-value)数据库。etcd内部采用raft协议作为一致性算法,etcd是go语言编写的。

etcd 作为服务发现系统,有以下的特点:

简单:安装配置简单,而且提供了HTTP API进行交互,使用也很简单

安全:支持SSL证书验证

快速:单实例支持每秒2k+读操作

可靠:采用raft算法,实现分布式系统数据的可用性和一致性

etcd 目前默认使用2379端口提供HTTP API服务, 2380端口和peer通信(这两个端口已经被IANA(互联网数字分配机构)官方预留给etcd)。 即etcd默认使用2379端口对外为客户端提供通讯,使用端口2380来进行服务器间内部通讯。

etcd 在生产环境中一般推荐集群方式部署。由于etcd 的leader选举机制,要求至少为3台或以上的奇数台

准备签发证书环境

CFSSL 是 CloudFlare 公司开源的一款 PKI/TLS 工具。 CFSSL 包含一个命令行工具和一个用于签名、验证和捆绑 TLS 证书的 HTTP API 服务。使用Go语言编写。

CFSSL 使用配置文件生成证书,因此自签之前,需要生成它识别的 json 格式的配置文件,CFSSL 提供了方便的命令行生成配置文件。

CFSSL 用来为 etcd 提供 TLS 证书,它支持签三种类型的证书:

1、client 证书,服务端连接客户端时携带的证书,用于客户端验证服务端身份,如 kube-apiserver 访问 etcd;

2、server 证书,客户端连接服务端时携带的证书,用于服务端验证客户端身份,如 etcd 对外提供服务;

3、peer 证书,相互之间连接时使用的证书,如 etcd 节点之间进行验证和通信。

这里全部都使用同一套证书认证。

1)在 master01 节点上操作(即etcd01)

#准备cfssl证书生成工具

wget https://pkg.cfssl.org/R1.2/cfssl_linux-amd64 -O /usr/local/bin/cfssl

wget https://pkg.cfssl.org/R1.2/cfssljson_linux-amd64 -O /usr/local/bin/cfssljson

wget https://pkg.cfssl.org/R1.2/cfssl-certinfo_linux-amd64 -O /usr/local/bin/cfssl-certinfo

chmod +x /usr/local/bin/cfssl*

#-O:指定下载目录

#Linux命令行两种下载方式:

#wget 源URL地址 [-O 下载到指定路径]

#curl 源URL地址 [-o 下载到指定路径]

#cfssl:证书签发的工具命令

#cfssljson:将 cfssl 生成的证书(json格式)变为文件承载式证书

#cfssl-certinfo:验证证书的信息

#cfssl-certinfo -cert <证书名称> #查看证书的信息

#------------------------生成Etcd证书-----------------------

#k8s目录用于存放生成证书的脚本文件

mkdir /opt/k8s/

cd /opt/k8s/

#上传 etcd-cert.sh 和 etcd.sh 到 /opt/k8s/ 目录中,为两个文件增加执行权限

chmod +x etcd-cert.sh etcd.sh

#创建用于生成CA证书、etcd 服务器证书以及私钥的目录

mkdir /opt/k8s/etcd-cert/

mv etcd-cert.sh etcd-cert/ #将etcd-cert.sh移动到该目录

cd /opt/k8s/etcd-cert/

./etcd-cert.sh #运行脚本生成CA证书、etcd 服务器证书以及私钥

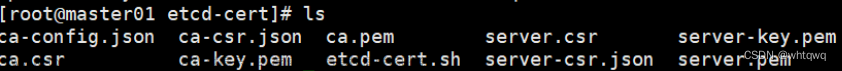

#查看etcd-cert目录,以.json和.csr结尾的文件都是请求生成证书的文件,以pem结尾的文件都是最终生成的证书文件。

ls

ca-config.json ca-csr.json ca.pem server.csr server-key.pem

ca.csr ca-key.pem etcd-cert.sh server-csr.json server.pem

#上传 etcd-v3.4.9-linux-amd64.tar.gz 到 /opt/k8s/ 目录中,启动etcd服务

#下载地址https://github.com/etcd-io/etcd/releases/download/v3.4.9/etcd-v3.4.9-1inux-amd64.tar.gz

cd /opt/k8s/

tar zxvf etcd-v3.4.9-linux-amd64.tar.gz

#查看安装包解压后的目录,该目录包含了etcd的启动文件etcd和etcd的管理文件etcdctl

cd /opt/k8s/etcd-v3.4.9-linux-amd64/

ls

--------------------------------------------------------------------------------

etcd:就是etcd服务的启动命令,后面可跟各种启动参数

etcdctl:主要为etcd服务提供了命令行操作

--------------------------------------------------------------------------------

#创建/opt/etcd目录,并创建三个子目录cfg、bin、ssl。cfg用于存放配置文件,bin用于存放执行文件,ssl用于存放证书文件

mkdir -p /opt/etcd/{cfg,bin,ssl}

#将etcd和etcdctl两个文件移动到/opt/etcd/bin目录

mv etcd etcdctl /opt/etcd/bin/

#将证书文件复制到etcd01节点的/opt/etcd/ssl/目录

cp /opt/k8s/etcd-cert/*.pem /opt/etcd/ssl/

cd /opt/k8s/

#运行脚本,会卡在前台

./etcd.sh etcd01 192.168.126.27 etcd02=https://192.168.126.28:2380,etcd03=https://192.168.126.29:2380

#另开一台终端,查看进程信息

ps -ef | grep etcd

#把etcd相关证书文件、命令文件和服务管理文件全部拷贝到另外两个etcd集群节点

scp -r /opt/etcd/ root@192.168.126.28:/opt/

scp -r /opt/etcd/ root@192.168.126.29:/opt/

#传输etcd的系统服务管理文件

scp /usr/lib/systemd/system/etcd.service root@192.168.126.28:/usr/lib/systemd/system/

scp /usr/lib/systemd/system/etcd.service root@192.168.126.29:/usr/lib/systemd/system/

2)在 node01 节点上操作(即etcd02)

vim /opt/etcd/cfg/etcd

#[Member]

ETCD_NAME="etcd02" #修改

ETCD_DATA_DIR="/var/lib/etcd/default.etcd"

ETCD_LISTEN_PEER_URLS="https://192.168.126.28:2380" #修改

ETCD_LISTEN_CLIENT_URLS="https://192.168.126.28:2379" #修改

#[Clustering]

ETCD_INITIAL_ADVERTISE_PEER_URLS="https://192.168.126.28:2380" #修改

ETCD_ADVERTISE_CLIENT_URLS="https://192.168.126.28:2379" #修改

ETCD_INITIAL_CLUSTER="etcd01=https://192.168.126.27:2380,etcd02=https://192.168.126.28:2380,etcd03=https://192.168.126.29:2380"

ETCD_INITIAL_CLUSTER_TOKEN="etcd-cluster"

ETCD_INITIAL_CLUSTER_STATE="new"

#启动etcd服务

systemctl start etcd

systemctl enable etcd

systemctl status etcd3)在 node02 节点上操作(即etcd03)

vim /opt/etcd/cfg/etcd

#[Member]

ETCD_NAME="etcd03" #修改

ETCD_DATA_DIR="/var/lib/etcd/default.etcd"

ETCD_LISTEN_PEER_URLS="https://192.168.126.29:2380" #修改

ETCD_LISTEN_CLIENT_URLS="https://192.168.126.29:2379" #修改

#[Clustering]

ETCD_INITIAL_ADVERTISE_PEER_URLS="https://192.168.126.29:2380" #修改

ETCD_ADVERTISE_CLIENT_URLS="https://192.168.126.29:2379" #修改

ETCD_INITIAL_CLUSTER="etcd01=https://192.168.126.27:2380,etcd02=https://192.168.126.28:2380,etcd03=https://192.168.126.29:2380"

ETCD_INITIAL_CLUSTER_TOKEN="etcd-cluster"

ETCD_INITIAL_CLUSTER_STATE="new"

#启动etcd服务

systemctl start etcd

systemctl enable etcd

systemctl status etcd4)检查etcd群集状态

#三个etcd节点都可用查看

#切换到/opt/etcd/ssl目录,证书可使用相对路径。如果不在该目录下,证书要使用绝对路径。

#查看etcd集群每个节点的健康状态,true表示健康

ETCDCTL_API=3 /opt/etcd/bin/etcdctl --cacert=/opt/etcd/ssl/ca.pem --cert=/opt/etcd/ssl/server.pem --key=/opt/etcd/ssl/server-key.pem --endpoints="https://192.168.126.27:2379,https://192.168.126.28:2379,https://192.168.126.29:2379" endpoint health --write-out=table

#查看etcd集群成员列表

ETCDCTL_API=3 /opt/etcd/bin/etcdctl --cacert=/opt/etcd/ssl/ca.pem --cert=/opt/etcd/ssl/server.pem --key=/opt/etcd/ssl/server-key.pem --endpoints="https://192.168.126.27:2379,https://192.168.126.28:2379,https://192.168.126.29:2379" --write-out=table member list

#查看etcd集群中哪个节点是leader,true表示leader

ETCDCTL_API=3 /opt/etcd/bin/etcdctl --endpoints="https://192.168.126.27:2379,https://192.168.126.28:2379,https://192.168.126.29:2379" --cacert=/opt/etcd/ssl/ca.pem --cert=/opt/etcd/ssl/server.pem --key=/opt/etcd/ssl/server-key.pem --write-out=table endpoint status

+-----------------------------+------------------+---------+---------+-----------+------------+-----------+------------+--------------------+--------+

| ENDPOINT | ID | VERSION | DB SIZE | IS LEADER | IS LEARNER | RAFT TERM | RAFT INDEX | RAFT APPLIED INDEX | ERRORS |

+-----------------------------+------------------+---------+---------+-----------+------------+-----------+------------+--------------------+--------+

| https://192.168.126.27:2379 | 66f49acac6299436 | 3.4.26 | 20 kB | true | false | 612 | 9 | 9 | |

| https://192.168.126.28:2379 | ebea4d5f7d427778 | 3.4.26 | 20 kB | false | false | 612 | 9 | 9 | |

| https://192.168.126.29:2379 | 1bbea197f31c6d0d | 3.4.26 | 20 kB | false | false | 612 | 9 | 9 | |

+-----------------------------+------------------+---------+---------+-----------+------------+-----------+------------+--------------------+--------+

#------------------注释---------------------------------------

--cert-file:识别HTTPS端使用SSL证书文件

--key-file:使用此SSL密钥文件标识HTTPS客户端

--ca-file:使用此CA证书验证启用https的服务器的证书

--endpoints:集群中以逗号分隔的机器地址列表

cluster-health:检查etcd集群的运行状况etcd备份与恢复

#备份etcd,打快照,放在/root/etcd-snapshot.db

ETCDCTL_API=3 /opt/etcd/bin/etcdctl --endpoints="https://192.168.126.27:2379" --cacert=/opt/etcd/ssl/ca.pem --cert=/opt/etcd/ssl/server.pem --key=/opt/etcd/ssl/server-key.pem snapshot save /root/etcd-snapshot.db

#恢复etcd

1.查看恢复文件

ETCDCTL_API=3 /opt/etcd/bin/etcdctl --endpoints="https://192.168.126.27:2379" --cacert=/opt/etcd/ssl/ca.pem --cert=/opt/etcd/ssl/server.pem --key=/opt/etcd/ssl/server-key.pem snapshot status ./etcd-snapshot.db --write-out=table

+----------+----------+------------+------------+

| HASH | REVISION | TOTAL KEYS | TOTAL SIZE |

+----------+----------+------------+------------+

| b545df08 | 0 | 5 | 20 kB |

+----------+----------+------------+------------+

2.恢复

ETCDCTL_API=3 /opt/etcd/bin/etcdctl --endpoints="https://192.168.126.27:2379" --cacert=/opt/etcd/ssl/ca.pem --cert=/opt/etcd/ssl/server.pem --key=/opt/etcd/ssl/server-key.pem snapshot restore ./etcd-snapshot.db3.部署 Master 组件

master01:192.168.126.27文章来源:https://www.toymoban.com/news/detail-495093.html

#在 master01 节点上操作,因为master01和etcd01部署在同一台机器上,所以/opt/k8s/目录已存在。

#上传 master.zip 和 k8s-cert.sh 到 /opt/k8s 目录中,解压 master.zip 压缩包

cd /opt/k8s/

unzip master.zip

chmod +x *.sh #为所有脚本文件加上执行权限

#创建kubernetes工作目录

mkdir -p /opt/kubernetes/{bin,cfg,ssl,logs}

#创建用于生成CA证书、相关组件的证书和私钥的目录

mkdir /opt/k8s/k8s-cert/

mv /opt/k8s/k8s-cert.sh /opt/k8s/k8s-cert/ #将k8s-cert.sh脚本移动到该目录

cd /opt/k8s/k8s-cert/ #切换到该目录

vim k8s-cert.sh #修改里面的ip地址

chmod +x k8s-cert.sh

./k8s-cert.sh #运行脚本,生成CA证书、相关组件的证书和私钥

#查看生成的证书文件

ls *pem

admin-key.pem apiserver-key.pem ca-key.pem kube-proxy-key.pem

admin.pem apiserver.pem ca.pem kube-proxy.pem

#复制CA证书、apiserver相关证书和私钥到kubernetes工作目录的ssl子目录中

cp ca*pem apiserver*pem /opt/kubernetes/ssl/

#上传 kubernetes-server-linux-amd64.tar.gz 到 /opt/k8s/ 目录中,解压 kubernetes 压缩包。

#下载地址: https://github.com/kubernetes/kubernetes/blob/release-1.20/CHANGELOG/CHANGELOG-1.20.nd

#注:打开链接你会发现里面有很多包,下载一个server包就够了,包含了Master和Worker Node二进制文件。

cd /opt/k8s/

tar xf kubernetes-server-linux-amd64.tar.gz

#复制master组件的关键命令文件到kubernetes工作目录的bin子目录中

cd /opt/k8s/kubernetes/server/bin

cp kube-apiserver kubectl kube-controller-manager kube-scheduler /opt/kubernetes/bin/

ln -s /opt/kubernetes/bin/* /usr/local/bin/ #创建软链接,方便系统识别命令

#创建 bootstrap token 认证文件,apiserver 启动时会调用,然后就相当于在集群内创建了一个这个用户,接下来就可以用 RBAC 给他授权

cd /opt/k8s/

vim token.sh

#!/bin/bash

#获取随机数前16个字节内容,以十六进制格式输出,并删除其中空格

BOOTSTRAP_TOKEN=$(head -c 16 /dev/urandom | od -An -t x | tr -d ' ')

#生成 token.csv 文件,按照 Token序列号,用户名,UID,用户组 的格式生成

cat > /opt/kubernetes/cfg/token.csv <<EOF

${BOOTSTRAP_TOKEN},kubelet-bootstrap,10001,"system:kubelet-bootstrap"

EOF

chmod +x token.sh #为脚本增加执行权限

./token.sh #运行脚本

cat /opt/kubernetes/cfg/token.csv

#二进制文件、token、证书都准备好后,开启apiserver服务,和etcd进行对接。

cd /opt/k8s/

#脚本后面跟master01的IP,以及etcd集群的地址和端口

./apiserver.sh 192.168.126.27 https://192.168.126.27:2379,https://192.168.126.28:2379,https://192.168.126.29:2379

#检查进程是否启动成功

ps aux | grep kube-apiserver

netstat -natp | grep 6443 #安全端口6443用于接收HTTPS请求,用于基于Token文件或客户端证书等认证

#启动 scheduler 服务

cd /opt/k8s/

vim scheduler.sh #查看ip地址是否正确

./scheduler.sh

ps aux | grep kube-scheduler

#启动 controller-manager 服务

vim controller-manager.sh #查看ip地址是否正确

./controller-manager.sh

ps aux | grep kube-controller-manager

#生成kubectl连接集群的kubeconfig文件,即令kubectl对接apiserver

vim admin.sh #查看ip地址是否正确

./admin.sh

#绑定默认cluster-admin管理员集群角色,授权kubectl访问集群

kubectl create clusterrolebinding cluster-system-anonymous --clusterrole=cluster-admin --user=system:anonymous

#通过kubectl工具查看当前集群组件状态

kubectl get cs

NAME STATUS MESSAGE ERROR

controller-manager Healthy ok

scheduler Healthy ok

etcd-2 Healthy {"health":"true"}

etcd-1 Healthy {"health":"true"}

etcd-0 Healthy {"health":"true"}

#查看版本信息

kubectl version注:k8s-cert.sh脚本

#!/bin/bash

#配置证书生成策略,让 CA 软件知道颁发有什么功能的证书,生成用来签发其他组件证书的根证书

cat > ca-config.json <<EOF

{

"signing": {

"default": {

"expiry": "87600h"

},

"profiles": {

"kubernetes": {

"expiry": "87600h",

"usages": [

"signing",

"key encipherment",

"server auth",

"client auth"

]

}

}

}

}

EOF

#生成CA证书和私钥(根证书和私钥)

cat > ca-csr.json <<EOF

{

"CN": "kubernetes",

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"L": "Beijing",

"ST": "Beijing",

"O": "k8s",

"OU": "System"

}

]

}

EOF

cfssl gencert -initca ca-csr.json | cfssljson -bare ca -

#-----------------------

#生成 apiserver 的证书和私钥(apiserver和其它k8s组件通信使用)

#hosts中将所有可能作为 apiserver 的 ip 添加进去,后面 keepalived 使用的VIP 也要加入

cat > apiserver-csr.json <<EOF

{

"CN": "kubernetes",

"hosts": [

"10.0.0.1",

"127.0.0.1",

"192.168.126.27", #master01。使用脚本时,要将这5行注释删除

"192.168.126.21", #master02

"192.168.126.88", #vip,后面keepalived要用到

"192.168.126.22", #负载均衡器01(master)

"192.168.126.23", #负载均衡器02(backup)

"kubernetes",

"kubernetes.default",

"kubernetes.default.svc",

"kubernetes.default.svc.cluster",

"kubernetes.default.svc.cluster.local"

],

"key": {

"algo": "rsa",

"size": 2048

},

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"L": "BeiJing",

"ST": "BeiJing",

"O": "k8s",

"OU": "System"

}

]

}

EOF

cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=kubernetes apiserver-csr.json | cfssljson -bare apiserver

#-----------------------

#生成 kubectl 连接集群的证书和私钥,具有admin权限

cat > admin-csr.json <<EOF

{

"CN": "admin",

"hosts": [],

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"L": "BeiJing",

"ST": "BeiJing",

"O": "system:masters",

"OU": "System"

}

]

}

EOF

cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=kubernetes admin-csr.json | cfssljson -bare admin

#-----------------------

#生成 kube-proxy 的证书和私钥

cat > kube-proxy-csr.json <<EOF

{

"CN": "system:kube-proxy",

"hosts": [],

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"L": "BeiJing",

"ST": "BeiJing",

"O": "k8s",

"OU": "System"

}

]

}

EOF

cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=kubernetes kube-proxy-csr.json | cfssljson -bare kube-proxy

apiserver.sh脚本

#!/bin/bash

#example: apiserver.sh 192.168.126.27 https://192.168.126.27:2379,https://192.168.126.28:2379,https://192.168.126.29:2379

#创建 kube-apiserver 启动参数配置文件

MASTER_ADDRESS=$1

ETCD_SERVERS=$2

cat >/opt/kubernetes/cfg/kube-apiserver <<EOF

KUBE_APISERVER_OPTS="--logtostderr=false \

--v=2 \

--log-dir=/opt/kubernetes/logs \

--etcd-servers=${ETCD_SERVERS} \

--bind-address=${MASTER_ADDRESS} \

--secure-port=6443 \

--advertise-address=${MASTER_ADDRESS} \

--allow-privileged=true \

--service-cluster-ip-range=10.0.0.0/24 \

--enable-admission-plugins=NamespaceLifecycle,LimitRanger,ServiceAccount,ResourceQuota,NodeRestriction \

--authorization-mode=RBAC,Node \

--enable-bootstrap-token-auth=true \

--token-auth-file=/opt/kubernetes/cfg/token.csv \

--service-node-port-range=30000-50000 \

--kubelet-client-certificate=/opt/kubernetes/ssl/apiserver.pem \

--kubelet-client-key=/opt/kubernetes/ssl/apiserver-key.pem \

--tls-cert-file=/opt/kubernetes/ssl/apiserver.pem \

--tls-private-key-file=/opt/kubernetes/ssl/apiserver-key.pem \

--client-ca-file=/opt/kubernetes/ssl/ca.pem \

--service-account-key-file=/opt/kubernetes/ssl/ca-key.pem \

--service-account-issuer=api \

--service-account-signing-key-file=/opt/kubernetes/ssl/apiserver-key.pem \

--etcd-cafile=/opt/k8s/etcd-cert/ca.pem \

--etcd-certfile=/opt/k8s/etcd-cert/server.pem \

--etcd-keyfile=/opt/k8s/etcd-cert/server-key.pem \

--requestheader-client-ca-file=/opt/kubernetes/ssl/ca.pem \

--proxy-client-cert-file=/opt/kubernetes/ssl/apiserver.pem \

--proxy-client-key-file=/opt/kubernetes/ssl/apiserver-key.pem \

--requestheader-allowed-names=kubernetes \

--requestheader-extra-headers-prefix=X-Remote-Extra- \

--requestheader-group-headers=X-Remote-Group \

--requestheader-username-headers=X-Remote-User \

--enable-aggregator-routing=true \

--audit-log-maxage=30 \

--audit-log-maxbackup=3 \

--audit-log-maxsize=100 \

--audit-log-path=/opt/kubernetes/logs/k8s-audit.log"

EOF

#--logtostderr=true:启用日志。输出日志到标准错误控制台,不输出到文件

#--v=4:日志等级。指定输出日志的级别,v=4为调试级别详细输出

#--etcd-servers:etcd集群地址。指定etcd服务器列表(格式://ip:port),逗号分隔

#--bind-address:监听地址。指定 HTTPS 安全接口的监听地址,默认值0.0.0.0

#--secure-port:https安全端口。指定 HTTPS 安全接口的监听端口,默认值6443

#--advertise-address:集群通告地址。通过该 ip 地址向集群其他节点公布 api server 的信息,必须能够被其他节点访问

#--allow-privileged=true:启用授权。允许拥有系统特权的容器运行,默认值false

#--service-cluster-ip-range:Service虚拟IP地址段。指定 Service Cluster IP 地址段

#--enable-admission-plugins:准入控制模块。kuberneres集群的准入控制机制,各控制模块以>插件的形式依次生效,集群时必须包含ServiceAccount,运行在认证(Authentication)、授权(Authorization)之后,Admission Control是权限认证链上的最后一环, 对请求API资源对象进行修改和校验

#--authorization-mode:认证授权,启用RBAC授权和节点自管理。在安全端口使用RBAC,Node授权模式,未通过授权的请求拒绝,默认值AlwaysAllow。RBAC是用户通过角色与权限进行关联的模式>;Node模式(节点授权)是一种特殊用途的授权模式,专门授权由kubelet发出的API请求,在进行认证时,先通过用户名、用户分组验证是否是集群中的Node节点,只有是Node节点的请求才能使用Node模式授权

#--enable-bootstrap-token-auth:启用TLS bootstrap机制。在apiserver上启用Bootstrap Token 认证

#--token-auth-file=/opt/kubernetes/cfg/token.csv:指定bootstrap token认证文件路径

#--service-node-port-range:指定 Service NodePort 的端口范围,默认值30000-32767

#–-kubelet-client-xxx:apiserver访问kubelet客户端证书

#--tls-xxx-file:apiserver https证书

#1.20版本必须加的参数:–-service-account-issuer,–-service-account-signing-key-file

#--etcd-xxxfile:连接Etcd集群证书

#–-audit-log-xxx:审计日志

#启动聚合层相关配置:–requestheader-client-ca-file,–proxy-client-cert-file,–proxy-client-key-file,–requestheader-allowed-names,–requestheader-extra-headers-prefix,–requestheader-group-headers,–requestheader-username-headers,–enable-aggregator-routing

#创建 kube-apiserver.service 服务管理文件

cat >/usr/lib/systemd/system/kube-apiserver.service <<EOF

[Unit]

Description=Kubernetes API Server

Documentation=https://github.com/kubernetes/kubernetes

[Service]

EnvironmentFile=-/opt/kubernetes/cfg/kube-apiserver

ExecStart=/opt/kubernetes/bin/kube-apiserver $KUBE_APISERVER_OPTS

Restart=on-failure

[Install]

WantedBy=multi-user.target

EOF

systemctl daemon-reload

systemctl enable kube-apiserver

systemctl restart kube-apiserverscheduler.sh脚本

#!/bin/bash

##创建 kube-scheduler 启动参数配置文件

MASTER_ADDRESS=$1

cat >/opt/kubernetes/cfg/kube-scheduler <<EOF

KUBE_SCHEDULER_OPTS="--logtostderr=false \

--v=2 \

--log-dir=/opt/kubernetes/logs \

--leader-elect=true \

--kubeconfig=/opt/kubernetes/cfg/kube-scheduler.kubeconfig \

--bind-address=127.0.0.1"

EOF

#-–kubeconfig:连接 apiserver 用的配置文件,用于识别 k8s 集群

#--leader-elect=true:当该组件启动多个时,自动启动 leader 选举

#k8s中Controller-Manager和Scheduler的选主逻辑:k8s中的etcd是整个集群所有状态信>息的存储,涉及数据的读写和多个etcd之间数据的同步,对数据的一致性要求严格,所以>使用较复杂的 raft 算法来选择用于提交数据的主节点。而 apiserver 作为集群入口,本身是无状态的web服务器,多个 apiserver 服务之间直接负载请求并不需要做选主。Controller-Manager 和 Scheduler 作为任务类型的组件,比如 controller-manager 内置的 k8s 各种资源对象的控制器实时的 watch apiserver 获取对象最新的变化事件做期望状态>和实际状态调整,调度器watch未绑定节点的pod做节点选择,显然多个这些任务同时工作>是完全没有必要的,所以 controller-manager 和 scheduler 也是需要选主的,但是选主逻辑和 etcd 不一样的,这里只需要保证从多个 controller-manager 和 scheduler 之间选出一个 leader 进入工作状态即可,而无需考虑它们之间的数据一致和同步。

##生成kube-scheduler证书

cd /opt/k8s/k8s-cert/

#创建证书请求文件

cat > kube-scheduler-csr.json << EOF

{

"CN": "system:kube-scheduler",

"hosts": [],

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"L": "BeiJing",

"ST": "BeiJing",

"O": "system:masters",

"OU": "System"

}

]

}

EOF

#生成证书

cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=kubernetes kube-scheduler-csr.json | cfssljson -bare kube-scheduler

#生成kubeconfig文件

KUBE_CONFIG="/opt/kubernetes/cfg/kube-scheduler.kubeconfig"

KUBE_APISERVER="https://192.168.126.27:6443" #master01的IP

kubectl config set-cluster kubernetes \

--certificate-authority=/opt/kubernetes/ssl/ca.pem \

--embed-certs=true \

--server=${KUBE_APISERVER} \

--kubeconfig=${KUBE_CONFIG}

kubectl config set-credentials kube-scheduler \

--client-certificate=./kube-scheduler.pem \

--client-key=./kube-scheduler-key.pem \

--embed-certs=true \

--kubeconfig=${KUBE_CONFIG}

kubectl config set-context default \

--cluster=kubernetes \

--user=kube-scheduler \

--kubeconfig=${KUBE_CONFIG}

kubectl config use-context default --kubeconfig=${KUBE_CONFIG}

##创建 kube-scheduler.service 服务管理文件

cat >/usr/lib/systemd/system/kube-scheduler.service <<EOF

[Unit]

Description=Kubernetes Scheduler

Documentation=https://github.com/kubernetes/kubernetes

[Service]

EnvironmentFile=-/opt/kubernetes/cfg/kube-scheduler

ExecStart=/opt/kubernetes/bin/kube-scheduler $KUBE_SCHEDULER_OPTS

Restart=on-failure

[Install]

WantedBy=multi-user.target

EOF

systemctl daemon-reload

systemctl enable kube-scheduler

systemctl restart kube-schedulercontroller-manager.sh脚本

#!/bin/bash

##创建 kube-controller-manager 启动参数配置文件

MASTER_ADDRESS=$1

cat >/opt/kubernetes/cfg/kube-controller-manager <<EOF

KUBE_CONTROLLER_MANAGER_OPTS="--logtostderr=false \

--v=2 \

--log-dir=/opt/kubernetes/logs \

--leader-elect=true \

--kubeconfig=/opt/kubernetes/cfg/kube-controller-manager.kubeconfig \

--bind-address=127.0.0.1 \

--allocate-node-cidrs=true \

--cluster-cidr=10.244.0.0/16 \

--service-cluster-ip-range=10.0.0.0/24 \

--cluster-signing-cert-file=/opt/kubernetes/ssl/ca.pem \

--cluster-signing-key-file=/opt/kubernetes/ssl/ca-key.pem \

--root-ca-file=/opt/kubernetes/ssl/ca.pem \

--service-account-private-key-file=/opt/kubernetes/ssl/ca-key.pem \

--cluster-signing-duration=87600h0m0s"

EOF

#––leader-elect:当该组件启动多个时,自动选举(HA)

#-–kubeconfig:连接 apiserver 用的配置文件,用于识别 k8s 集群

#--cluster-cidr=10.244.0.0/16:pod资源的网段,需与pod网络插件的值设置一致。通常,Flannel网络插件的默认为10.244.0.0/16,Calico插件的默认值为192.168.0.0/16

#--cluster-signing-cert-file/–-cluster-signing-key-file:自动为kubelet颁发证书>的CA,与apiserver保持一致。指定签名的CA机构根证书,用来签名为 TLS BootStrapping 创建的证书和私钥

#--root-ca-file:指定根CA证书文件路径,用来对 kube-apiserver 证书进行校验,指定该参数后,才会在 Pod 容器的 ServiceAccount 中放置该 CA 证书文件

#--experimental-cluster-signing-duration:设置为 TLS BootStrapping 签署的证书有效时间为10年,默认为1年

##生成kube-controller-manager证书

cd /opt/k8s/k8s-cert/

#创建证书请求文件

cat > kube-controller-manager-csr.json << EOF

{

"CN": "system:kube-controller-manager",

"hosts": [],

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"L": "BeiJing",

"ST": "BeiJing",

"O": "system:masters",

"OU": "System"

}

]

}

EOF

#生成证书

cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=kubernetes kube-controller-manager-csr.json | cfssljson -bare kube-controller-manager

#生成kubeconfig文件

KUBE_CONFIG="/opt/kubernetes/cfg/kube-controller-manager.kubeconfig"

KUBE_APISERVER="https://192.168.126.27:6443" #master01的IP

kubectl config set-cluster kubernetes \

--certificate-authority=/opt/kubernetes/ssl/ca.pem \

--embed-certs=true \

--server=${KUBE_APISERVER} \

--kubeconfig=${KUBE_CONFIG}

kubectl config set-credentials kube-controller-manager \

--client-certificate=./kube-controller-manager.pem \

--client-key=./kube-controller-manager-key.pem \

--embed-certs=true \

--kubeconfig=${KUBE_CONFIG}

kubectl config set-context default \

--cluster=kubernetes \

--user=kube-controller-manager \

--kubeconfig=${KUBE_CONFIG}

kubectl config use-context default --kubeconfig=${KUBE_CONFIG}

##创建 kube-controller-manager.service 服务管理文件

cat >/usr/lib/systemd/system/kube-controller-manager.service <<EOF

[Unit]

Description=Kubernetes Controller Manager

Documentation=https://github.com/kubernetes/kubernetes

[Service]

EnvironmentFile=-/opt/kubernetes/cfg/kube-controller-manager

ExecStart=/opt/kubernetes/bin/kube-controller-manager $KUBE_CONTROLLER_MANAGER_OPTS

Restart=on-failure

[Install]

WantedBy=multi-user.target

EOF

systemctl daemon-reload

systemctl enable kube-controller-manager

systemctl restart kube-controller-manageradmin.sh

#!/bin/bash

mkdir /root/.kube

KUBE_CONFIG="/root/.kube/config"

KUBE_APISERVER="https://192.168.126.27:6443" #master01的IP

cd /opt/k8s/k8s-cert/

kubectl config set-cluster kubernetes \

--certificate-authority=/opt/kubernetes/ssl/ca.pem \

--embed-certs=true \

--server=${KUBE_APISERVER} \

--kubeconfig=${KUBE_CONFIG}

kubectl config set-credentials cluster-admin \

--client-certificate=./admin.pem \

--client-key=./admin-key.pem \

--embed-certs=true \

--kubeconfig=${KUBE_CONFIG}

kubectl config set-context default \

--cluster=kubernetes \

--user=cluster-admin \

--kubeconfig=${KUBE_CONFIG}

kubectl config use-context default --kubeconfig=${KUBE_CONFIG}总结:

etcd数据库:

- 分布式键值对型的数据库,服务发现系统(之前的docker-consul 就是服务发现)

- go语言开发的,使用raft-a致性算法

- 部署集群时需要3台或以上的奇数台

- 2379 对外(客户端)通信的端口

- 2380 对内(集群内部节点间)通信的端口

etcd安装步骤:

- 使用CFSSL工具,生成ca证书和私钥文件,再使用ca签发服务端证书和私钥文件

- 使用ca证书、服务端证书和私钥文件加上etcd集群配置文件,去启动etcd服务

- 解压etcd软件包

- 复制etcd工作目录和服务管理文件到另外几个节点上,修改etcd集群配置文件并启动etcd服务

- 使用v3版本的接口执行etcdctl +证书选项+ (endpoint health | endpoint status | member list) 查看etcd 集群和节点状态

正常情况etcd应该生成三套证书:客户端证书,服务端证书,对等体证书(内部)。初学者可以先只生成两套。文章来源地址https://www.toymoban.com/news/detail-495093.html

master组件安装步骤:

1.先安装apiserver

- 准备组件的相关证书和私钥文件

- 准备bootstraptoken认证文件(给kubelet启动时签发证书时使用)

- 准备组件的启动配置文件

- 启动apiserver 服务、端口号、6443、https

2.再启动controller-manager 和scheduler

- 准备启动配置文件

- 准备证书和私钥文件生成kubeconfig 文件(用于指定对接哪个apiserver,使用什么证书认证)

- 启动服务

3.检查集群组件状态

- 需要准备kubeconfig 文件,把kubectl 加入到集群中( 指定对接哪个apiserver,使用什么证书认证)

- kubectl get cs

到了这里,关于二进制搭建Kubernetes集群(一)——部署etcd集群和单master的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[云原生案例2.1 ] Kubernetes的部署安装 【单master集群架构 ---- (二进制安装部署)】节点部分](https://imgs.yssmx.com/Uploads/2024/02/745445-1.png)