分词器介绍

ES作为全文检索服务,势必要对原始的文本进行内容的拆分,才能进行有效的索引。而拆分原始内容到一个一个小的词,或语义单元,这部分的功能由ES的分词器去完成的。

常见分词器

standard:ES默认的分词器,会将词汇单元进行小写形式,并且去除一些停用词和标点符号等等。支持中文,采用的方法为单字切分。

simple:该分词器首先通过非字母字符来分割文本信息,然后将词汇单元统一为小写形式。该分词器会去除掉数字类型的一些字符。

whitespace:仅仅是去除空格,然后对字符没有任何的小写化,并且该分词器不支持中文,而且它对生成的词汇单元没有作其他的一些标准化的处理。

language:特定语言的分词器,目前该分词器也是不支持中文的。

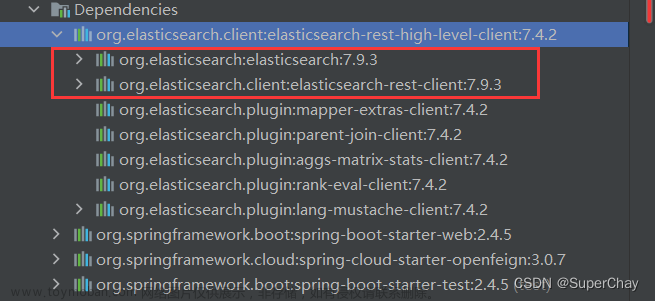

IK分词器的安装和使用

IK分词器是目前ES开源社区对于中文分词支持最好的第三方的插件。文章来源:https://www.toymoban.com/news/detail-495161.html

首先,我们下载IK分词器插件。

IK分词器github地址为:

https://github.com/medcl/elasticsearch-analysis-ik

点击右下角releases

然后找到ES对应的版本,点击Assets,然后点击下载zip包。

下载完之后解压到elasticsearch-6.8.23\plugins\目录下

然后重启ES,IK分词器才会生效。

IK分词器插件默认提供了两种分词器:

ik_smart

ik_max_word

那么,为什么IK分词器对于中文有如此本地化的理解呢,原因是IK分词器内置了很多字典。

如果某个词没被分词成功,则在字典里添加重启即可。

文章来源地址https://www.toymoban.com/news/detail-495161.html

文章来源地址https://www.toymoban.com/news/detail-495161.html

到了这里,关于Java项目(二)--Springboot + ElasticSearch 构建博客检索系统(3)- 分词器介绍的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!