作为 Meta 对开放科学承诺的一部分,今天我们将公开发布

LLaMA (大型语言模型 Meta AI) ,这是一个最先进的大型语言基础模型,旨在帮助研究人员推进他们在人工智能这一子领域的工作。更小,更高性能的模型,例如 LLaMA,使得研究社区中没有大量基础设施的其他人能够研究这些模型,进一步民主化这个重要的,快速变化的领域的访问。

在大型语言模型空间中,训练像LLaMA这样的较小基础模型是可取的,因为它需要更少的计算能力和资源来测试新方法、验证他人的工作和探索新的用例。基础模型在大量未标记的数据上进行训练,这使它们非常适合于各种任务的微调。我们正在提供多种尺寸的LLaMA(7B、13B、33B和65B参数),并共享LLaMA模型卡,详细说明我们如何根据负责任的人工智能实践方法构建模型。

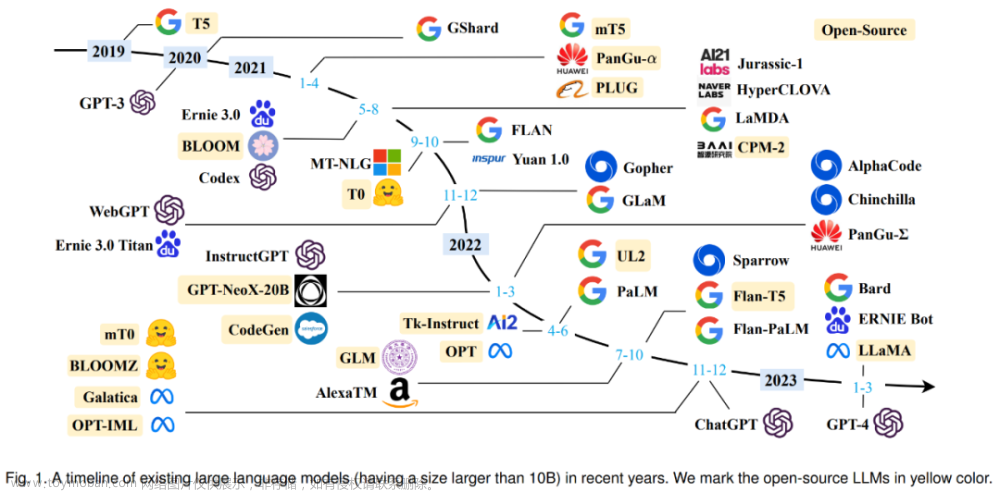

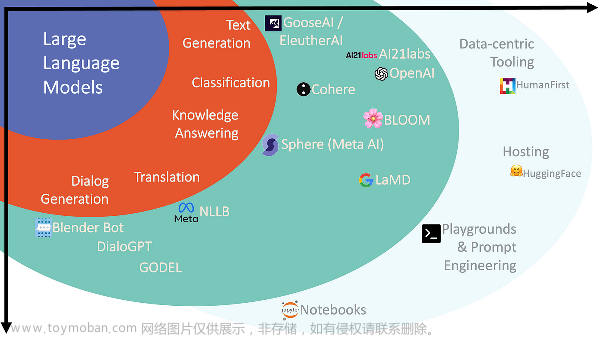

在过去的一年中,大型语言模型(具有数十亿个参数的自然语言处理(NLP)系统)显示出了新的功能来生成创意文本,求解数学定理,预测蛋白质结构,回答阅读理解的问题等。它们是AI可以向数十亿人提供的巨大潜在利益的最明显案例之一。

即使在大型语言模型中的所有最新进步中,对它们的全面研究访问仍然有限,因为训练和运行如此大型模型所需的资源。这种限制的访问具有有限的研究人员了解这些大语言模型如何以及为何工作的能力,阻碍了改善其稳健性和减轻已知问题的努力的进展,例如偏见,有害信息以及产生错误信息的潜力。

较小的模型可以训练更多的tokens(即单词片段) ,因此更容易针对特定的潜在产品用例进行再训练和微调。我们对 LLaMA 65B 和 LLaMA 33B 进行了1.4万亿tokens的训练。我们最小的模型 LLaMA 7B 是在一万亿tokens上训练的。

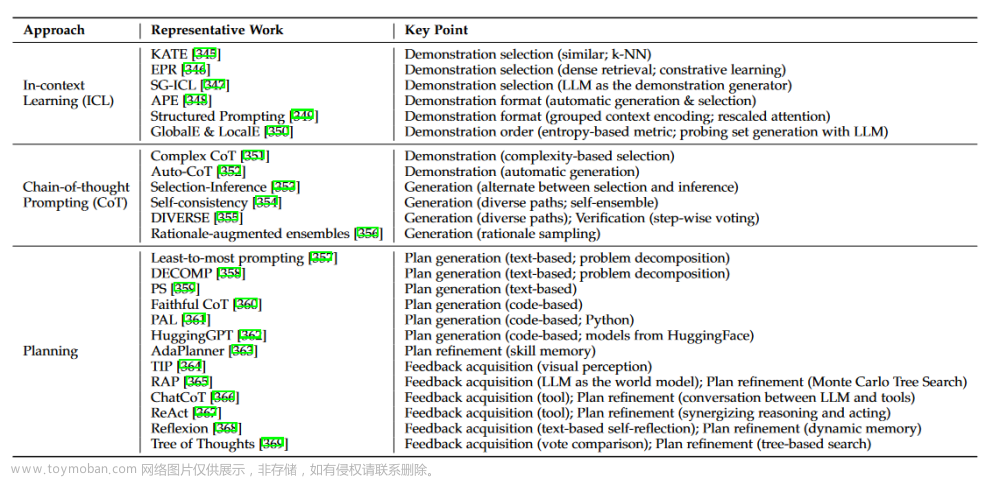

与其他大型语言模型一样,**LLaMA的工作原理是将一系列单词作为输入,并预测下一个单词以递归生成文本。**为了训练我们的模型,我们从20种使用者最多的语言中选择了文本,重点是那些使用拉丁字母和西里尔字母的语言。

还有更多的研究需要做,以解决大型语言模型中存在偏见、有毒评论和幻觉的风险。与其他模型一样,LLaMA也面临这些挑战。作为一个基础模型,LLaMA被设计为通用的,可以应用于许多不同的用例,而不是为特定任务设计的微调模型。通过共享LLaMA的代码,其他研究人员可以更容易地测试在大型语言模型中限制或消除这些问题的新方法。我们还在论文中提供了一组关于评估模型偏差和毒性的基准的评估,以显示模型的局限性,并支持这一关键领域的进一步研究。

为了保持完整性和防止滥用,我们在非商业许可证下发布了我们的模型,重点是研究用例。学术研究人员将根据具体情况使用该模型;与政府、民间社会和学术界组织有关联的机构;以及世界各地的工业研究实验室。有兴趣申请访问权限的人可以在我们的研究论文中找到该应用程序的链接。

我们认为,整个人工智能社区——学术研究人员、民间社会、政策制定者和行业——必须共同努力,围绕负责任的人工智能,特别是负责任的大型语言模型,制定明确的指导方针。我们期待着看到社区可以使用LLaMA学习并最终建立什么。

Paper

摘要:我们介绍 LLaMA,一个从7B 到65B 参数的基础语言模型集合。我们在数以万亿计的令牌上训练我们的模型,并且展示了完全使用公开可用的数据集训练最先进的模型是可能的,而不需要求助于专有的和不可访问的数据集。特别是,LLaMA-13B 在大多数基准上优于 GPT-3(175B) ,而且 LLaMA-65B 与最好的机型 Chinchilla-70B 和 PaLM-540B 相比具有竞争力。我们把所有的模型发布给研究团体。

GitHub地址:https://github.com/facebookresearch/llama

Setup

文章来源:https://www.toymoban.com/news/detail-495923.html

文章来源:https://www.toymoban.com/news/detail-495923.html

其他资料

Apply for access to LLaMA文章来源地址https://www.toymoban.com/news/detail-495923.html

到了这里,关于【LLM】LLaMA简介:一个650亿参数的基础大型语言模型的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!