!

扩散模型(Stable Diffusion)现在是生成图像的首选模型。由于扩散模型允许我们以提示( prompts)为条件生成图像,我们可以生成我们所选择的图像。在这些文本条件的扩散模型中,稳定扩散模型由于其开源性而最为著名。

在这篇文章中,我们将把Stable Diffusion模型分解为构成它的各个组成部分。此外,我们还将了解稳定扩散的工作原理。

熟悉Stable Diffusion的工作,将使我们也能理解其训练和推理的过程。在了解了Stable Diffusion的概念部分之后,我们将介绍它的不同版本和变化。

1. Stable Diffusion介绍

Latent Diffusion Model (LDM)是最初的文本-图像模型,稳定扩散模型(Stable Diffusion)是一种扩展。这意味着 "Stable Diffusion "也是一个文本-图像模型。

CompVis和RunwayML的原始开放源代码是基于Rombach等人的论文–“High-Resolution Image Synthesis with Latent Diffusion Models”。

对扩散模型及其机制感到困惑吗?不要着急,本文将会使用PyTorch从头开始建立一个基本的扩散模型。

正如你现在可能已经猜到的,稳定扩散并不是唯一能生成图像的扩散模型。

在Stable Diffusion之前,有OpenAI的DALL-E 2。在这之后,谷歌发布了Imagen。这两个都是文本到图像的扩散模型。

这就提出了一个相关的问题–“稳定扩散与其他从提示语生成图像的扩散模型有何不同?”

1.1 Stable Diffusion与其他基于扩散的图像生成模型有何不同?

Stable Diffusion是在图像的潜在空间而不是在图像的像素空间工作的。

其他生成性扩散模型,如DALL-E 2和Imagen,在图像的像素空间上工作。这使得它们的速度变慢,而且在这个过程中,消耗了更多的内存。

自动编码器模型有助于创建这个潜在空间,它也作为模型中的噪声预测器。如果你看过之前的DDPM文章,那么你已经知道噪声预测器模型是LDM(潜伏扩散模型)中不可缺少的一部分。

在这一点上,我想到了另外几个问题。

- UNet是稳定扩散模型中的一个组成部分/模型吗?

- 该模型中还有其他组成部分吗?如果是的话,它们是什么?

2. Stable Diffusion模型的组成部分

我们可以将Stable Diffusion模型分解为三个主要部分:

- 一个预先训练好的文本编码器

- 一个UNet噪声预测器

- 一个可变的自动编码器-解码器模型。解码器还包含一个用于生成最终高分辨率图像的Upsampler网络。

但在训练和推理过程中,所有的组件都参与其中。在训练期间,使用编码器、UNet和预训练的文本编码器。而在推理过程中,预训练过的文本编码器、UNet和解码器都参与其中。

广义上讲,一个预训练的文本编码器将文本提示转换为embeddings。

UNet模型作为噪声预测器作用于潜在的空间信息。

自动编码器-解码器有两个任务。编码器从原始图像像素生成潜空间信息,解码器从文本条件的潜空间预测图像。

3. 训练 Stable Diffusion

训练Stable Diffusion模型包括三个阶段(抛开反向传播和所有数学上的东西):

- 根据prompt创建 token embeddings。从训练的角度来看,我们将文本prompt称为标题。

- 用embeddings对UNet进行调节。潜在空间是使用自动编码器模型的编码器部分生成的。这被称为文本条件的潜空间。

- UNet会在潜在空间上工作。

- 从上述步骤中,UNet预测了添加到潜空间的噪声,并试图对其进行去噪处理。

3.1 Text Encoder

一般来说,在所有的扩散模型中,Text Encoder是一个大型的预训练的transformer语言模型。

Stable Diffusion使用CLIP的预训练Text Encoder部分进行文本编码。它把提示词作为输入,并输出77×768维的 token embedding。

在77个tokens,75个是来自prompt的text tokens ,1个为start token,另外1个为end token。

其他预训练的语言transformers模型,如T5和BERT也可以使用。但 "Stable Diffusion "使用CLIP。

3.2 UNet噪声预测器

在UNet之前,autoencoder-decoder模型的编码器部分将输入图像转换为其潜在的表示。

现在,重要的是要记住,UNET只作用于编码后的latent 空间,根本不处理原始图像像素。当然,它是以文字提示为条件的。将文本提示添加到潜空间的过程被称为文本调节(text conditioning)。

不仅仅是文本调节(text conditioning), latent information也要经过一个噪音添加步骤,如上文所述。

从所有上述信息中,UNet试图预测添加到图像中的噪声。

但这还不是全部。UNet的架构比这更复杂。它包含了用于残差连接Residual layers和用于将文本信息合并到图像的潜在空间的Attention layers。

在合并merging步骤之后,残余块可以利用embedded信息去噪。

UNet输出一个64×64(空间)维度的张量。

3.3 Autoencoder-Decoder 模型

如前所述,Autoencoder的编码器encoder部分从原始图像中创建潜伏空间。

最后,该模型的解码器Decoder 部分负责生成最终图像。

解码器作用于4x64x64维的向量,生成3x512x512的图像。原始的Stable Diffusion(直到2.0版)默认生成512×512维的图像。

3.4 训练Stable Diffusion的完整过程

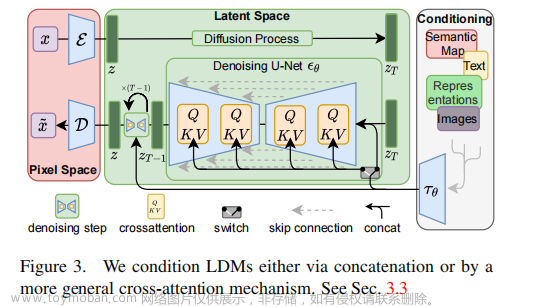

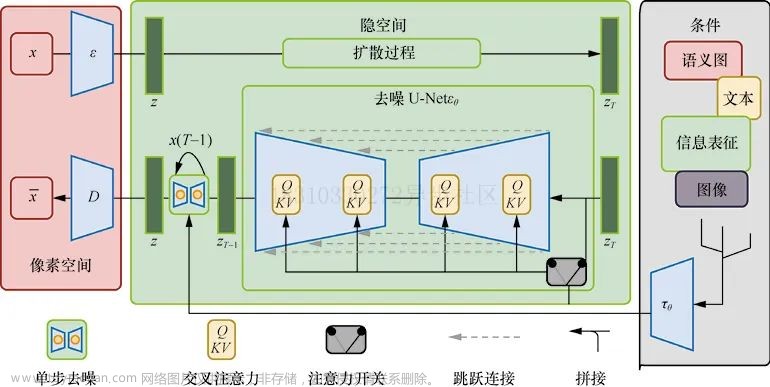

正如最初的LDM论文中所示,整个过程可以总结为以下图片。

我们可以看到,首先编码器是如何将图像编码到一个潜伏空间中的(上半部分右侧红色块)。并注意到我们如何用文本、语义图或甚至图像来调节潜空间。

QKV块代表了来自Transformer模型的交叉注意力。大的绿色块显示了UNet在潜空间上的工作,以预测噪音。

4 Stable Diffusion推理–从噪声和提示中生成图像

一旦我们有了训练好的Stable Diffusion模型,生成图像就会经历一个与训练稍有不同的过程。

在推理过程中,我们最初并没有图像。相反,我们必须使用text prompt来生成一个。此外,我们不需要自动autoencoder-decoder 网络的编码器部分。这就把推理部分归结为以下内容:

- 预训练的文本编码器text encoder。

- UNet噪声预测器。

- 以及autoencoder-decoder网络的解码器部分。

4.1 从prompt中生成图像的过程

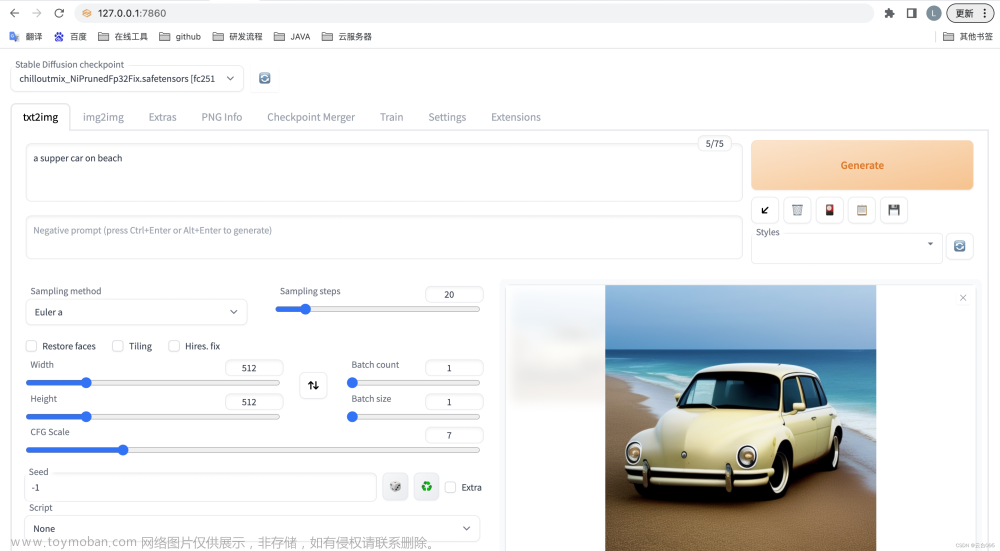

我们不向图像添加噪声,而是直接从纯高斯噪声开始。然后Stable Diffusion对其进行迭代去噪,生成最终的图像。我们可以控制去噪步骤的数量,这被称为采样步骤。

如果是一个纯扩散模型(不以文本提示为条件),那么这个过程将类似于以下情况:

但在这里,我们有一个文本提示text prompt,而噪音需要以文本提示为条件。因此,这个过程看起来像这样:

除了输入图像和编码器(我们不再需要了),其他每个组件都保持不变。

但是,我们在上面谈到了采样步骤。这在整个过程中是如何体现的呢?

这可以通过扩展UNet和展示去噪过程来更好地解释。

我们可以把上述过程称为反向扩散过程,因为该模型从噪声中生成了图像。

4.2 一些实际考虑的问题

下面是一些要点,以澄清关于推理阶段的几个概念:

- 输入的提示不需要完全是75个字的长度。我们也可以提供更短和更长的提示。

- 在推理过程中,UNet仍然会生成一个空间尺寸为64×64的图像。

- autoencoder的解码器部分既是一个上采样器,也是一个超分辨率模型的组合。这就产生了最终的512×512的图像。

- 从完全实用的角度来看,只要我们能负担得起GPU的内存,我们就可以生成任何分辨率的图像。

5. Stable Diffusion的不同版本

在这里,我们将讨论在众多的Stable Diffusion中一些比较显著的变化。

所有这些模型都是通过对基本的Stable Diffusion版本之一进行微调而得到的。

5.1 Arcane Diffusion

这种Stable Diffusion的变体在电视节目《Arcane》的图像上进行了微调。

在给模型提示的风格信息,就能生成对应风格的图像。

5.2 Robo Diffusion

Stable Diffusion的机器人扩散版本可以生成非常酷的机器人图像。

5.3 Open Journey

与基本的Stable Diffusion相比,这些图像更具艺术性和动态性。Openjourney模型已经在Midjourney的图像输出上进行了训练。

5.4 动漫效果

总结

在这篇文章中,我们介绍了稳定扩散的整个架构。除了训练和推理之外,我们还介绍了稳定扩散的实际应用效果。文章来源:https://www.toymoban.com/news/detail-496639.html

正如你从这篇文章中所理解的那样,开源模型(如Stable Diffusion)让AI社区扩大了使用范围。从非常简单的角色开始,到不同艺术风格的复杂角色,这些模型让我们探索我们的创造力。此外,微调这些模型所需的计算量正在减少。几乎任何拥有非常普通的消费级GPU的人都可以微调稳定扩散模型。文章来源地址https://www.toymoban.com/news/detail-496639.html

到了这里,关于Stable Diffusion-生式AI的新范式的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!