在计算机视觉中,梯度计算是一项关键任务,它在优化算法中扮演着重要的角色。梯度表示函数在某一点上的变化率,可以指导模型参数的更新,使得模型逐步接近最优解。下面我将详细解释梯度计算的作用、原理和意义。

作用:

梯度计算在计算机视觉中的作用主要有两个方面:

- 模型优化:通过计算损失函数对模型参数的梯度,可以使用梯度下降等优化算法来更新模型参数,使模型逐步逼近最优解。

- 反向传播:梯度计算是反向传播算法的基础,通过将梯度从输出层向输入层传播,可以有效地计算每个参数对损失函数的贡献,从而进行参数更新。

原理:

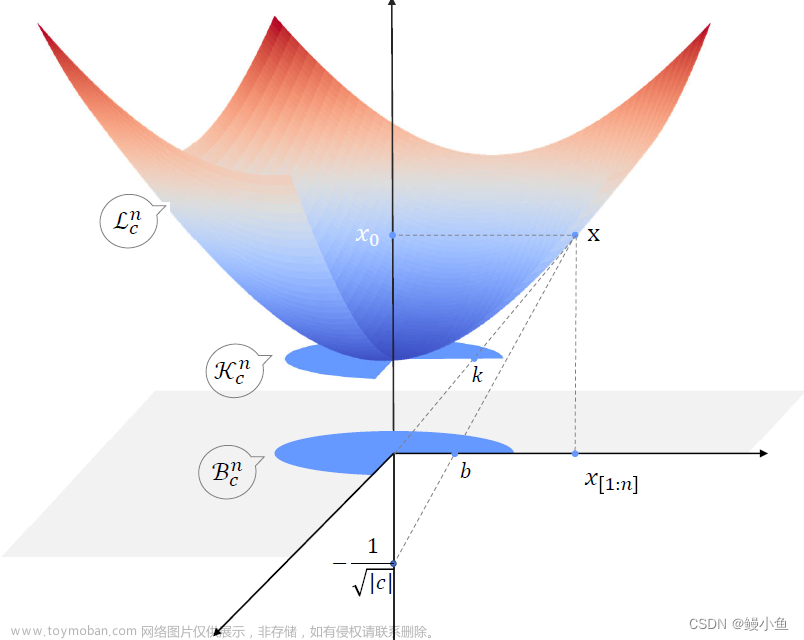

梯度的计算是基于导数的概念。对于一个函数

f

(

x

1

,

x

2

,

.

.

.

,

x

n

)

f(x_1, x_2, ..., x_n)

f(x1,x2,...,xn),它的梯度表示为

∇

f

=

(

∂

f

∂

x

1

,

∂

f

∂

x

2

,

.

.

.

,

∂

f

∂

x

n

)

\nabla f = \left(\frac{\partial f}{\partial x_1}, \frac{\partial f}{\partial x_2}, ..., \frac{\partial f}{\partial x_n}\right)

∇f=(∂x1∂f,∂x2∂f,...,∂xn∂f),其中

∂

f

∂

x

i

\frac{\partial f}{\partial x_i}

∂xi∂f 表示函数

f

f

f 对变量

x

i

x_i

xi 的偏导数。梯度向量的方向指示了函数在当前点上升最快的方向,反向指示了函数下降最快的方向。

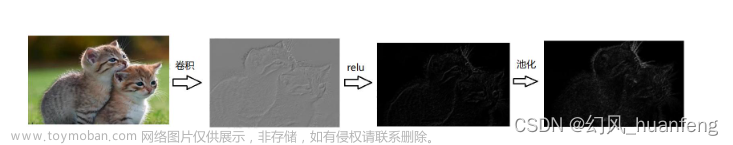

在计算机视觉中,梯度计算通常涉及对损失函数关于模型参数的偏导数的计算。通过链式法则,可以将整个模型分解为一系列函数的组合,然后计算每个函数对输入的偏导数,最终得到模型参数的梯度。

意义:

梯度计算的意义在于指导模型的参数更新,使模型朝着最优解的方向前进。通过计算梯度,可以确定模型参数的调整方向和幅度,从而优化模型的性能。梯度计算使得模型能够从数据中学习,逐渐提高预测准确性和泛化能力。

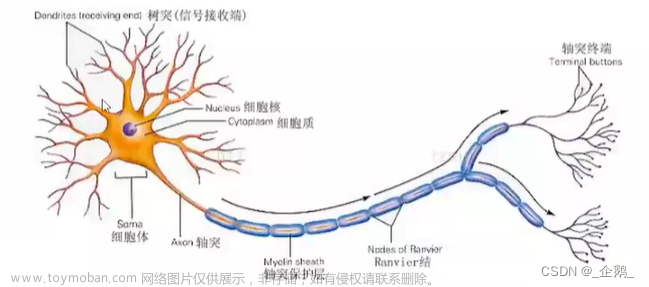

在实际应用中,梯度计算常用于训练神经网络等模型。通过计算损失函数对网络参数的梯度,可以使用梯度下降等优化算法来更新参数,使得网络能够逐步调整权重和偏置,以最小化损失函数并提高模型性能。数学角度上,梯度计算是通过对函数的偏导数进行求解,利用导数表示函数在各个方向上的变化率。通过计算损失函数关于模型参数的梯度,可以确定参数更新的方向和幅度,从而优化模型的参数。具体的数学公式和推导过程会涉及到具体的损失函数和模型结构,在不同的场景下可能有所不同。

常见的梯度计算方法主要包括数值梯度和解析梯度。下面我将逐个介绍它们的优缺点、适用场景、数学表达式和相应的PyTorch代码示例。

-

数值梯度(Numerical Gradient)

- 优点:简单易实现,适用于各种函数和模型。

- 缺点:计算量较大,梯度计算精度较低。

- 适用场景:用于验证解析梯度计算的正确性,或者在无法直接求解解析梯度时使用。

- 数学表达式:数值梯度的计算可以通过有限差分近似来实现,公式如下:

- PyTorch代码示例:

import torch def numerical_gradient(f, x, epsilon=1e-6): grad = torch.zeros_like(x) for i in range(x.size(0)): xi_plus = x.clone() xi_plus[i] += epsilon xi_minus = x.clone() xi_minus[i] -= epsilon grad[i] = (f(xi_plus) - f(xi_minus)) / (2 * epsilon) return grad

-

解析梯度(Analytical Gradient)文章来源:https://www.toymoban.com/news/detail-497645.html

- 优点:精确性高,计算效率高。

- 缺点:需要对函数或模型进行求导,可能需要一定的数学推导。

- 适用场景:适用于具有可导性质的函数和模型。

- 数学表达式:解析梯度通过对函数或模型的参数进行求导来计算梯度。

- PyTorch代码示例:在PyTorch中,可以通过定义模型和损失函数,然后使用

backward()函数进行自动求导,得到解析梯度。import torch import torch.nn as nn # 定义模型 model = nn.Linear(10, 1) # 定义损失函数 loss_fn = nn.MSELoss() # 输入数据 x = torch.randn(10) y = torch.randn(1) # 前向传播 y_pred = model(x) # 计算损失 loss = loss_fn(y_pred, y) # 梯度计算 model.zero_grad() loss.backward()

以上是常见的梯度计算方法,数值梯度和解析梯度都有各自的优缺点和适用场景。数值梯度适用于验证和测试梯度计算的正确性,或者在无法直接求解解析梯度时使用。解析梯度适用于具有可导性质的函数和模型,能够提供精确的梯度信息,进而优化模型的参数。在计算机视觉中,一般使用解析梯度来进行神经网络的训练和优化。文章来源地址https://www.toymoban.com/news/detail-497645.html

到了这里,关于神经网络:梯度计算的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!