- 认知语言学:认知科学(cognitive science)与语言学交 叉的一个研究分支,是研究人脑的思维、心智、智能、推理和认识等认知机理及其对语言进 行分析和理解过程的一门学问

- 语言认知计算模型:

- 刻画人脑语言认知和理解过程的形式化模型

- 目的:建立可计算的、复杂度可控的数学模型,以便在计算机系 统上实现对人脑语言理解过程的模拟

- 实现所谓的“类脑语言信息处理”

- 人脑处理语言的认知机理:通过采集分析在某种语言环境下人脑的生理数据,研究人脑对语音、词汇、句法 和语义的理解机理

- 语言处理过程至少涉及两种并行的过程:

- 语义记忆:负责检索单词间 的语义特征、关联和语义关系

- 语义组合:至少有一个通路 负责将单词整合形成更高级的含义

- 深度神经网络与自然语言处理:

- 在神经网络模型中融合记忆模块和注意力机制成为了研究的趋势

- 任务大多解决的是“处理”层面的问题,如 边界的切分、语音信号到文字的转换等,而上升到“语义理解”的层面还有太多的 问题,如正确理解一幅图像所包含的语义和情感等,仍是极具有挑战性的问题。

- 人类语言需结合一 定的上下文和知识才能理解

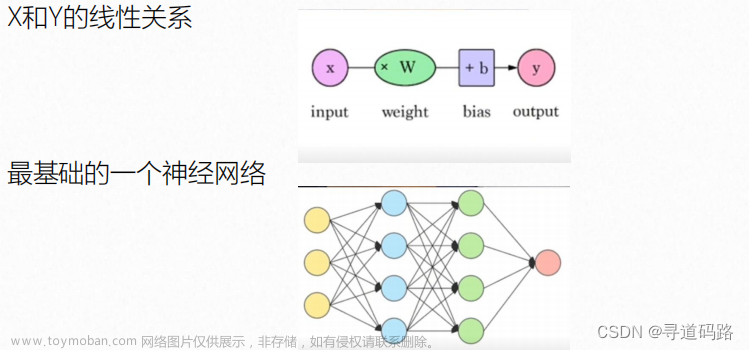

- 语言具有一定的层次结构,具体表现为 词、短语、句子、段落以及篇章等不同的语言粒度。为了让计算机可以理解语言,需要将不 同粒度的语言都转换成计算机可以处理的数据结构。

- 连续表示:

- 为了解决离散表示所无法解决的““一词多义”和“一义多词”问题

- 将语言单位表示为连续语义空间中的一个点,这样的表示方法称之为连续表示

- 基于连续表示,词与词之间 就可以通过欧式距离或余弦距离等方式来计算相似度

- 常用方法:

- 分布式表示:基于 Harris 的分布式假设,即如果两个词的上下文相似,那么这两个词也是相似的。

- 分散式表示(主流方法):

- 将语言的潜在语法或语义特征分散式地存储在一组神经元中,可以用稠密、低维、连续的向量来表示,也叫嵌入(Embeddings)。

- 一个好的词嵌入模型应该是:对于 相似的词,它们对应的词嵌入也相近

- 根据所表示文本的颗粒度的不同,可以分为词、句子、篇章的表示:

- 词表示:Word embeddings:

- 词嵌 入的质量非常依赖于上下文窗口大小的选择

- 有研究者关注如何利用已有的知识库来改进词嵌入模型,结合知识图谱 和未标注语料在同一语义空间中来联合学习知识和词的向量表示,这样可以更有效地实现词 的嵌入

- 句子表示:

- 很多任务的输入是变长的文本序列,需要将变长的文本序列表示成固定长度的向量

- 句子编码主要研究如何有效地从词嵌入通过不同 方式的组合得到句子表示

- 神经词袋模型:

- 简单对文本序列中每个词嵌入进行平均,作为整个序列的表示

- 缺点:丢失了词序信息

- 对于长文本,神经词袋模型比较有效。但是对于短文本, 神经词袋模型很难捕获语义组合信息

- 递归神经网络(Recursive Neural Network):

- 按照一个给定的外部拓扑 结构(比如成分句法树),不断递归得到整个序列的表示

- 缺点:需要 给定一个拓扑结构来确定词和词之间的依赖关系,因此限制其使用范围

- 循环神经网络(Recurrent Neural Network):将文本序列看作时间序列,不 断更新,最后得到整个序列的表示

- 卷积神经网络(Convolutional Neural Network):”通过多个卷积层和子采样 层,最终得到一个固定长度的向量。

- 改进:

- 综合这些方法的优点,结合具体的任务,已 经 提出了一些更复杂的组合模型, 例如 双向循环神经 网络 ( Bi-directional Recurrent Neural Network)、长短时记忆模型(Long-Short Term Memory)等。

- 比如近几年大热的Attention机制、Transformer以及Bert模型

- 篇章表示:

- 思想:层次化的方法,先得到句子编码,然后以句子编码为输入,进一步得到篇章的表示

- 层次化CNN:用卷积神经网络对每个句子进行建模,然后以 句子为单位再进行一次卷积和池化操作,得到篇章表示

- 层次化RNN:用循环神经网络对每个句子进行建模,然后再用一个循环神经网络建模以句子为单位的序列,得到篇章表示

- 混合模型:先用循环神经网络对每个句子进行建模,然后以句子为单位再进行 一次卷积和池化操作,得到篇章表示

- 循环神经网络因为非常适合处理文本 序列,因此被广泛应用在很多自然语言处理任务上。

- 词表示:Word embeddings:

- 连续表示:

文章来源地址https://www.toymoban.com/news/detail-498110.html

文章来源:https://www.toymoban.com/news/detail-498110.html

到了这里,关于语言认知模型--的学习笔记的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!