在计算机视觉中,参数更新是指通过使用梯度信息来调整神经网络模型中的参数,从而逐步优化模型的性能。参数更新的作用、原理和意义如下:

1. 作用:

- 改进模型性能:参数更新可以使模型更好地适应训练数据,提高模型的预测准确性。

- 减小损失函数:通过调整参数,可以使模型的损失函数逐渐减小,从而提高模型的性能。

2. 原理:

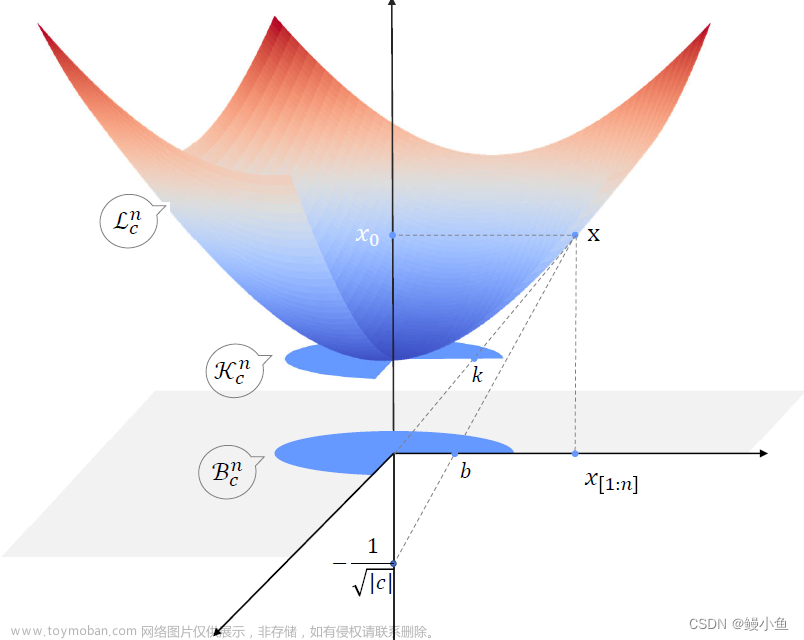

- 梯度下降法:参数更新通常使用梯度下降法,它基于损失函数的梯度信息来确定参数更新的方向和幅度。梯度表示了损失函数关于参数的变化率,通过将参数沿着梯度的反方向进行微调,可以逐步降低损失函数的值。

- 学习率:在参数更新中,学习率是一个重要的超参数,它控制了参数更新的步长。较大的学习率可能导致参数更新过大,导致模型发散;较小的学习率可能导致参数更新过慢,无法收敛到最优解。

3. 意义:

- 模型优化:参数更新是优化模型的关键步骤,通过反复迭代更新模型的参数,可以逐渐降低损失函数,提高模型的性能。

- 模型泛化:通过在训练集上优化参数,模型可以更好地适应新的未见数据,并具备更好的泛化能力。

- 适应数据分布:参数更新使得模型能够适应训练数据的分布特征,从而更好地捕捉数据的统计规律。

从数学角度解释,参数更新的过程可以使用以下数学公式表示:

其中,表示第t次迭代的参数,

表示学习率,

表示损失函数关于参数的梯度。

通过PyTorch框架,可以很方便地实现参数更新。以下是一个示例代码,演示了如何使用随机梯度下降(SGD)优化器进行参数

更新:文章来源:https://www.toymoban.com/news/detail-499097.html

import torch

import torch.nn as nn

import torch.optim as optim

# 定义模型

model = nn.Linear(10, 2)

# 定义损失函数

criterion = nn.CrossEntropyLoss()

# 定义优化器

optimizer = optim.SGD(model.parameters(), lr=0.01)

# 输入数据和标签

inputs = torch.randn(32, 10)

labels = torch.randint(0, 2, (32,))

# 前向传播

outputs = model(inputs)

# 计算损失

loss = criterion(outputs, labels)

# 梯度清零

optimizer.zero_grad()

# 反向传播

loss.backward()

# 参数更新

optimizer.step()

在上述代码中,通过定义模型、损失函数和优化器,并使用backward()方法计算梯度,然后使用step()方法更新参数。这样就实现了模型参数的更新过程。文章来源地址https://www.toymoban.com/news/detail-499097.html

到了这里,关于神经网络:参数更新的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!