源码地址:https://github.com/lllyasviel/ControlNet | 最新版本 controlnet-v1.1论文地址:2302.Adding Conditional Control to Text-to-Image Diffusion Models

扩展UI地址(需先安装sd-webui):https://github.com/Mikubill/sd-webui-controlnet

相关博文

- 相关博文- stable-diffusion-webui的基础功能手动安装,了解代码结构、依赖、模型出处

- stable-diffusion 训练GUI安装——lora、dreambooth

- stable-diffusion-webui安装(2):扩展模块extensions——汉化、双语等

一、controlnet-v1.1 能做什么?

包含14个模型(11个成熟模型,3个实验)

1.1 图片-深度图-重绘-模型(ControlNet 1.1 Depth)

对应模型与配置(两个都要存在):

control_v11f1p_sd15_depth.pth

control_v11f1p_sd15_depth.yaml

内置的3种预处理器(Preprocessors)生成深度图:

Depth_Midas

Depth_Leres

Depth_Zoe

也可以直接从rendering engines 到处的深度图(depth)

下图来源于官方git (题词为):

a handsome man

1.2 图片-Bae’s的正则化图-重构

Model file: control_v11p_sd15_normalbae.pth

Config file: control_v11p_sd15_normalbae.yaml

Acceptable Preprocessors: Normal BAE.

This model can accept normal maps fromrendering enginesas long as the normal map follows ScanNet’s protocol

题词

random seed 12345

(“a man made of flowers”):

1.3 图像-candy边缘-重构 (Canny)

对应模型与配置

control_v11p_sd15_canny.pth

control_v11p_sd15_canny.yaml

1.4 图片-MLSD直线检测-重绘

control_v11p_sd15_mlsd.pth

control_v11p_sd15_mlsd.yaml

Preprocessors: MLSD.

1.5 图片-线稿-重绘

模型

Model file: control_v11p_sd15_scribble.pth

Config file: control_v11p_sd15_scribble.yaml

输入

真实图片 (选择内置)处理器

- Scribble_HED,

- Scribble_PIDI

自己手绘(hand-drawn )

, “the beautiful landscape”):

1.6 图像-平滑线稿-重绘

Acceptable Preprocessors:

SoftEdge_PIDI,

SoftEdge_PIDI_safe,

SoftEdge_HED,

SoftEdge_HED_safe.

1.7 图片-语义分割图-重绘

相当于1.0版本支持150种颜色,本版本支持182 coco颜色

模型与配置

Model file: control_v11p_sd15_seg.pth

Config file: control_v11p_sd15_seg.yaml

1.8 图片-人体(手)关键点-重绘

Model file: control_v11p_sd15_openpose.pth

Config file: control_v11p_sd15_openpose.yaml

几种使用组合(普通关键点、人脸关键点、手指关键点)

Openpose body

Openpose hand

Openpose face

Openpose body + Openpose hand

Openpose body + Openpose face

Openpose hand + Openpose face

Openpose body + Openpose hand + Openpose face

上面的组合太复杂了,建议使用下面2种

“Openpose” = Openpose body

“Openpose Full” = Openpose body + Openpose hand + Openpose face

单人姿态迁移

全部

1.9 图片-详细线稿(Lineart)-重绘

Model file: control_v11p_sd15_lineart.pth

Config file: control_v11p_sd15_lineart.yaml

详细程度

简略

线稿上色感

1.10 动漫线稿上色-anime lineart

*1.11 图片-排布随机-重绘 Shuffle(实验行功能)

Model file: control_v11e_sd15_shuffle.pth

Config file: control_v11e_sd15_shuffle.yaml

生成人物

配合mul-contolnet

1.12 Instruct Pix2Pix (实验性功能)

Model file: control_v11e_sd15_ip2p.pth

Config file: control_v11e_sd15_ip2p.yaml

基于instrcuct pix2pix的数据集训练的

1.13 对原图进行修复(Inpaint)

Model file: control_v11p_sd15_inpaint.pth

Config file: control_v11p_sd15_inpaint.yaml

Model file: control_v11f1e_sd15_tile.pth

Config file: control_v11f1e_sd15_tile.yaml

1.14 图片细节重构(Tile)

Model file: control_v11f1e_sd15_tile.pth

Config file: control_v11f1e_sd15_tile.yaml

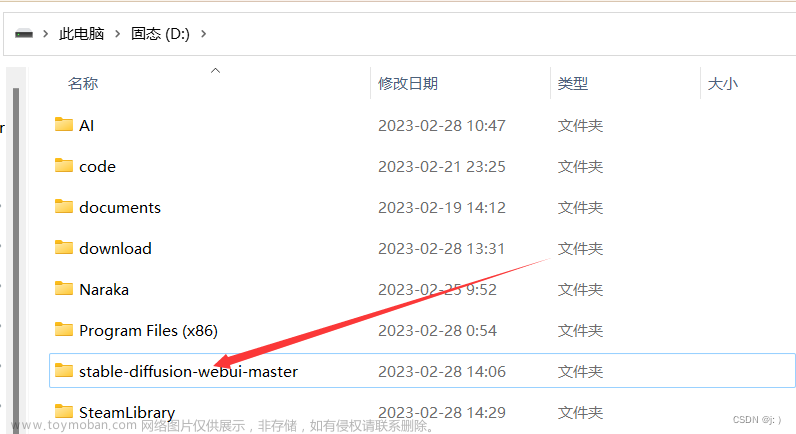

安装

本机安装

服务器安装方法文章来源:https://www.toymoban.com/news/detail-499340.html

git clone https://github.com/Mikubill/sd-webui-controlnet

git clone https://github.com/fkunn1326/openpose-editor.git

附录

论文以及原理

2302.Adding Conditional Control to Text-to-Image Diffusion Models 文章来源地址https://www.toymoban.com/news/detail-499340.html

文章来源地址https://www.toymoban.com/news/detail-499340.html

到了这里,关于stable-diffusion-webui的介绍与使用——Controlnet1.1的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!