2022年11月,智能对话机器人模型ChatGPT上线,其连续对话能力、强大的理解力、回答的准确度和创造性使其迅速走红。数据显示,ChatGPT发布短短两个月时间,全球用户数便突破1亿。

可以说,这项火遍全球的突破性人工智能对话技术,为整个科技行业带来了全新的想象力。而在国内,由百度打造的首个“类ChatGPT”——百度文心一言(ERNIE Bot)也即将在今年3月呈现,这是先进的人工智能对话技术在国内数字化领域中的首次大规模落地尝试,其价值无疑深远而重大。

值得一提的是,紫光股份旗下新华三集团日前也宣布正式成为百度文心一言的首批生态合作伙伴。接下来,双方将会把领先的智能对话技术成果应用在数字化领域,深度赋能百行百业的数字化转型和智能化升级。

回头来看,新华三之所以能够成为百度文心一言的首批生态合作伙伴,无疑是其长期在ICT基础设施领域深厚技术沉淀和释放的一种体现,而这背后也让整个产业看到了新的可能——那就是站在企业数字化转型和智能化升级的重要关口,新华三以其智算基础架构构筑的超大模型底座,无疑可以为百行百业创造出更多具有想象空间的新业态、新服务和新模式,让智能化的大潮 “普惠”每一家企业和每一个个人,释放智能化生产力的“乘数效应”。

新华三牵手百度文心一言背后

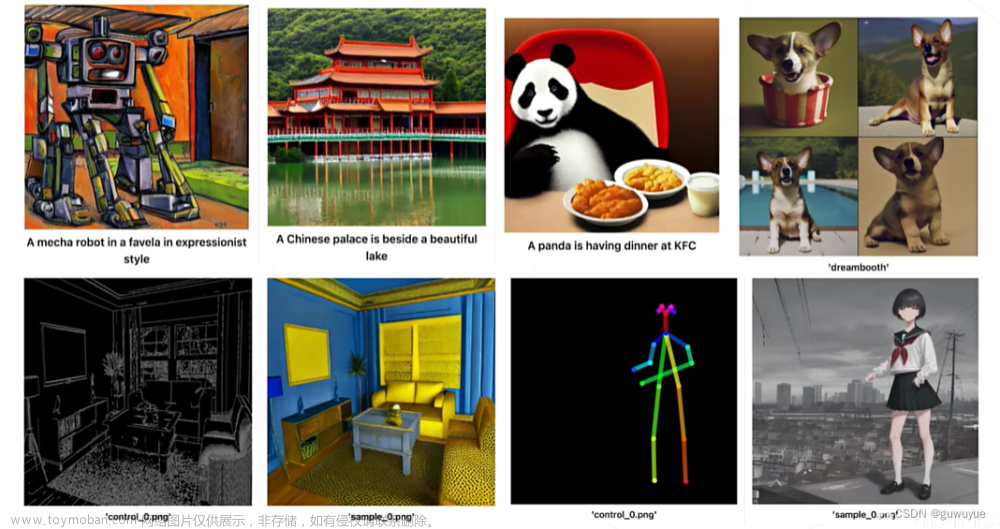

目前,以ChatGPT为代表的AIGC内容生成方式通过学习人类的思考方式,查阅、挖掘大量素材,以低边际成本、少人力限制等高效率的方式生成大量满足人们差异化需求的内容。

文心一言,正是百度基于文心大模型技术推出的生成式AI产品。作为国内少有的拥有大模型技术的企业,百度在人工智能领域深耕十余年,拥有产业级知识增强文心大模型ERNIE,具备跨模态、跨语言的深度语义理解与生成能力,而这种能力,也在搜索问答、云计算、内容创作生成、智能办公等众多领域具有较大的“用武之地”。

而本次新华三之所以率先成为百度文心一言的首批生态合作伙伴,其实也在“情理之中”。据了解,新华三与百度的合作有着长久的历史积淀,双方在ICT基础设施优化升级、百度智能云建设、信息检索、自动驾驶、生态建设等众多领域均有研发级别的合作,目前相关成果已广泛落地,对双方的产品技术发展产生了积极而深远的影响。

而展望未来,新华三也将继续携手百度,为智能交通、自动驾驶、智慧城市、智慧医疗、智慧教育、智慧金融、多域互联等领域推出更多场景化解决方案,开拓内容生态和智能服务领域的全新可能性,全面引领数字化时代的产业变革与升级。

以智算架构构筑超大模型底座

接下来要追问的是,为什么是新华三能够率先成为百度文心一言的首批生态合作伙伴呢?其实,要回答这一问题,就不得不提到类似ChatGPT和百度文心一言这样的AI基础模型(基于大规模数据集和大规模算力训练的大型预训练模型),要训练出这样的超大基础模型,往往是需要多方面的关键技术作为支撑的——除了大模型算法、分布式训练系统、高质量数据集的相关工具等,对计算、网络、存储等基础设施做出了巨大挑战。

例如,训练大模型首先就需要大规模算力资源做支撑;同时大型训练对显存以及数据集缓存要求同样很高,训练过程中还会面临显存墙问题(模型是否能跑起来)以及计算/通信墙问题(能否在合理时间内完成训练);此外,大模型的训练同样对网络也提出了更高的要求,即需高性能网络满足节点间参数同步,且GPU服务器节点间需要高速网络来实现模型训练参数交换和存取等等。

正是由于大模型的训练对存储、计算、网络等各个层面都提出了比较严苛的要求,长期深耕ICT领域的新华三,也基于自身在存储、计算、网络等领域深厚的技术积淀,打造出了一套全新的智算基础架构,该架构分为两大区域,即智算训练区和智算推理区,由此能够为大模型的训练提供强大的技术底座能力,具体来看:

一是,在训练集群方面,目前大模型的训练使用的服务器通常都是搭载NVIDIA NVLink GPU模块作为标准机,而新华三能够提供H3C UniServer R5500 G5这样机型,其搭载了NVIDIA GPU模块,能够支持英特尔Whitley平台和AMD Milan平台,最大支持2颗Icelake(40C、270W)或2颗Milan(64C、280W)的CPU,存储方面能够最大支持12个U.2 NVMe SSD,其中8个支持GDS(GDS, GPU Direct Storage),可以最大化地满足训练集群的算力需求。

不仅如此,在2023年初,新华三还发布了搭载NVIDIA 全新NVLink模块的新一代机型R5500 G6,支持英特尔EGS和AMD Genoa平台,PCIe 5.0及400GE网络的加持,也能够给大模型的训练带来更高的算力提升。

另外,一些大型互联网公司还会使用自研GPU Box搭配计算节点的方式组建训练集群,GPU Box里面会搭载NVIDIA NVLink GPU模块或其他厂商的OAM模组,而OAM是开源的GPU模块,由OCP社区服务器项目组下的OAI小组开发并制定标准。在这方面,新华三也是OAI2.0规范制定的重要参与者,后续在R5500 G6上,新华三也可支持不同厂家GPU的OAM模组。

二是,在推理集群方面,GPU推理集群的规模主要取决于业务预期的QPS并发需求,一般会多机多卡多实例部署。同样,新华三也提供了相关的产品以满足实际的业务需求,以H3C UniServer R5300 G5为例,其最大支持2颗英特尔Icelake(40C、270W)CPU,并可搭配多厂家多种类型的GPU产品,包括GPU、XPU、NPU等。

而在大规模推理场景下,新华三 UniServer R5300 G5也支持多种类型的GPU方案,包括4 PCIe GPU方案、8 PCIe GPU方案和16 PCIe GPU方案,以应对不同客户不同算力的推理集群搭建需求。此外,在去年11月份,新华三还发布了基于AMD Genoa平台的GPU服务器R5350 G6,可实现90%的CPU性能提升和50%的内核数量提升,应该说多种类型人工智能加速卡的支持,可以帮助客户应对人工智能不同场景下对异构算力的需求。

三是,高性能存储和网络也是大模型训练的重要组成部分。其中,高性能存储一般采用分布式并行文件存储,而新华三CX系列存储,就采用了全对称分布式架构,可结合IBM Spectrum Scale,为客户提供高带宽、低延时的存储服务。

以新华三CX5036为例,配置2颗5218 CPU、4块1T NVMe和32块6T SATA HDD,4节点集群部署,测试大文件小IO(4KB)平均单节点IOPS可达2.55W(随机读)、2.36W(随机写),多客户端并发(16MB)平均单节点带宽可达3.57GB/s(顺序读)、2.08GB/s(顺序写),单客户端单流16MB IO聚合带宽可达5.45GB/s、1MB IO聚合带宽3.7GB/s。

高性能网络方面,通常有两种网络搭建方式:第一种是RoCE网络,作为互联网400G领域的市场领头羊,基于新华三提供的S9825/S9855交换机配合AI ECN方案,也可以迅速搭建大模型训练所需的高性能网络。与此同时,随着大模型训练所需网络带宽的不断提升,网络主芯片性能也会迅速增加,当800G/1.6T时代来临时,CPO/NPO交换机将会登上互联网舞台,在这方面新华三也提前做了布局,其S9825-32D32DO交换机,同时支持32个400G光模块接口和32个400G光引擎接口,后续可以平滑升级至51.2T平台;第二种方式是DDC方案,DDC网络架构(分布式分解结构)可以很轻易解决负载均衡和阻塞问题,同时也能实现更优的网络性能和更快的网络收敛。在这方面,新华三的DDC方案也在进行相关验证中。

由此可见,从新华三智算基础架构的技术细节中,可以看到新华三以智算基础架构为超大模型训练构筑了坚实的底座,不仅能够为包括AIGC为代表的超大模型提供关键技术支撑,同时也是新华三率先成为百度文心一言的首批生态合作伙伴的关键所在。

释放智能化生产力“乘数效应”

客观地说,智能化已经成为了当下中国产业升级和企业数字化转型中的新动能和驱动力。特别是由于线上线下生态及场景远比其他国家丰富、多元,中国经济中结构性的差异,以及细分行业中不同的应用场景需求,都给了基于AIGC为代表的新技术的创新以巨大的想象力,而新华三以智算架构构筑的超大模型底座,不仅可以帮助企业借助AIGC提升效率,创造新价值,持续推动产业智能化的升级,同时也让AI真正“扎根”百行百业奠定了关键基础,背后更体现出了全新的价值,可以从两个方面来做观察:

一方面,是为AI超大模型的训练提供了坚实的技术支撑。随着关键技术与基础理论不断突破,大算力、大数据、大模型将成为未来AI发展的重点发展方向,由此带动自然语言处理、翻译模型、生成算法和数据集等细分要素持续提升,推动产出的内容细节、类型更丰富、质量更高。

这背后显然离不开强大的算力和网络的支撑。而新华三打造的智算基础架构,基于新华三长期在ICT基础设施领域的沉淀,充分融合了其在计算、存储和网络等领域的优势,就切实地为超大模型训练提供了技术支撑。

在此基础上,新华三还积极坚持前沿技术创新,其中全面支持在网计算的H3C P4可编程交换机,就能够支持Pytorch框架和DPDK UDP、RoCE通信方式,将数据需求聚合统一操作,优化通信网络拥堵,减少主机的数据处理量。据新华三内部实验室测算,使用H3C P4可编程交换机加速数据并行训练,模型训练精度不受影响,计算节点间通信数据量平均减少30%,最多可以减少48%的训练时间,可大幅提升分布式集群的整体训练效率,创造更加出色的应用价值。可以说在产品、技术和方案上的领先性,是新华三差异化的优势所在,更是其能够助力各类企业AIGC展开研发和推进的价值所在。

另一方面,新华三还正与产业各方积极合作,探索新范式和新路径,推动普惠算力更为广泛地落地,使能百行百业的智能化升级,共同推进中国人工智能产业的发展。

这方面,新华三率先成为百度文心一言首批生态合作伙伴就是具体的印证。众所周知,今天AI正在极大改变人们的生活方式,目前也正在开始加速渗透到企业的研发设计、生产制造、供应链管理、客户服务等各个环节,深刻改变着人们的生产方式。

因此,以提升效率和优化配置为核心主题的AI应用和创新,是数字经济深化发展的全新阶段,更是传统产业转型升级的必然要求。在这种大背景下,新华三和包括百度在内的产业合作伙伴通力合作,并通过旗下丰富的产品和解决方案为百行百业的用户注入云原生及人工智能技术,也能加速整个行业的智能化升级,释放智能化生产力“乘数效应”。

总的来说,中国产业智能化的转型升级,中国数字经济的落地和发展,任重而道远。在此过程中,新华三以全新的智算架构支撑超大模型训练,并与产业合作伙伴深度合作,让AIGC这样的新技术能够加速行业落地的步伐,而这种创新力、前瞻力和爆发力,相信也将能够推动中国的人工智能产业呈现出“百花齐放”的状态,更能够提速整个行业智能化时代的到来,这不仅是未来的趋势所在,也是新华三不断创新与突破的重要体现。

文章来源:https://www.toymoban.com/news/detail-500497.html

文章来源:https://www.toymoban.com/news/detail-500497.html

申耀的科技观察,由资深科技媒体人申斯基创办,20年企业级科技内容传播工作经验,长期专注产业互联网、企业数字化、ICT基础设施、汽车科技等内容的观察和思考。文章来源地址https://www.toymoban.com/news/detail-500497.html

到了这里,关于【观察】抢先入局AIGC,新华三底层能力何在?的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!