在计算机视觉中,激活函数是神经网络中的一种非线性函数,用于引入非线性变换和非线性特性到网络中。激活函数的作用、原理和意义如下:

1. 引入非线性变换:

神经网络的线性组合层(如卷积层和全连接层)只能表示线性关系,而计算机视觉任务通常涉及到复杂的非线性问题,如图像的边缘、纹理、形状等特征。激活函数通过对输入进行非线性变换,使网络能够学习和表示更加复杂的函数关系。

2. 增加网络的表达能力:

线性函数的组合仍然是线性函数,无法表示复杂的非线性关系。激活函数的引入扩展了网络的表达能力,使神经网络能够对输入数据进行非线性映射和特征提取,从而更好地捕捉和表示输入数据的复杂性。

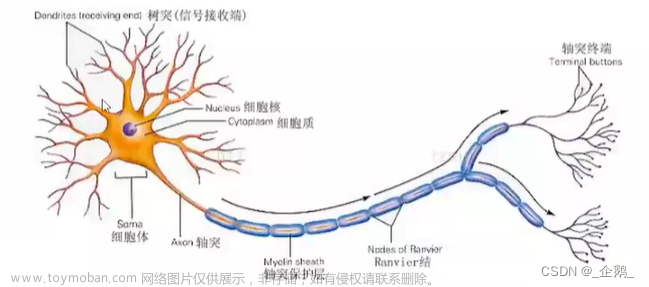

3. 激活神经元:

激活函数的名称来源于它对神经元的激活过程。激活函数接收神经元的输入信号,通过非线性变换产生输出,从而决定神经元是否激活并传递信号给下一层。通过激活函数的作用,神经网络可以在不同层之间建立复杂的连接和信息传递。

4. 解决线性不可分问题:

计算机视觉中的很多任务,如图像分类、目标检测和图像分割,涉及到非线性的决策边界。激活函数的引入使得神经网络可以学习和表示这些非线性边界,从而提高了模型的分类性能和准确度。

从数学原理的角度来看,激活函数通过对输入进行非线性变换,引入非线性性质到神经网络中。这是因为线性函数的组合仍然是线性函数,无法表示复杂的非线性关系。激活函数通过增加非线性变换,使得神经网络能够学习和表示更加复杂的函数关系,提高模型的拟合能力和表达能力。

总之,激活函数在计算机视觉中的作用、原理和意义是通过引入非线性变换,增加网络的表达能力,激活神经元并解决线性不可分问题,使神经网络能够更好地适应和处理复杂的视觉任务。不同的激活函数具有不同的特性和优缺点,需要结合具体任务和网络结构进行选择和调整。

常见的激活函数包括:

1. Sigmoid函数:

- 公式:f(x) = 1 / (1 + exp(-x))

- 优点:输出值范围在(0, 1)之间,可以用作二分类问题的激活函数。

- 缺点:Sigmoid函数在输入较大或较小的情况下,梯度接近于0,导致梯度消失问题。

2. Tanh函数:

- 公式:f(x) = (exp(x) - exp(-x)) / (exp(x) + exp(-x))

- 优点:输出值范围在(-1, 1)之间,相对于Sigmoid函数具有更大的动态范围。

- 缺点:仍然存在梯度消失问题。

3. ReLU函数(Rectified Linear Unit):

- 公式:f(x) = max(0, x)

- 优点:计算简单,能够在输入为正时保持梯度,有效解决梯度消失问题。

- 缺点:在输入为负时,梯度为0,导致神经元无法更新。

4. LeakyReLU函数:

- 公式:f(x) = max(ax, x),其中a为小于1的超参数

- 优点:在输入为负时引入了一个小的斜率,解决了ReLU函数的负值问题。

- 缺点:相对于ReLU函数计算略复杂。

5. ELU函数(Exponential Linear Unit):

- 公式: f(x) = x (if x > 0), f(x) = a * (exp(x) - 1) (if x <= 0,其中a为小于1的超参数)

- 优点:在输入为负时引入了一个负饱和度,解决了ReLU函数的负值问题。

- 缺点:计算较复杂。

下面是使用PyTorch绘制激活函数的图像和相应的代码示例:

import torch

import torch.nn.functional as F

import matplotlib.pyplot as plt

import numpy as np

x = torch.linspace(-5, 5, 100)

y_sigmoid = torch.sigmoid(x)

y_tanh = torch.tanh(x)

y_relu = F.relu(x)

y_leaky_relu = F.leaky_relu(x, negative_slope=0.2)

y_elu = F.elu(x, alpha=1.0)

plt.figure(figsize=(10, 6))

plt.plot(x.numpy(), y_sigmoid.numpy(), label='Sigmoid')

plt.plot(x.numpy(), y_tanh.numpy(), label='Tanh')

plt.plot(x.numpy(), y_relu.numpy(), label='ReLU')

plt.plot(x.numpy(), y_leaky_relu.numpy(), label='LeakyReLU')

plt.plot(x.numpy(), y_elu.numpy(), label='ELU')

plt.legend()

plt.xlabel('x')

plt.ylabel('f(x)')

plt.title('Activation Functions')

plt.grid(True)

plt.show()

运行上述代码将绘制出激活函数的图像,可视化它们的形状和特点。请注意,PyTorch中的激活函数可以通过torch.nn.functional模块中的函数调用来实现。

下面是在PyTorch框架中使用这些激活函数的代码示例:文章来源:https://www.toymoban.com/news/detail-500957.html

import torch

import torch.nn as nn

# 创建一个带有激活函数的模型

class MyModel(nn.Module):

def __init__(self):

super(MyModel, self).__init__()

self.fc = nn.Linear(10, 5) # 全连接层

self.sigmoid = nn.Sigmoid() # Sigmoid激活函数

self.tanh = nn.Tanh() # Tanh激活函数

self.relu = nn.ReLU() # ReLU激活函数

self.leaky_relu = nn.LeakyReLU(negative_slope=0.2) # LeakyReLU激活函数

self.elu = nn.ELU(alpha=1.0) # ELU激活函数

def forward(self, x):

x = self.fc(x)

x = self.sigmoid(x)

x = self.tanh(x)

x = self.relu(x)

x = self.leaky_relu(x)

x = self.elu(x)

return x

# 创建一个输入张量

input_tensor = torch.randn(1, 10)

# 实例化模型并进行前向传播

model = MyModel()

output = model(input_tensor)

print(output)

以上代码展示了如何在PyTorch中使用不同的激活函数。您可以根据实际需求选择适合的激活函数来构建您的模型。文章来源地址https://www.toymoban.com/news/detail-500957.html

到了这里,关于神经网络:激活函数的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!