概要

提示:文章写完后,目录可以自动生成,如何生成可参考右边的帮助文档

前言

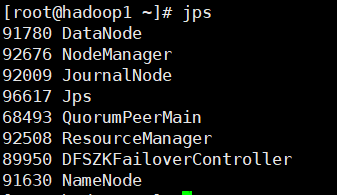

基於Hadoop HA 在kerberos中配置datax

目的是基於HAODOP HA集群在kerberos中配置datax,配置分為兩個步驟進行:

1.基於HADOOP HA 搭建datax

2.在1的基礎上,在kerberos中配置datax

一、基於HADOOP HA 搭建datax

1.解壓官網下載的datax

2.將hadoop中的配置文件:core-site.xml hdfs-site.xml 和hive中的hive-site.xml這個三個文件放入到datax中的hdfswriter和hdfsreader中

二、基於HADOOP HA 配置好的datax去配置kerberos

這裡有兩種方案:

1.在datax的配置文件中進行配置

在datax的配置文件中,添加如下內容,這裡添加的是hdfs的kerberos認證

"haveKerberos": true,

"kerberosKeytabFilePath": "/etc/security/keytab/hdfs.keytab",

"kerberosPrincipal": "hdfs/hadoop@EXAMPLE.COM"

2.在shell腳本中加入認證語句

1.在各节点创建hive用户,如已存在则跳过

[root@hadoop102 ~]# useradd hive -g hadoop

[root@hadoop102 ~]# echo hive | passwd --stdin hive

2.为hive用户创建Keberos主体

1)创建主体

[root@hadoop102 ~]# kadmin -padmin/admin -wNTVfPQY9kNs6 -q"addprinc -randkey hive"

2)生成keytab文件

[root@hadoop102 ~]# kadmin -padmin/admin -wNTVfPQY9kNs6 -q"xst -k /etc/security/keytab/hive.keytab hive"

3)修改keytab文件所有者和访问权限

[root@hadoop102 ~]# chown hive:hadoop /etc/security/keytab/hive.keytab

[root@hadoop102 ~]# chmod 440 /etc/security/keytab/hive.keytab

4)分发keytab文件

[root@hadoop102 ~]# xsync /etc/security/keytab/hive.keytab

5)修改datax每日同步脚本,在顶部增加如下认证语句文章来源:https://www.toymoban.com/news/detail-501256.html

kinit -kt /etc/security/keytab/hive.keytab hive

总结

推薦第二種方式,非常的簡便,也非常的好用文章来源地址https://www.toymoban.com/news/detail-501256.html

到了这里,关于基於Hadoop HA 在kerberos中配置datax的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!